Exposición «60 años del chip de silicio: Los circuitos integrados que revolucionaron el mundo»

| RetroMañía 2021 | ||

| << RetroMañía 2021 | 2 of 17 | Charla «60 años rodeados de chips» >> |

Descripción de la exposición

|

Horario:

|

|

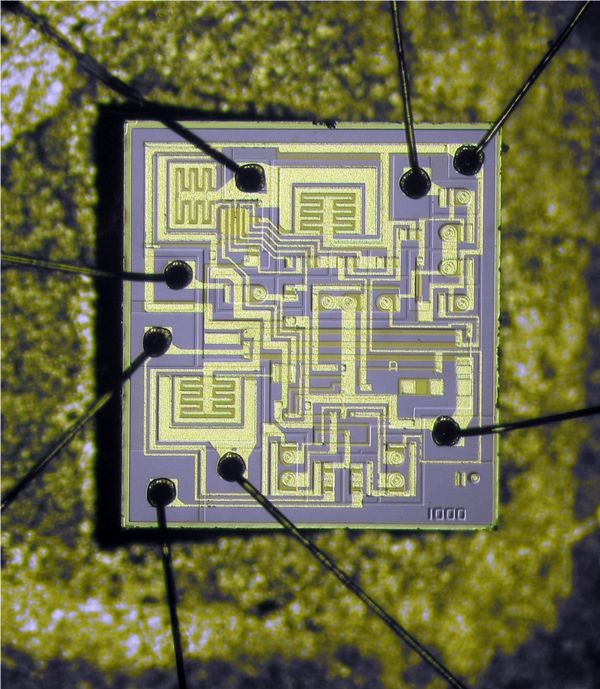

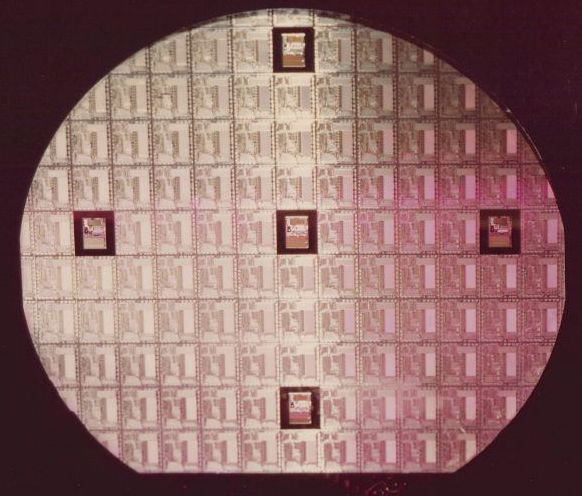

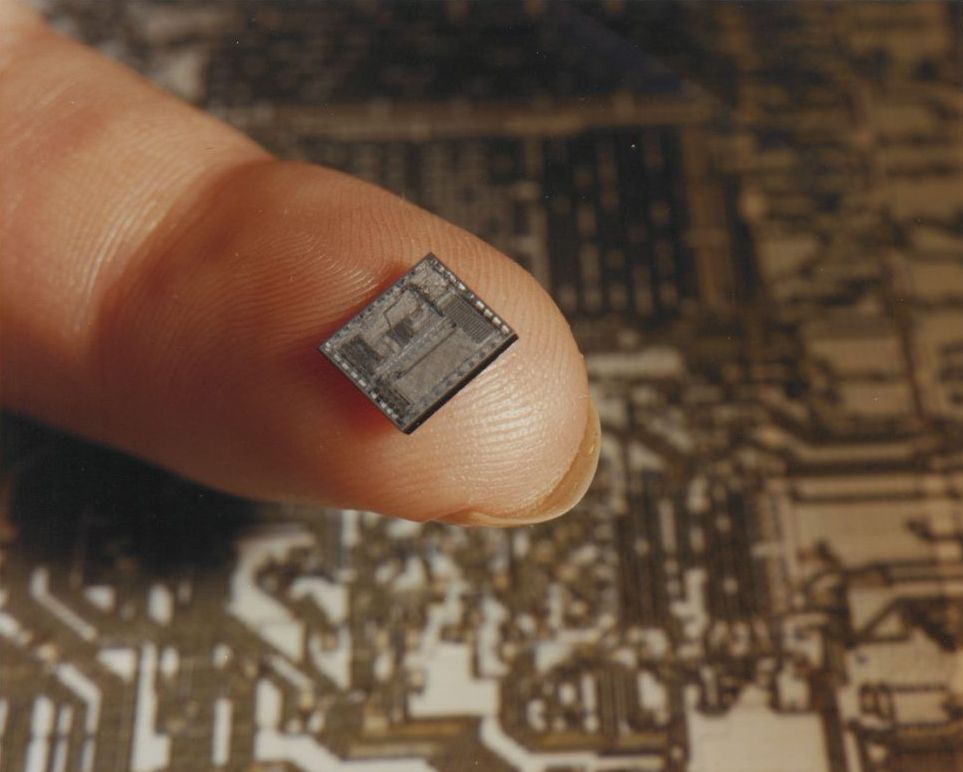

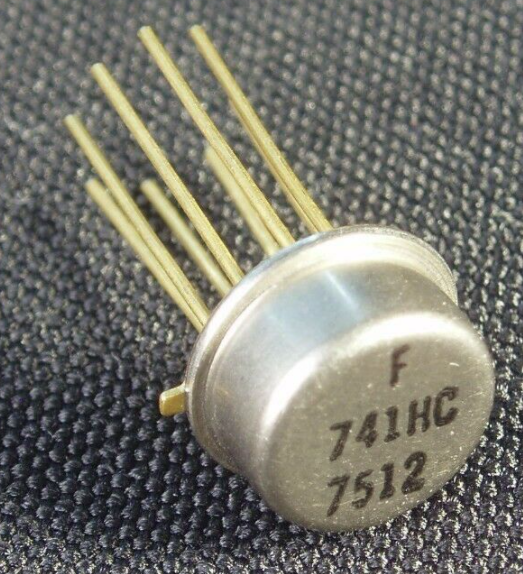

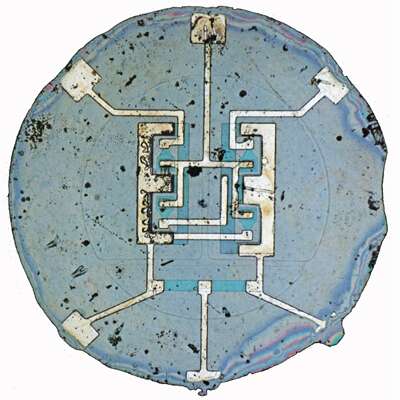

En 1958 Jack Kilby, de Texas Instruments, crea el primer circuito integrado con base de germanio, integrando un transistor, 3 resistencias, y un condensador. Sería el comienzo de la microelectrónica. El aspecto del circuito integrado era tan nimio, que se ganó el apodo inglés que se le da a los pedacitos de algo: chip. Sin embargo, este primer chip era híbrido: los componentes se separaban cortando el material y las conexiones entre ellos se resolvía añadiendo cables de oro. Esto sería resuelto por Robert Noyce, de Fairchild, en 1959, quien crea el primer circuito integrado monolítico de silicio que soluciona el problema de conexiones y separación de componentes que tenia el primer circuito integrado creado por Kilby. Desde entonces los chips siguieron el diseño de Noice y no el de Kilby, aunque el mérito debe recaer en ambos. Kilby ganaría el Premio Nobel en Física en 2000 y Robert Noyce fue uno de los tres fundadores de Intel en 1968, desde hace años el mayor fabricante de circuitos integrados del mundo. El 25 de abril de 1961 la patente del invento de Noyce quedaría registrada y ese mismo año, hace ahora 60, Fairchild lanza "Micrologic", la primera familia de chips comerciales. A partir de ahi los chips serían cada vez más potentes, más pequeños, más rápidos y más baratos provocando una revolución digital que poco a poco cambiaría el mundo para siempre.

La cada vez mayor capacidad de integración de transistores en estos chips de silicio ha permitido integrar desde decenas y centenares de transistores en los primeros años, a miles y millones en las décadas posteriores, llegando los últimos diseños de hoy en día a alcanzar las decenas de miles de millones de transistores en un chip. Por todo ello, desde su invención los chips y la capacidad de computación que aportan en muchos casos (en un espacio y necesitando una cantidad de energía practicamente despreciables) se encuentran presentes en practicamente todos los productos de hoy en día, desde los dispositivos eminentemente electrónico más evidentes, como ordenadores o smartphones, hasta prendas de vestir o semáforos; sin contar que un porcentaje muy alto de dichos productos simplemente no podrían existir sin estar basados en chips.

Hace algo más de 12 años, en mayo de 2009, la revista IEEE Spectrum publicó un artículo titulado "25 Microchips that Shook the World" donde recogían una lista, que no sigue ningún orden concreto, ni pretende ser exhaustiva, sino solamente centrarse en una muestra de algunos de los chips que, además de su éxito comercial, acabaron impactando enormenente, de una forma u otra, en el gran público.

En esta exposición virtual que pretende celebrar tan impactante invención seguiremos esa misma estrategia, basándonos en su lista de 25 chips (con títulos en azul) para mantener el mismo espíritu de reflejar aquellos chips, más o menos complejos (desde unos pocos transistores o puertas lógicas hasta los más complejos microprocesadores), más o menos recientes (desde los 70 hasta las últimas décadas), que realmente han tenido un impacto muy relevante en el gran público, aunque aportamos nuestro granito de arena (¿o deberíamos decir silicio?) añadiendo algunos otros chips que ayudan a entender el origen o impacto de algunos de ellos, además de incluir nuevos chips a la lista debido a su importancia, según nuestro propio criterio, hasta completar una selección de unos 50 chips. Nuestro agradecimiento a IEEE Spectrum por su artículo tan inspirador, y esperamos que disfruteis de esta exposición que esperamos en breve pueda verse en el MIH de forma real y no sólo virtual como ahora. ¡Ya nos diras cual es tu chip favorito!

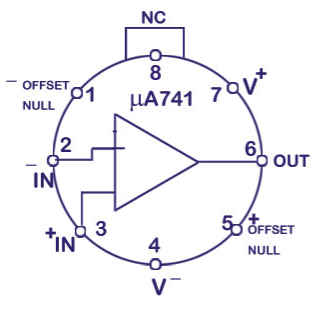

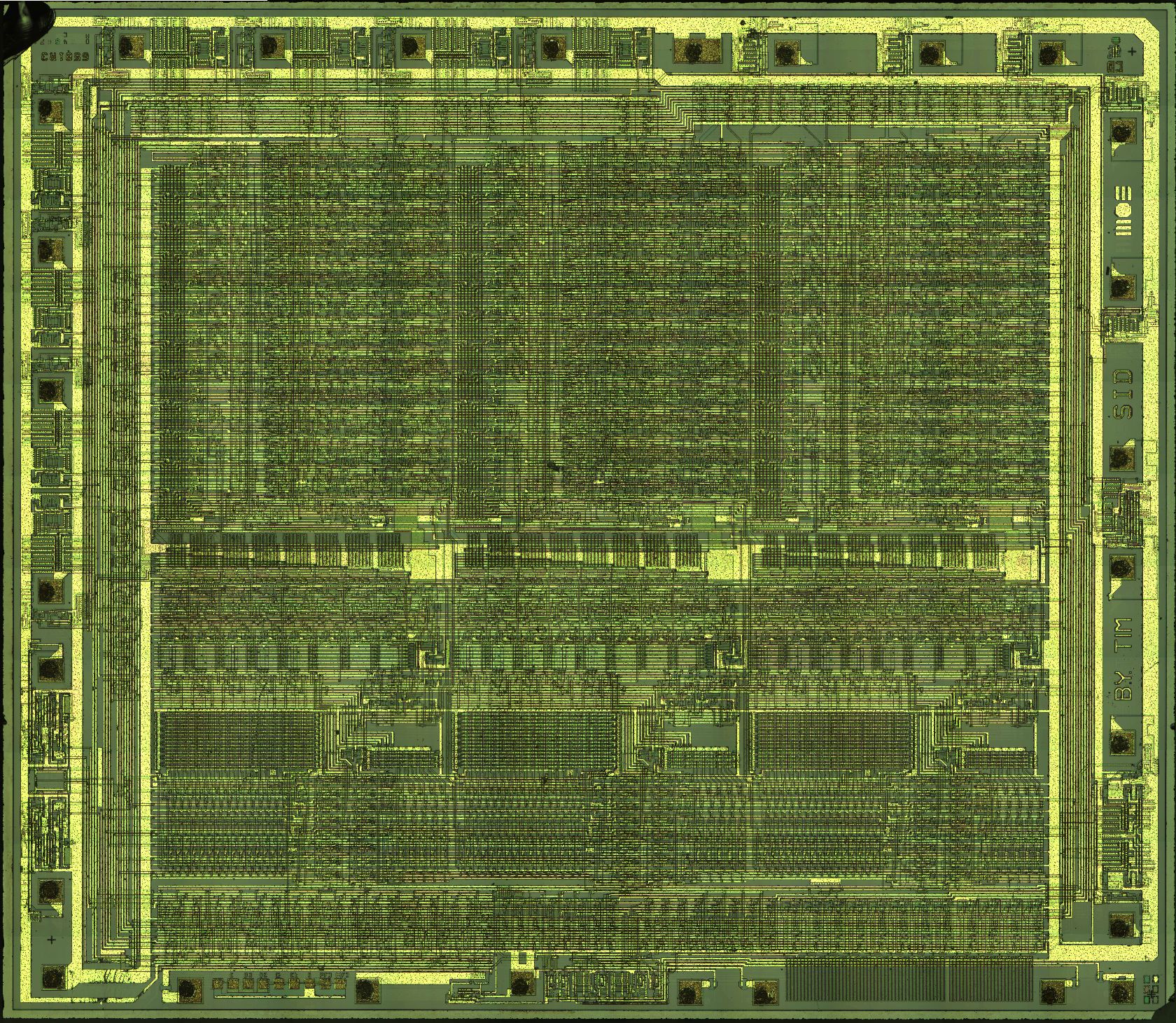

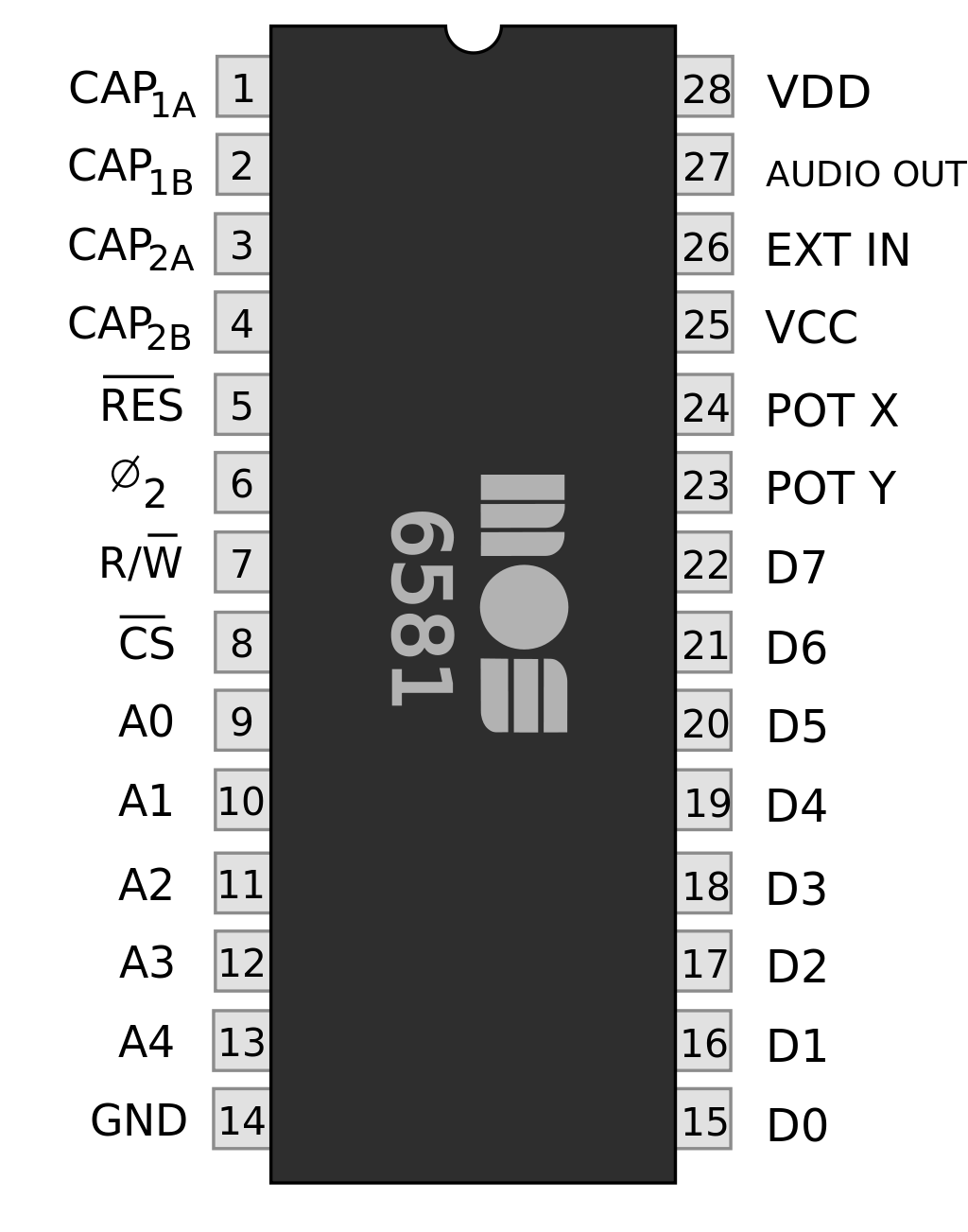

Chip de sonido MOS Technology 6581 (SID) (1982) |

|

|

Categoría: Amplificadores y audio |

El chip sintetizador que definió el sonido de toda una generación. 1982 fue un gran año para la música. No sólo Michael Jackson lanzó Thriller, el álbum más vendido de todos los tiempos, sino que Madonna hizo su debut. Y vio el lanzamiento del microordenador Commodore 64. Gracias al C64, millones de hogares disfrutaron de un sintetizador de sonido electrónico y programable, que todavía está de moda, el chip MOS 6581, también llamado SID (Sound Interface Device). La creación de este chip de sonido recayó en un joven ingeniero llamado Robert Yannes. Aunque existian algunos sintetizadores avanzados controlados por microordenador, la tecnología de generación de sonido incorporada en los ordenadores domésticos era relativamente rudimentaria. Yannes tenía mayores ambiciones. "Había trabajado con sintetizadores musicales y quería un chip que fuera un sintetizador de música". “El diseño real sólo tomó alrededor de cuatro o cinco meses”, dijo Yannes. Yannes incorporó registros de datos en el SID 6581 para que un programador pudiera definir una envolvente ADSR (cuatro etapas: ataque, decaimiento, sostenimiento, y relajación) y luego dejar que el chip controle la intensidad, en lugar de ajustar la intensidad programando la CPU para enviar comandos de control de volumen a medida que se reproducen las notas (algo que pocos programadores se atrevieron a intentar). El chip SID tiene tres canales de sonido que pueden reproducirse simultáneamente usando tres formas de onda básicas, además de un cuarto canal de "ruido blanco" que produce diversos ruidos y silbidos estáticos y aleatorios, dependiendo de la frecuencia. El chip tiene la capacidad de aplicar tres tipos de filtro de frecuencias de paso y resonancia configurables (algo nada habitual en otros chips de sonido) para modular los canales y producir una gama aún más amplia de sonidos. Algunos programadores descubrieron que podían conseguir que el chip hiciera cosas para las que nunca fue diseñado, como la síntesis de voz. Quizá el ejemplo más famoso de esto sea "Ghostbusters", un videojuego de 1984 basado en la película del mismo nombre, en el que el C64 pronunciaba (con una calidad baja) frases memorables de la película, como "He slimed me!" ("me ha moqueado"). Los desarrolladores comenzaron a contratar compositores para crear obras originales para los videojuegos del C64; de hecho, algunos títulos hoy se recuerdan únicamente por su buena banda sonora. Los "chiptunes" es un género de música original que se apoya en el sonido distintivo de los chips de sonido de los ordenadores y consolas de los años 80. Algunos compositores usan sintetizadores modernos programados para replicar ese sonido, pero a otros les gusta usar el hardware original, especialmente los chips SID (con o sin un C64). Debido a que el 6581 SID no ha estado en producción durante muchos años, esto ha generado un cotizado mercado de chips SID de segunda mano. Existen aplicaciones como Sidplay, que emula el chip SID, y puede reproducir datos musicales extraídos del software original. Incluso después de que el último chip SID finalmente se queme, su sonido seguirá vivo. |

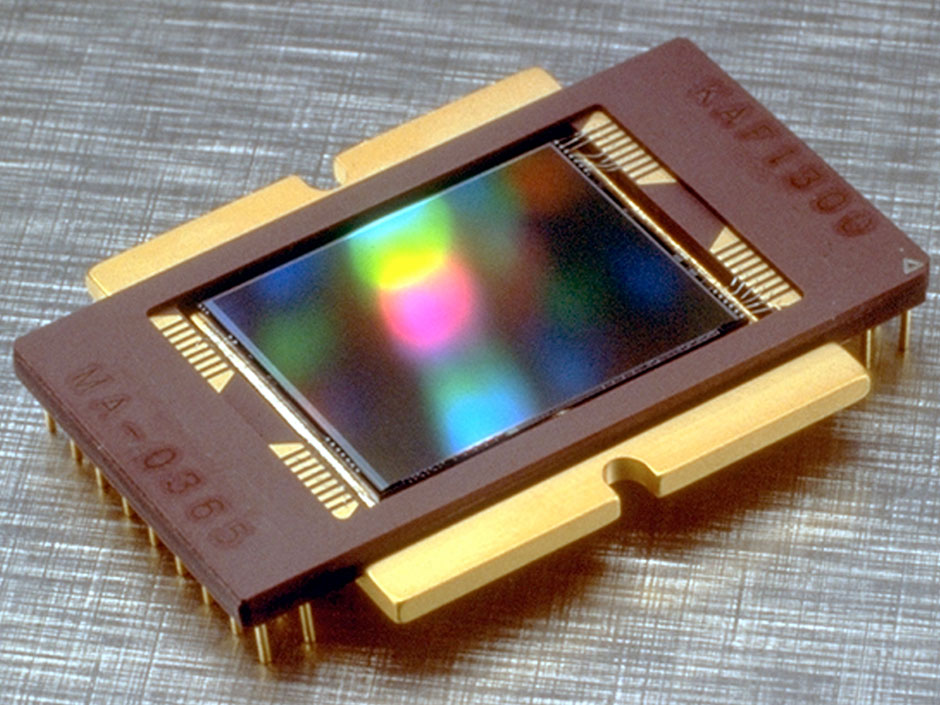

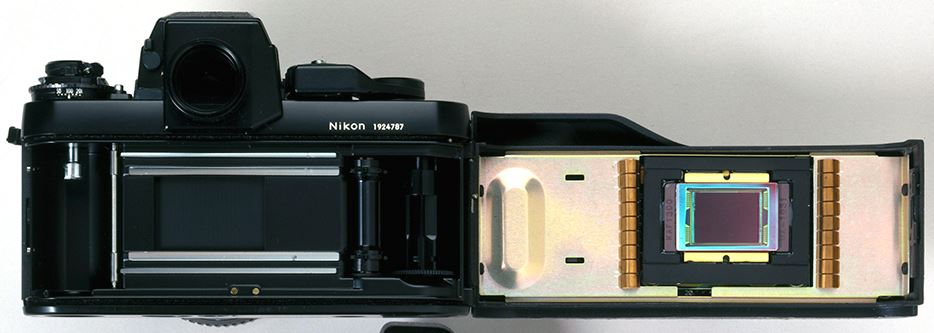

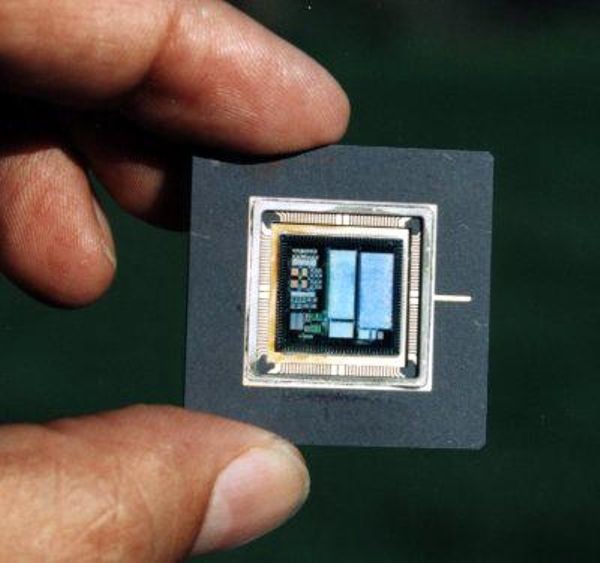

Sensor de imagen Kodak KAF-1300 (1986) |

|

|

Categoría: Sensores |

Kodak presentó en 1986 el KAF-1300, el primer CCD de fotograma completo de 1 megapíxel disponible comercialmente, el chip que llevaría a la fotografía digital fuera del laboratorio. Lanzada en 1991, la cámara digital Kodak DCS 100 costaba hasta $13.000 y requería una unidad externa de almacenamiento de datos de 5 kg que los usuarios tenían que llevar colgada del hombro. La imagen de una persona cargando dicho artilugio no era desde luego un momento Kodak. Aún así, los componentes electrónicos de la cámara, alojados dentro del cuerpo de una Nikon F3, incluían un hardware impresionante: un chip del tamaño de una uña que podía capturar imágenes con una resolución de 1,3 megapíxeles, suficiente para impresiones nítidas en papel fotográfico de 5 x 7 pulgadas. "En ese momento, 1 megapíxel era un número mágico", dice Eric Stevens, diseñador principal del chip, que aún trabaja para Kodak. El chip, un verdadero dispositivo de carga acoplada de dos fases, se convirtió en la base de los futuros sensores CCD, lo que ayudó a impulsar la revolución de la fotografía digital. Por cierto, ¿cuál fue la primera foto que se hizo con el KAF-1300? "Uh", dice Stevens, "simplemente apuntamos el sensor a la pared del laboratorio". |

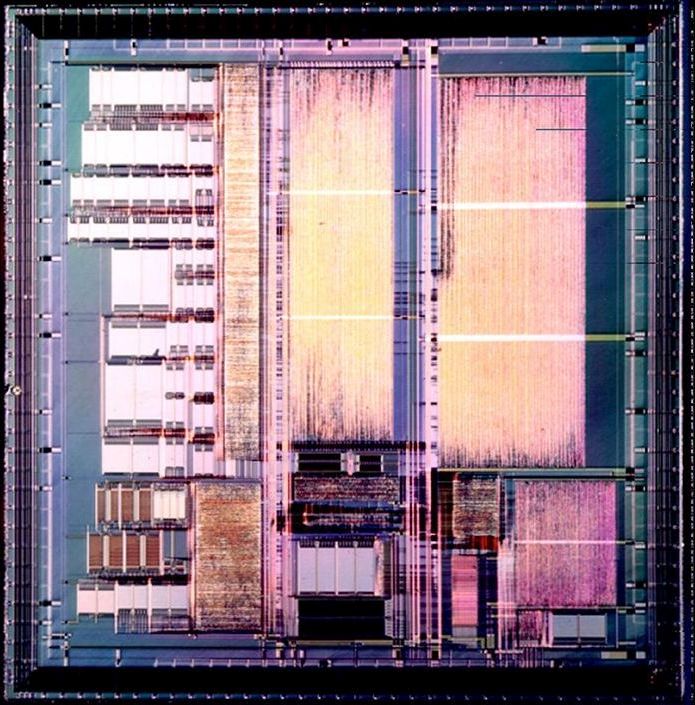

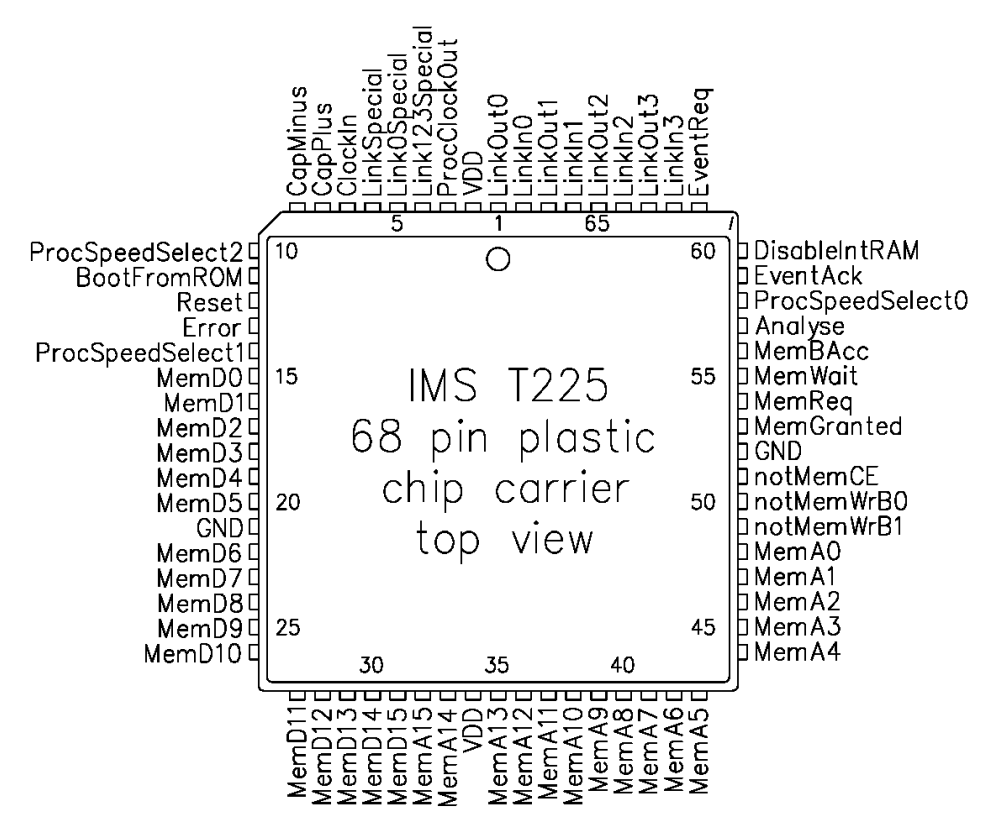

Inmos Transputer (1984) |

|

|

Categoría: Procesadores |

El primer microprocesador de propósito general diseñado específicamente para ser utilizado en sistemas de computación paralela. Esta arquitectura de microprocesador pionera de la década de 1980, con memoria integrada y enlaces de comunicación serie, estaba destinada a la computación en paralelo. El T212 de 16 bits fue el primero disponible en 1984, con velocidades del procesador entre 17,5 y 20 MHz. El T212 fue reemplazado por el T222, con una RAM integrada que pasaba de 2 a 4 KB y, más tarde, el T225. Tanto el T222 como el T225 funcionaron a 20 MHz. Más tarde se crearon nuevos transputers, de 32 bits. Durante algún tiempo, a finales de la década de 1980, muchos consideraron que el transputer sería el futuro de la Informática. Si bien Inmos y el transputer no lograron esta expectativa, la arquitectura del transputer fue muy influyente para generar nuevas ideas en la arquitectura de computadores, varias de las cuales han resurgido de diferentes formas en los sistemas modernos. Las supercomputadoras más poderosas del mundo son encarnaciones en el mundo real del sueño del transputer: son grandes conjuntos de SoC (Systems on a Chip) idénticos y de rendimiento relativamente bajo. |

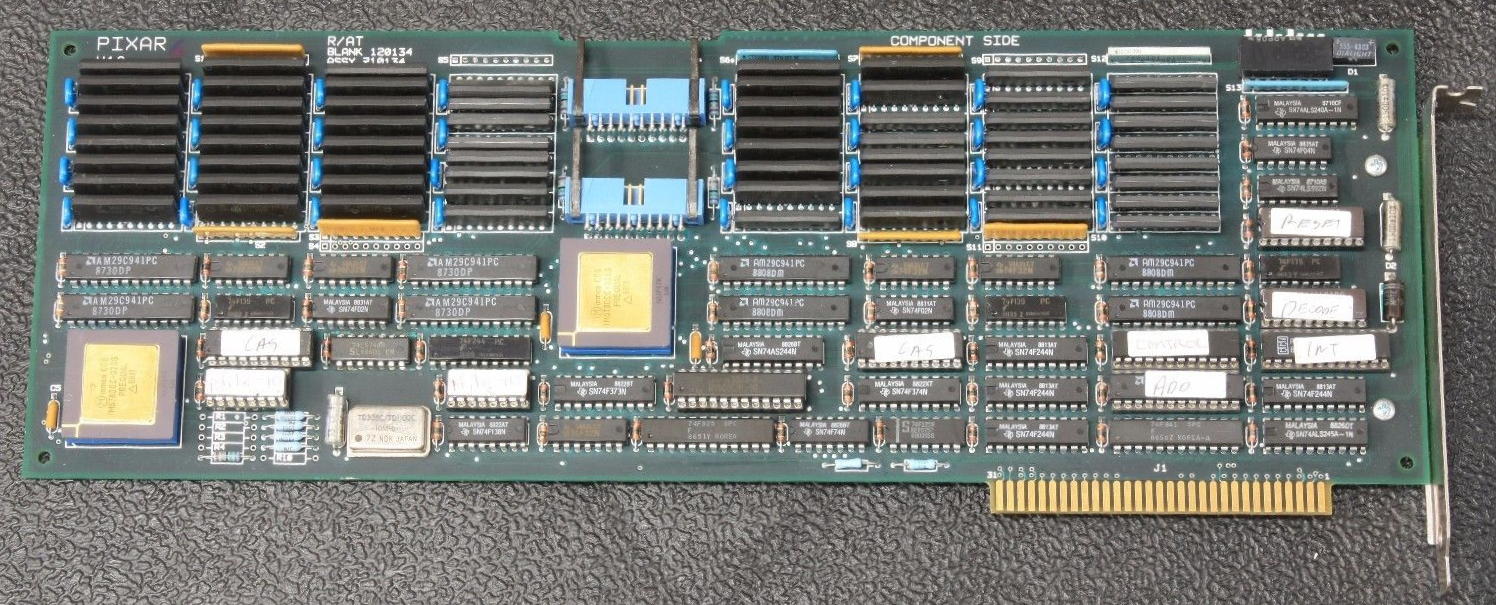

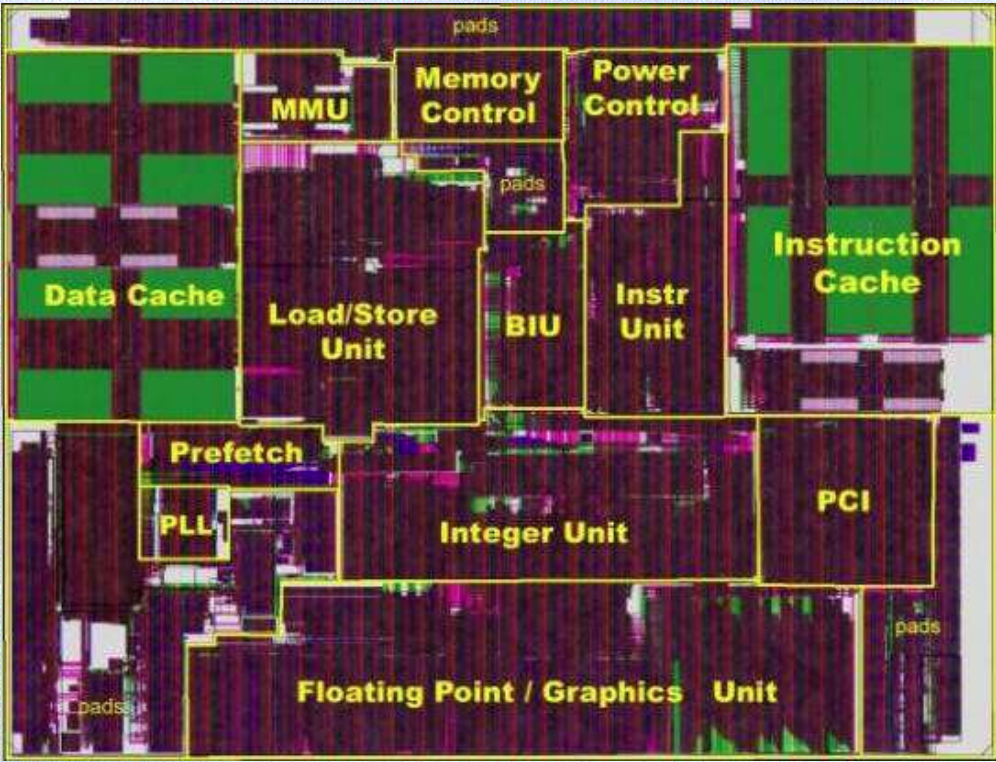

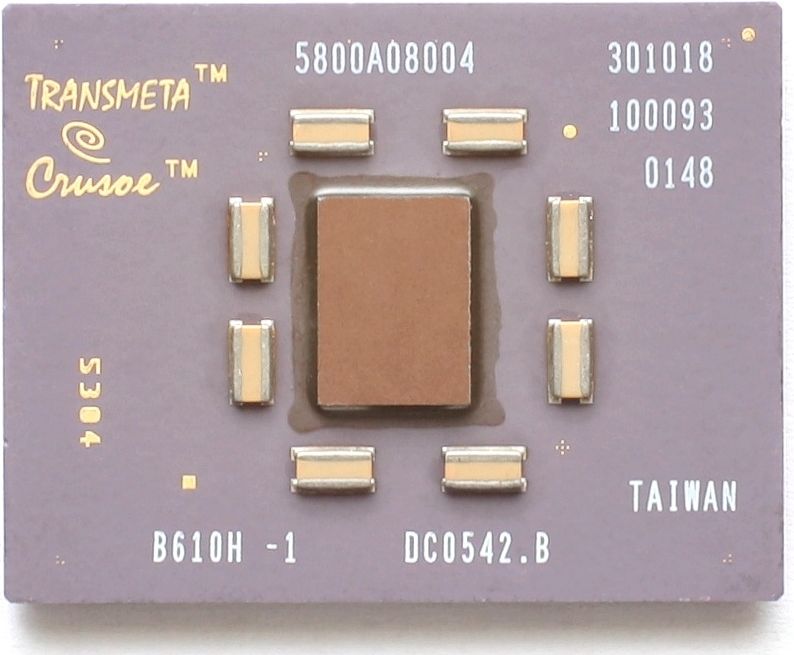

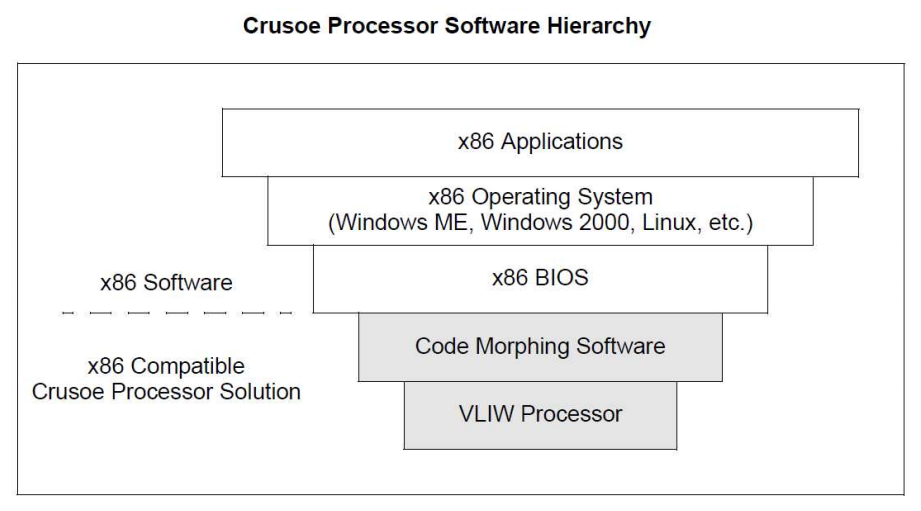

Procesador Transmeta Corp. Crusoe (2000) |

|

|

|

Adelantado a su tiempo, este chip anunció la era móvil en la que el uso de energía, y no la potencia de procesamiento, se convertiría en la característica más importante. Los procesadores Crusoe realizan mediante software algunas de las funciones clásicamente implementadas mediante hardware, como por ejemplo, la reordenación de instrucciones. Esto resulta en un hardware más simple y con menos transistores. La relativa simplicidad del hardware hace que el Crusoe consuma menos energía (y por tanto disipe menos calor) que otros procesadores compatibles x86 que trabajan a la misma frecuencia de reloj. Tener una gran potencia implica tener grandes disipadores de calor. Y por tanto una batería de corta duración... y un alto consumo de electricidad. De ahí el objetivo de Transmeta de diseñar un procesador de bajo consumo que avergonzaría a esos bicharracos que fabrican Intel y AMD. El plan: el software traduce las instrucciones x86 sobre la marcha en el propio código máquina de Crusoe, cuyo mayor nivel de paralelismo ahorra tiempo y energía. El Crusoe fue promocionado como la mejor idea desde el uso del silicio, y durante un tiempo lo fue. Crusoe y su sucesor, Efficeon, "demostraron que la traducción binaria dinámica era comercialmente viable", dice David Ditzel, cofundador de Transmeta. Desafortunadamente, agrega, los chips llegaron varios años antes de que despegara el mercado de los ordenadores de bajo consumo y estuvieron presentes en sólo unos pocos productos. Al final, si bien Transmeta no cumplió su promesa comercial, sí señaló el camino hacia un mundo en el que el uso de energía de un procesador era tan importante como su potencia bruta, y parte de la tecnología de Transmeta acabo implantándose en los chips de Intel, AMD y Nvidia. |

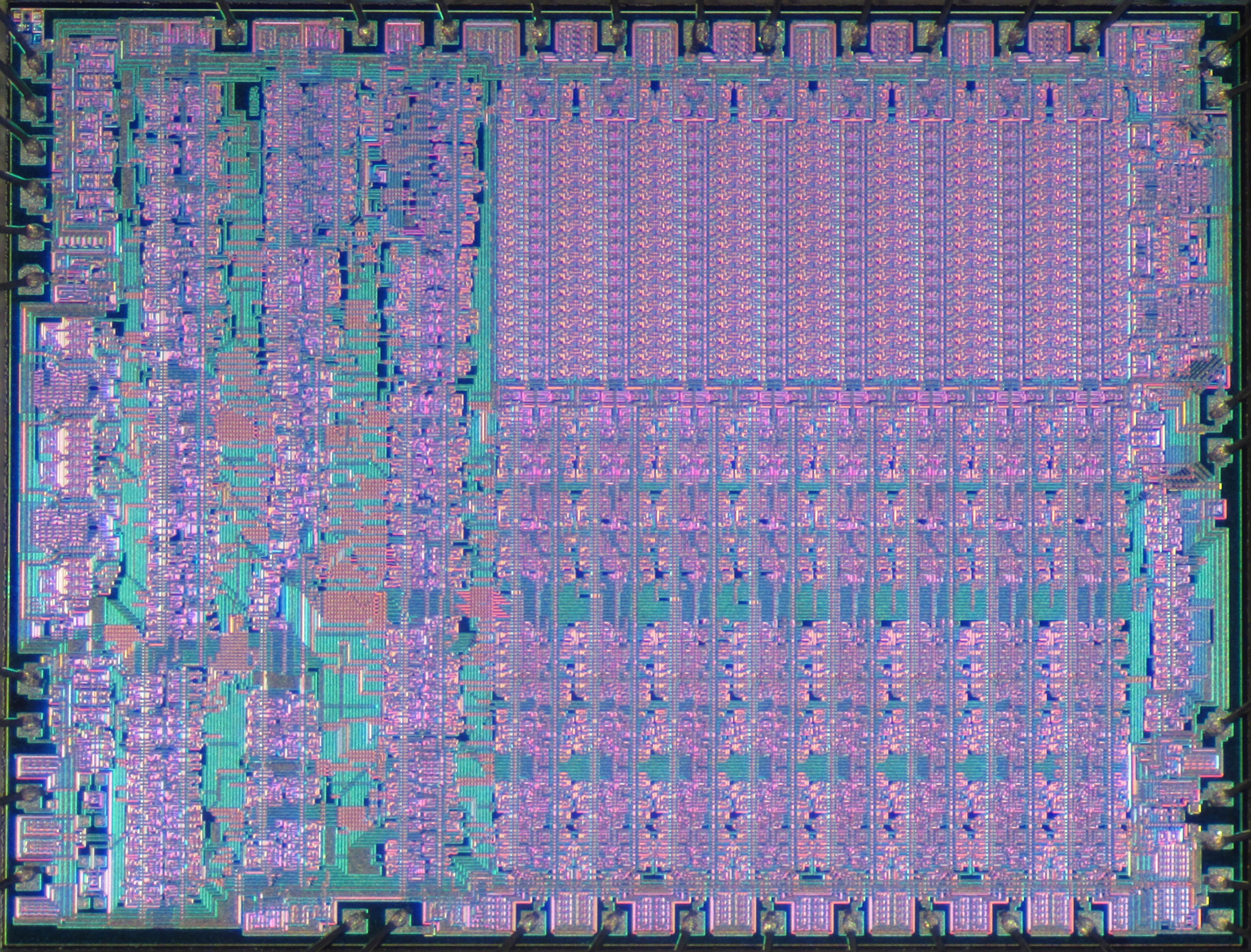

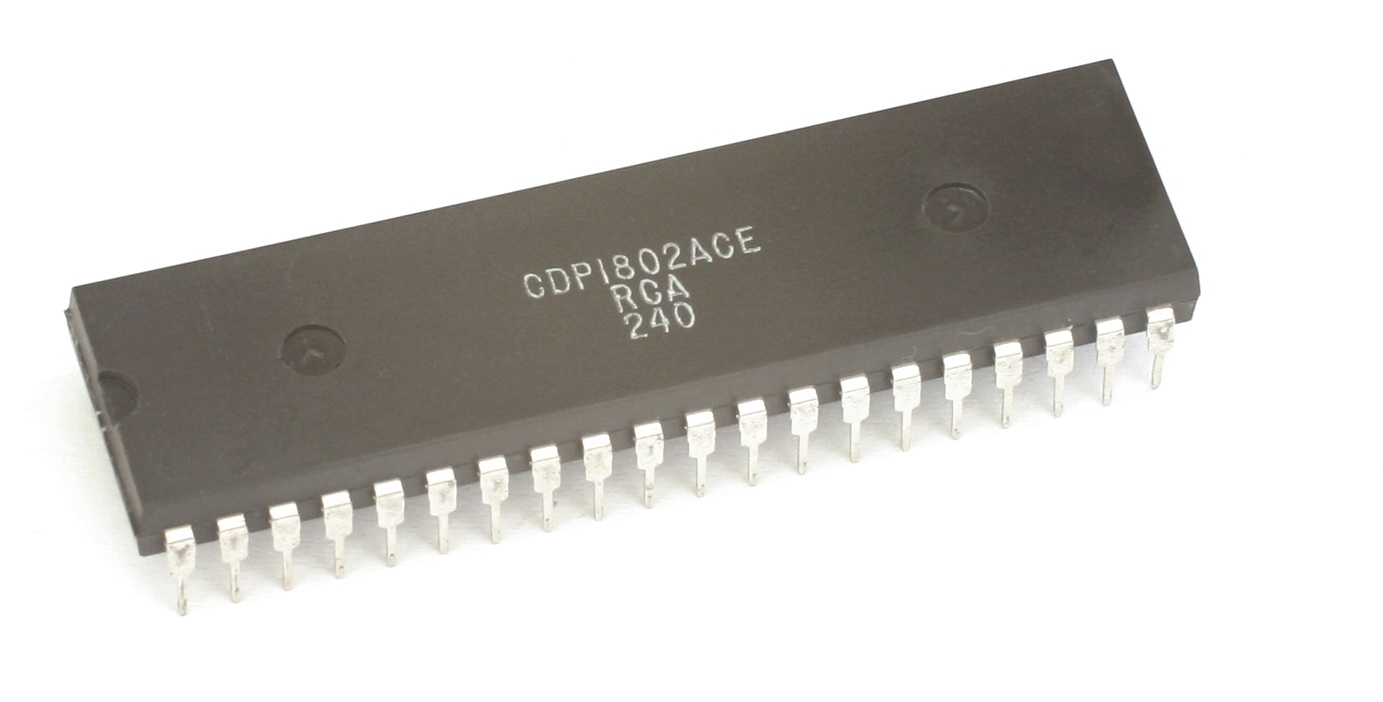

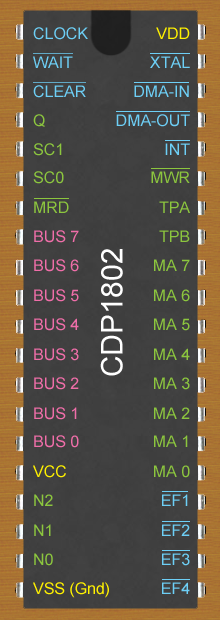

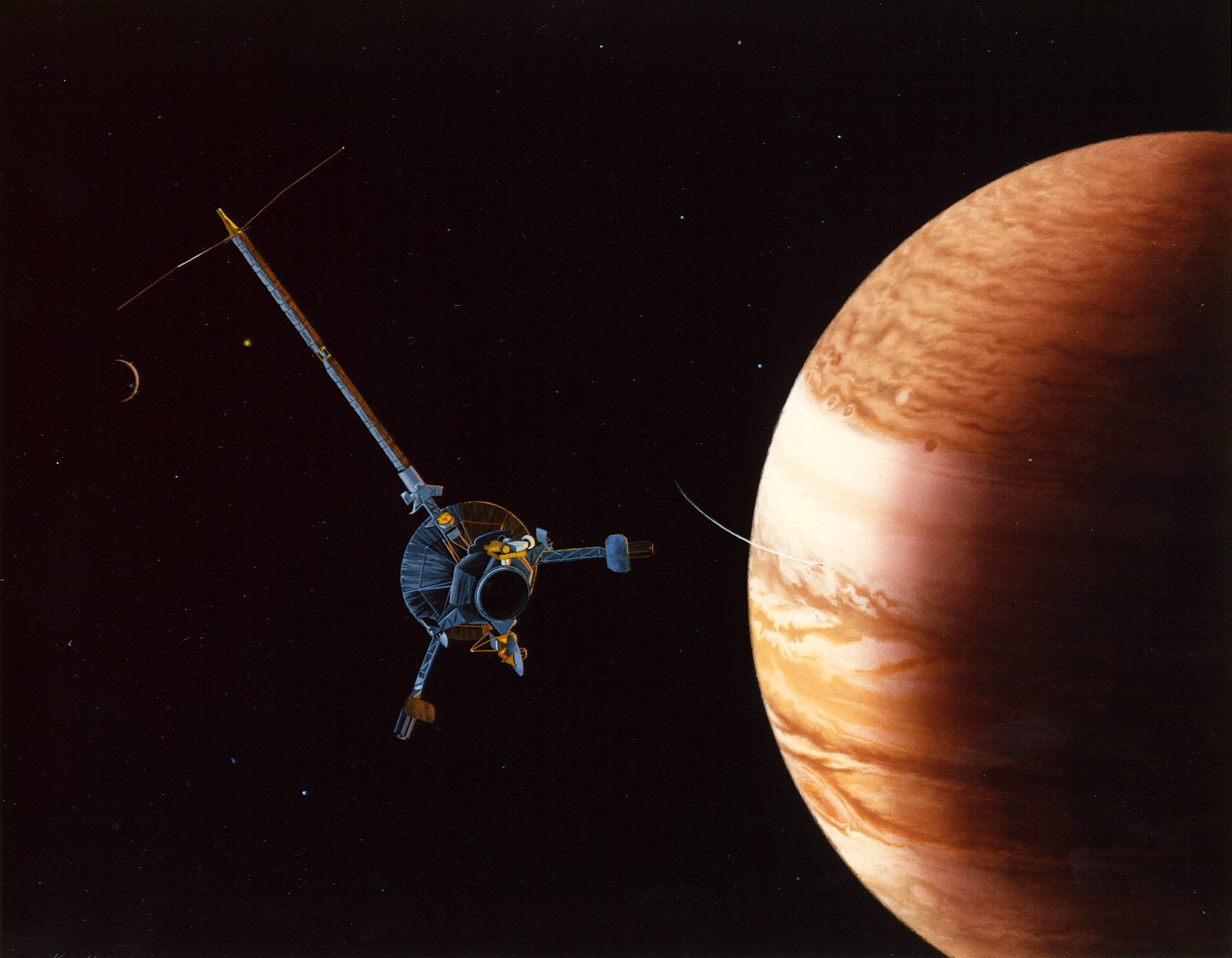

RCA CDP1802 COSMAC (1976) |

|

|

|

A pesar de una mala gestión, el primer microprocesador CMOS acabó llegando hasta Júpiter. Si RCA hubiera tomado decisiones diferentes en la década de 1970, el nombre de Joe Weisbecker podría ser tan reverenciado como lo es hoy el de Steve Wozniak. Weisbecker fue el arquitecto del microprocesador RCA CDP1802, también conocido como Cosmac, diseñado explícitamente pensando en el entorno doméstico, primando el bajo costo y flexibilidad. Y aunque perdió la oportunidad de entrar en ese gran mercado, el CDPCDP1802 encontró su camino en todo tipo de lugares, desde salas de conciertos hasta el sistema solar exterior. Para 1970, la industria se había dado cuenta de que tener más y más transistores en un chip iba a tener un gran impacto en la Informática, ya fuera en forma de calculadoras o de equipos de altas prestaciones. Pero la visión de Weisbecker era un sistema lo suficientemente potente como para entretener a una familia o ayudar a educar a un niño, pero sin la potencia demandada por los usuarios profesionales. Así, en octubre de 1971, Weisbecker había construido un prototipo de procesador completamente funcional a partir de 100 chips lógicos discretos. En un artículo de 1974, Weisbecker dijo: “Un ordenador de este tipo podría tener un gran valor social… permitiría, por primera vez, un acceso generalizado a los ordenadores". Esto fue tres años antes del debut de Apple II. El prototipo de Weisbecker convenció a RCA, y en 1976 debutó el CDP1802, siendo el primer procesador que se fabricó utilizando tecnología CMOS, una versión más avanzada de la tecnología MOS utilizada para fabricar chips como el Intel 4004, y que desde entonces es la forma dominante de fabricar procesadores al usar menos potencia. Cierto aspecto del CDP1802 lo hizo popular entre los diseñadores aeroespaciales: estaba disponible en una versión resistente a la radiación, lo que lo hacía ideal para el duro entorno del espacio. De hecho, se utilizaron seis 1802 como cerebros de la sonda Galileo, que se lanzó en 1989 (un año antes de la muerte de Weisbecker) y orbitó Júpiter entre 1995 y 2003. Podemos ciertamente decir que el diseño de Weisbecker llegó muy lejos. |

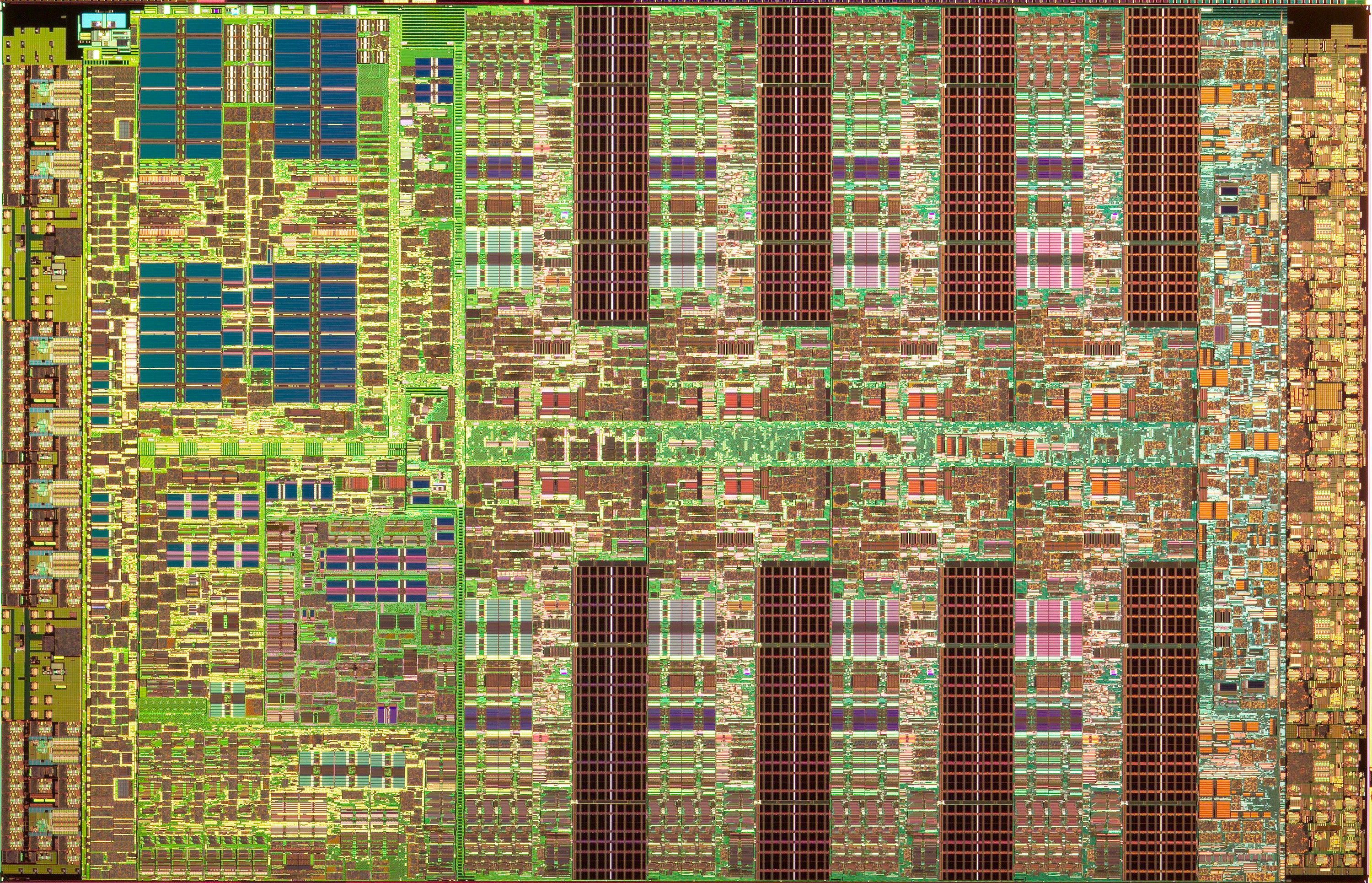

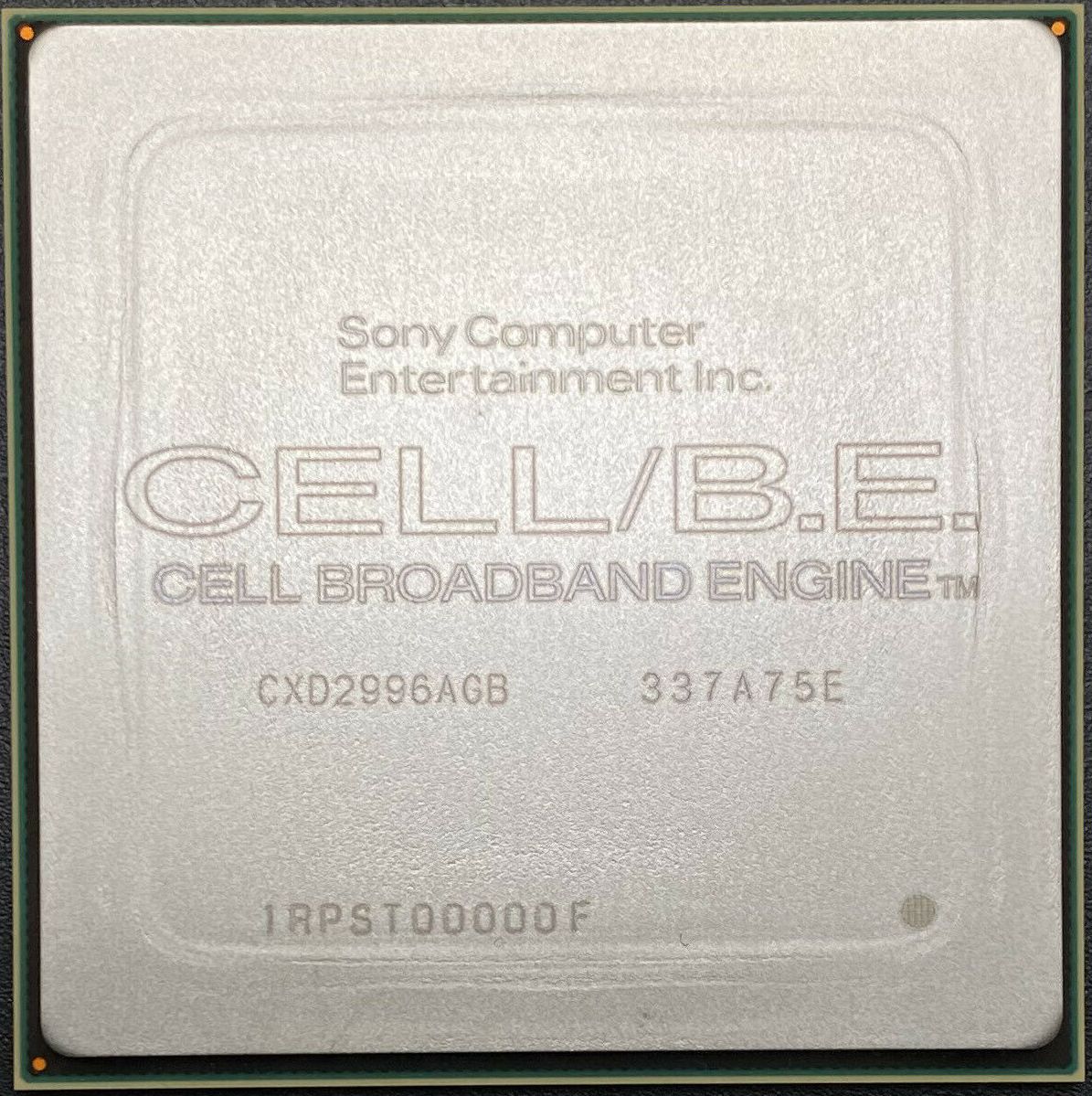

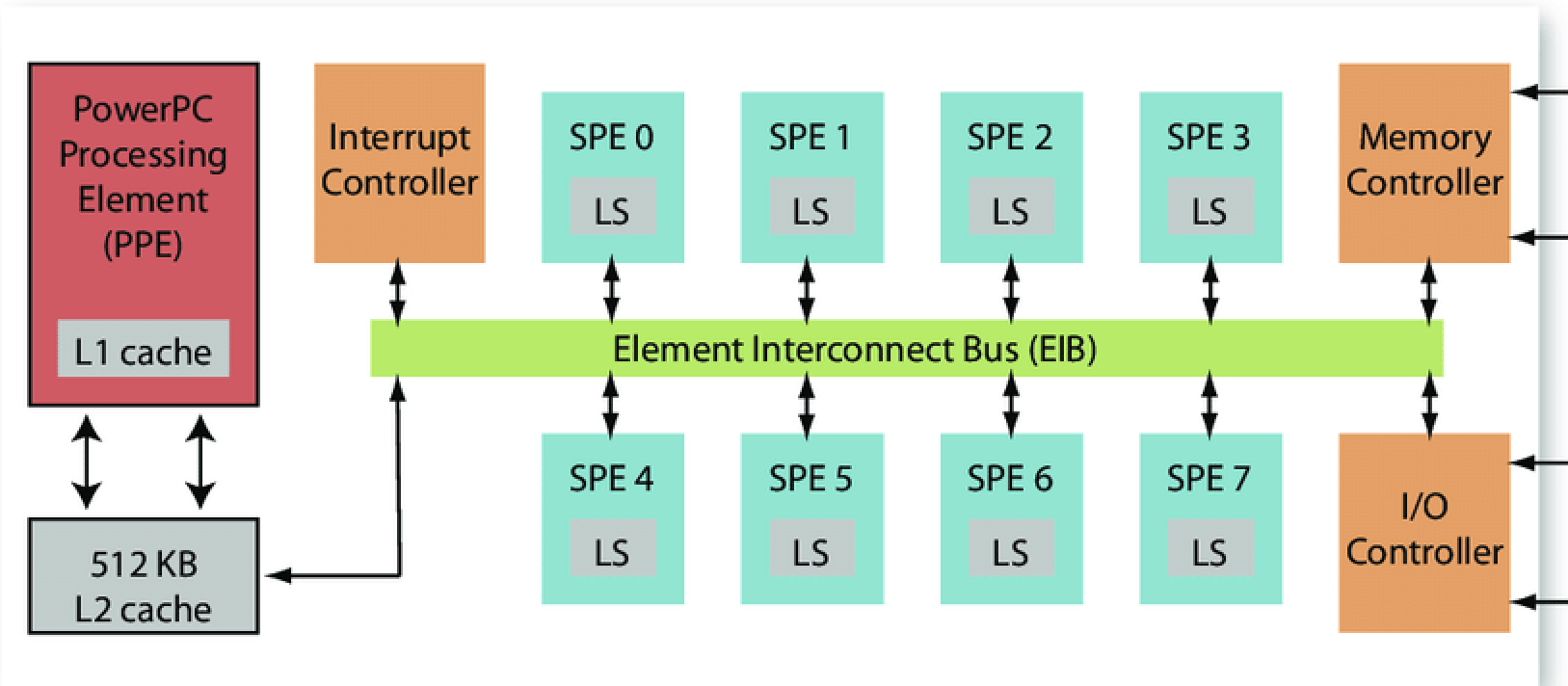

Procesador IBM/Sony/Toshiba Cell (2004) |

|

|

|

Toma una oblea de silicio, graba un procesador PowerPC, añadele ocho coprocesadores muy rápidos para cálculo numérico, y conecta todo a través de un bus de datos de 300 gigabits por segundo. El resultado es uno de los microprocesadores más radicales en la historia de los semiconductores: el Cell, desarrollado por IBM, Sony y Toshiba. Les costó 400 millones de dólares, 400 personas, y cuatro años lanzar el chip al mercado. Diseñado para alimentarse con una dieta a base de muchas operaciones de coma flotante de video MPEG en tiempo real, polígonos de juegos tridimensionales, y transformadas de Fourier, la primera gran aplicación comercial del Cell fue la videoconsola PlayStation 3 de Sony. También podemos encontrar este procesador en servidores de alta potencia y en superordenadores. Con una arquitectura asimétrica (dos tipos diferentes de procesadores), Cell alertó que la programación nunca volvería a ser la misma. Los informáticos y los programadores se apresuraron a encontrar formas de explotar todo su potencial. Años después, todavía lo están haciendo. |

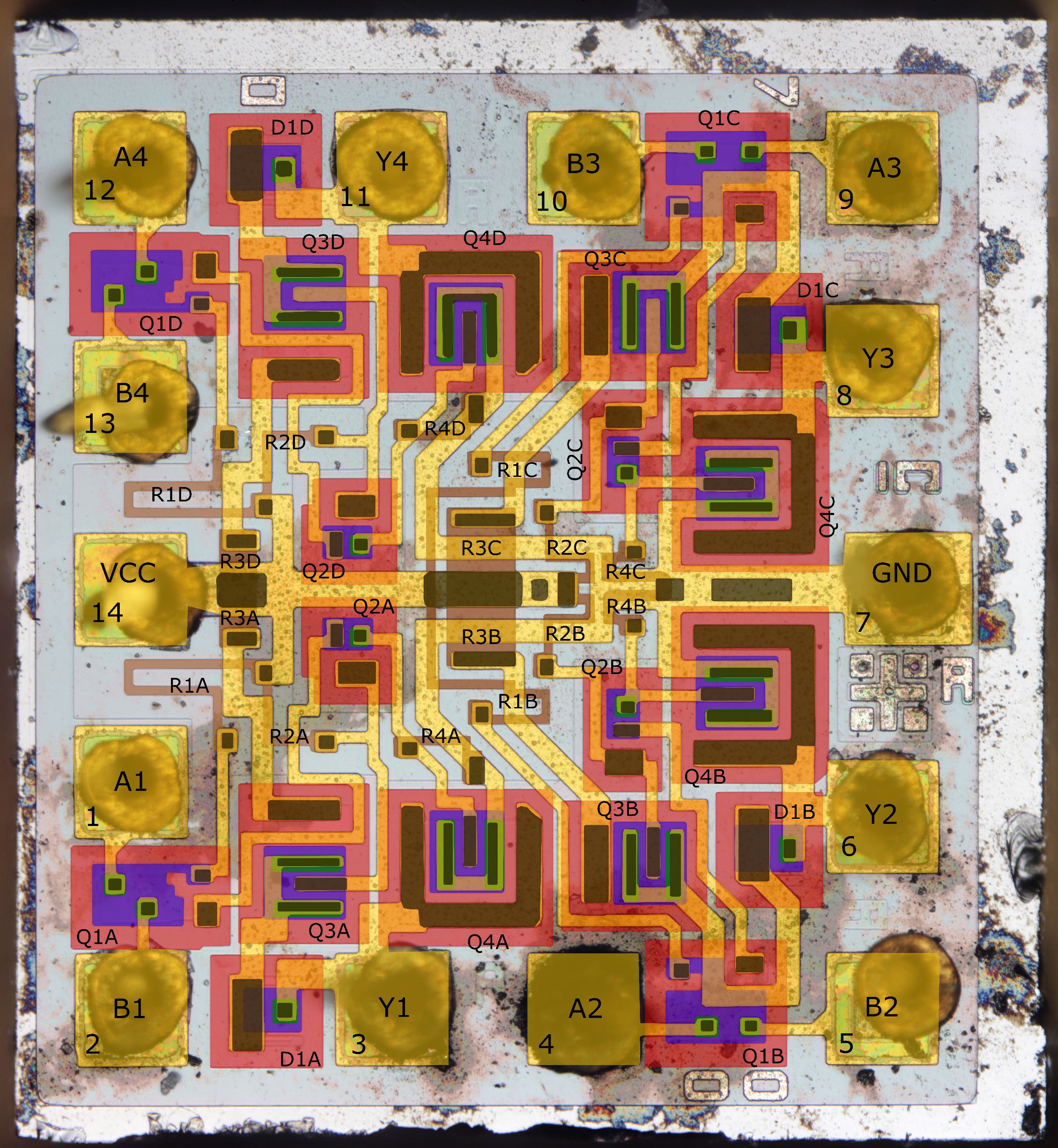

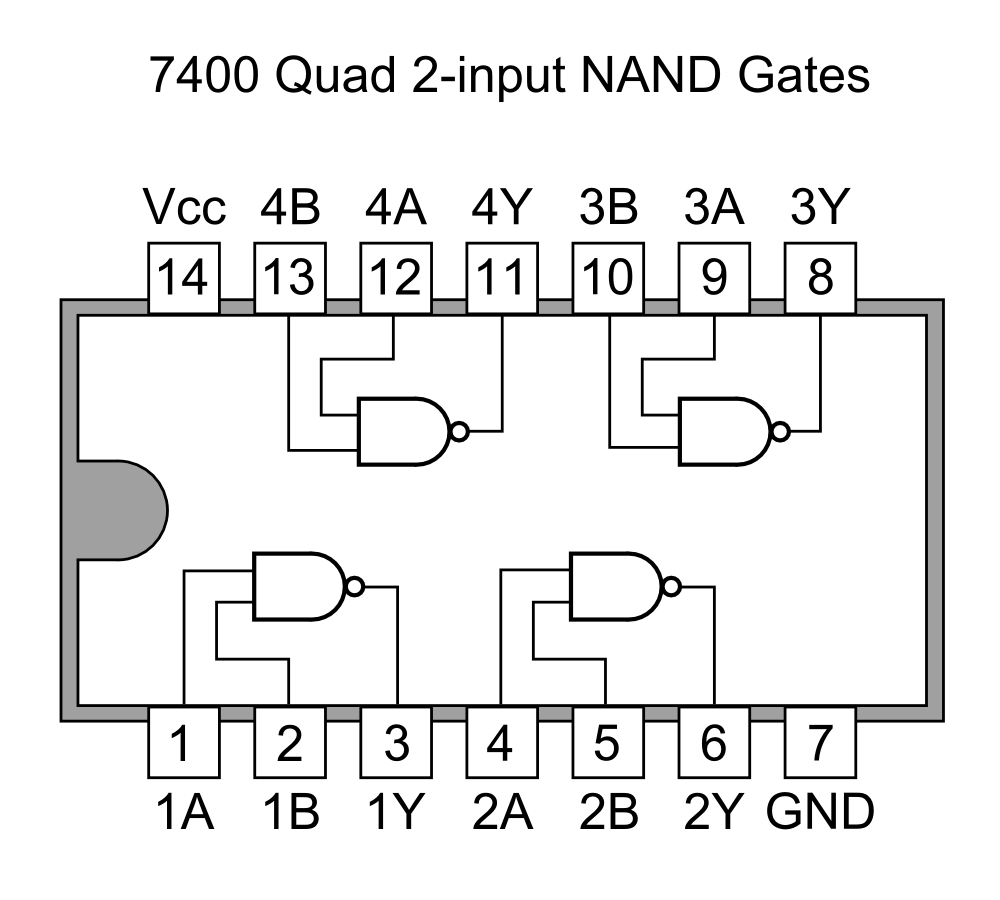

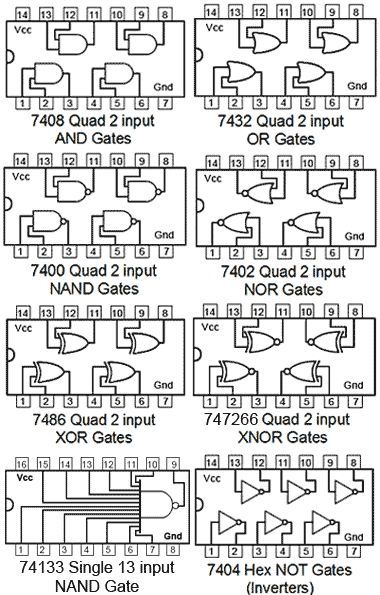

Familia de chips de lógica Texas Instruments SN7400 (1966) |

|

|

|

En la prehistoria de los ordenadores digitales (cuando se clasificaban en dos tipos, miniordenadores y mainframes) los ingenieros buscaban reemplazar transistores discretos por circuitos integrados que pudieran realizar operaciones lógicas básicas. En esa época cuando aún no existían los microprocesadores, los ingenieros trabajaban con componentes muchos más simples: chips como el Texas Instruments SN7400, un circuito integrado con cuatro puertas lógicas NAND de dos entradas. Este chip formaba parte de una gran familia, conocida como la serie 7400, que funcionó muy bien para Texas Instruments. A diferencia de los chips lógicos anteriores, que usaban diodos y transistores (llamada lógica diodo-transistor o DTL, en inglés), los chips 7400 se basaban en circuitos lógicos de sólo transistores (lógica transistor-transistor o TTL, en inglés). El libro "TTL Data Book for Design Engineers" de Texas Instruments para ingenieros de diseño se convirtió, como dice la exposición "The Silicon Engine" del Museo de Historia de la Computación, en "el manual indispensable de finales de la década de 1970". Hoy en día, la familia 7400 todavía está en producción, por parte de Texas Instruments y de muchos otros. Entre los cientos de miembros de la familia 7400 se encuentran chips tan simples como el SN7404, que contiene 6 inversores, y otros tan complejos como el SN74ALVC162334, un controlador de bus universal de 16 bits con salidas de tres estados. Seguramente más de un ingeniero de diseño hardware todavía mantiene el manual de chips TTL al alcance de su mano. |

Dispositivo Texas Instruments Digital Micromirror (1987) |

|

|

|

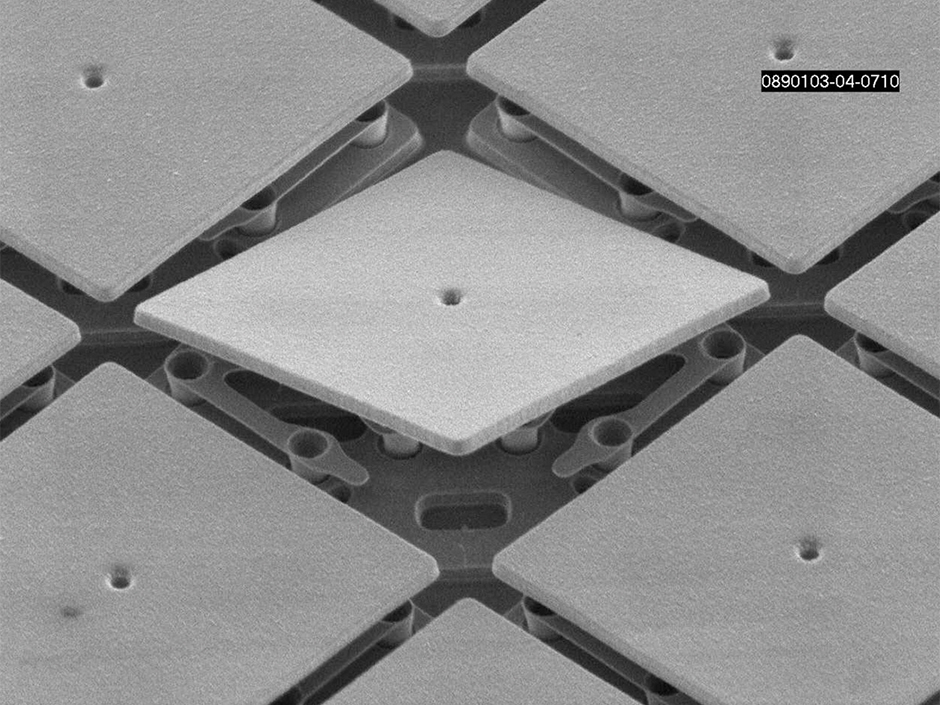

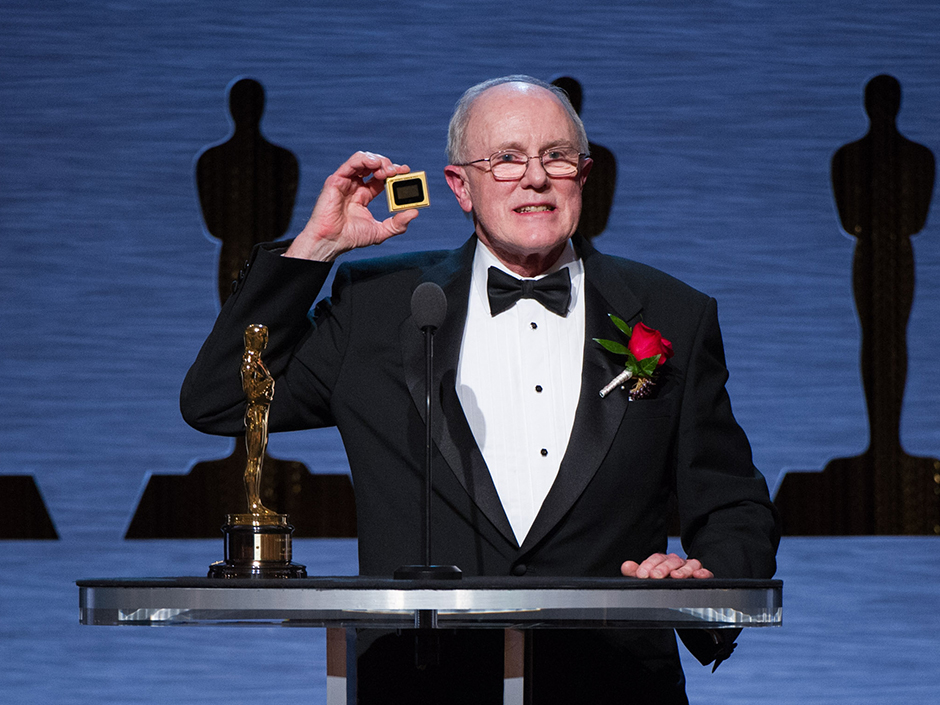

Este invento ganador de un Oscar llevó el video digital a las salas de cine. El 18 de junio de 1999, Larry Hornbeck llevó a su esposa, Laura, a ver "Star Wars: Episodio 1: La Amenaza Fantasma" en un cine en Burbank, California. No es que el canoso ingeniero fuera un fan de los Jedi. La razón por la que estaban allí era en realidad el proyector. En el interior del proyector había un chip, el dispositivo de microespejos digitales (Digital Micromicror Device o DMD), que Hornbeck había inventado en Texas Instruments. Un DMD utiliza millones de espejos microscópicos con bisagras (cada uno de sólo 16 x 16 micrones) para dirigir la luz a través de una lente de proyección. Estos microespejos cambian 5.000 veces por segundo para reflejar la luz y crear una imagen. En este sistema microelectromecánico cada espejo representa un pixel de la imagen proyectada: el número de espejos corresponde con la resolución de la misma. Cada microespejo puede levantarse y girar ±10-12°. En posición encendida, el espejo se levanta y la luz procedente de la lámpara del proyector se refleja y pasa por la lente, haciendo que el pixel correspondiente brille en la pantalla. Por el contrario, en posición apagada, el microespejo dirige el haz hacia un disipador de calor, no hacia la lente, lo que hace que el pixel aparezca oscuro en pantalla. La proyección de "La Amenaza Fantasma" fue la primera exhibición digital de una superproducción. Hoy en día, los proyectores de películas basados ??en esta tecnología de procesamiento de la luz digital, o DLP (Digital Light-Processing), como Texas Instruments la denominó, se utilizan en miles de salas de cine. También es usada en televisores de retroproyección, proyectores de oficina y pequeños proyectores portátiles para teléfonos móviles. “Parafraseando a Houdini”, dice Hornbeck, “microespejos, caballeros. El efecto se crea con microespejos". Por sus esfuerzos, Hornbeck finalmente recibió un Oscar, algo que no consiguió "La Amenaza Fantasma". |

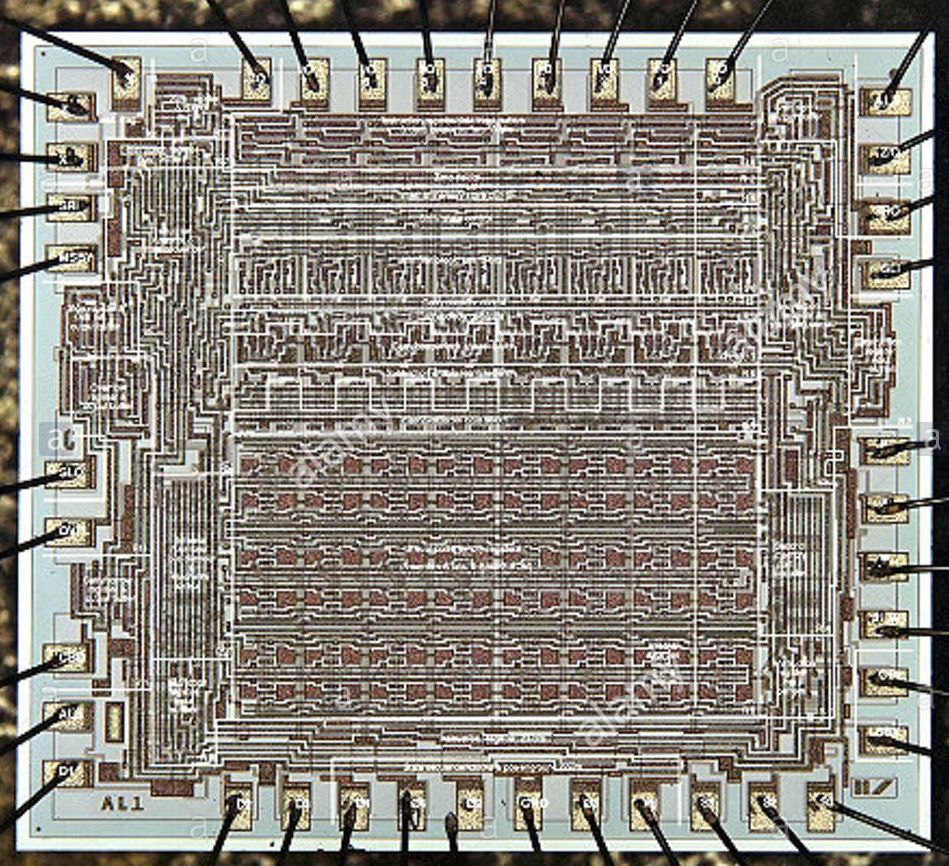

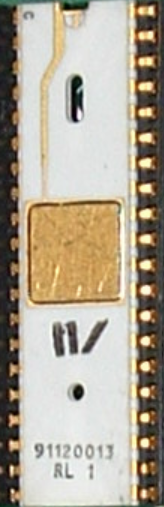

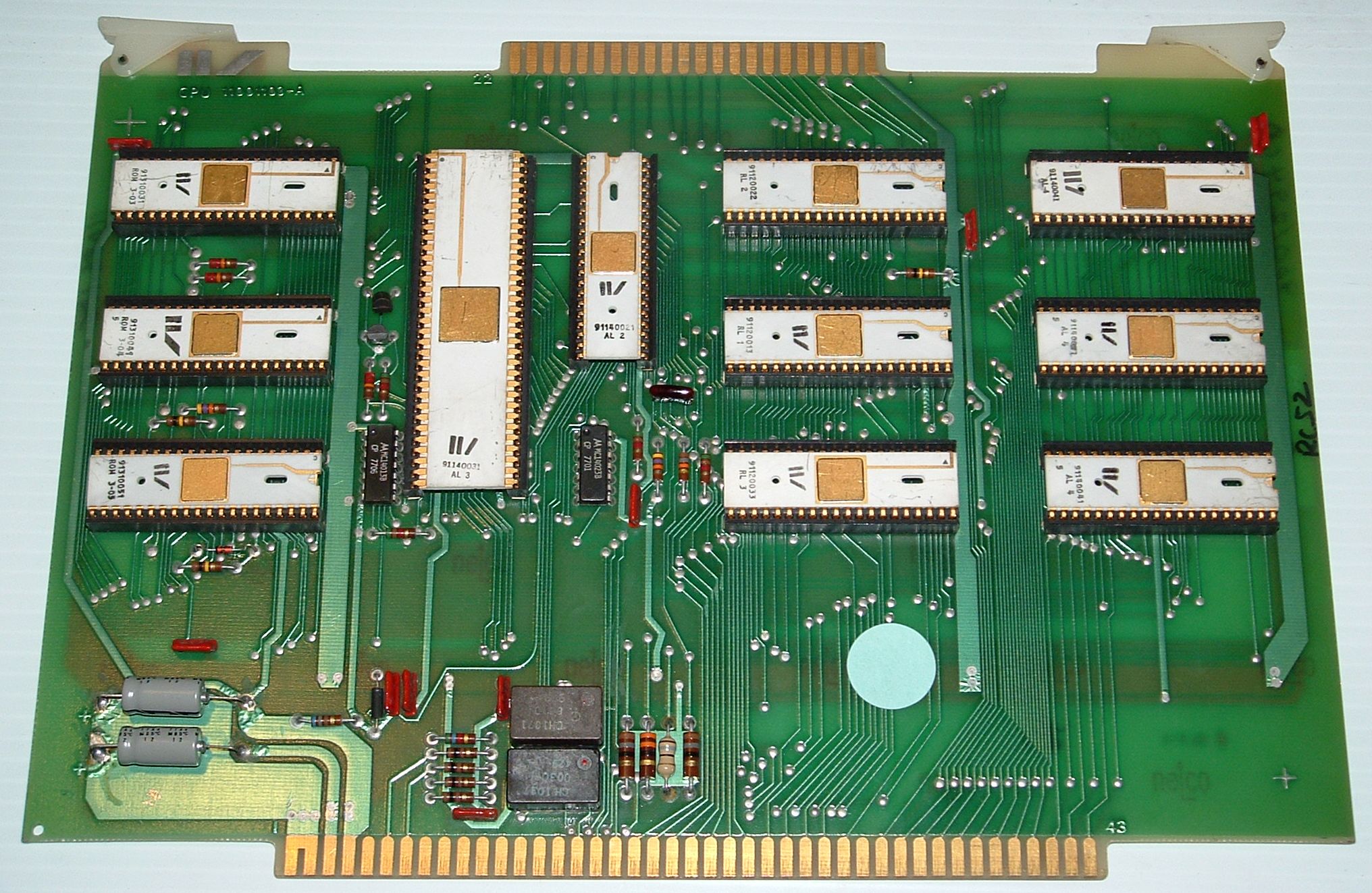

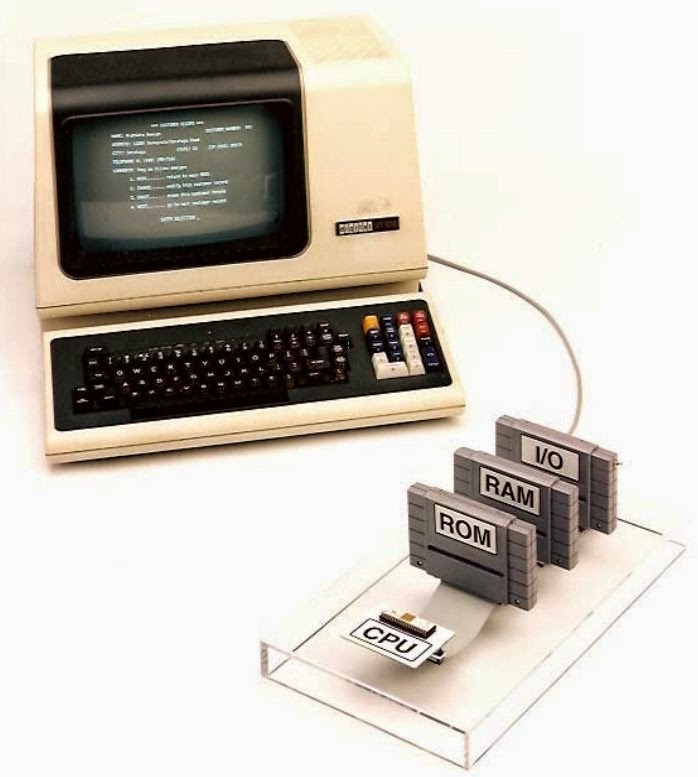

Microprocesador Four-Phase AL1 (1969) |

|

|

|

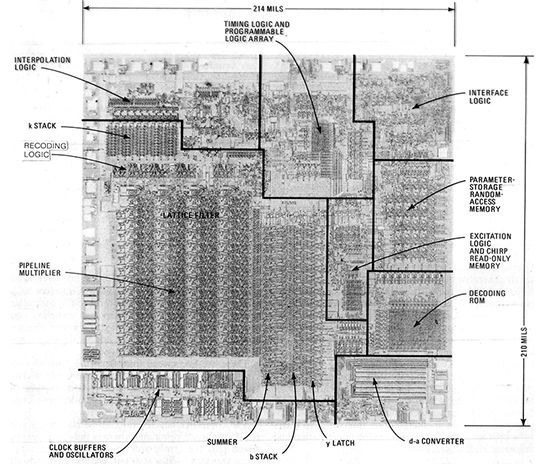

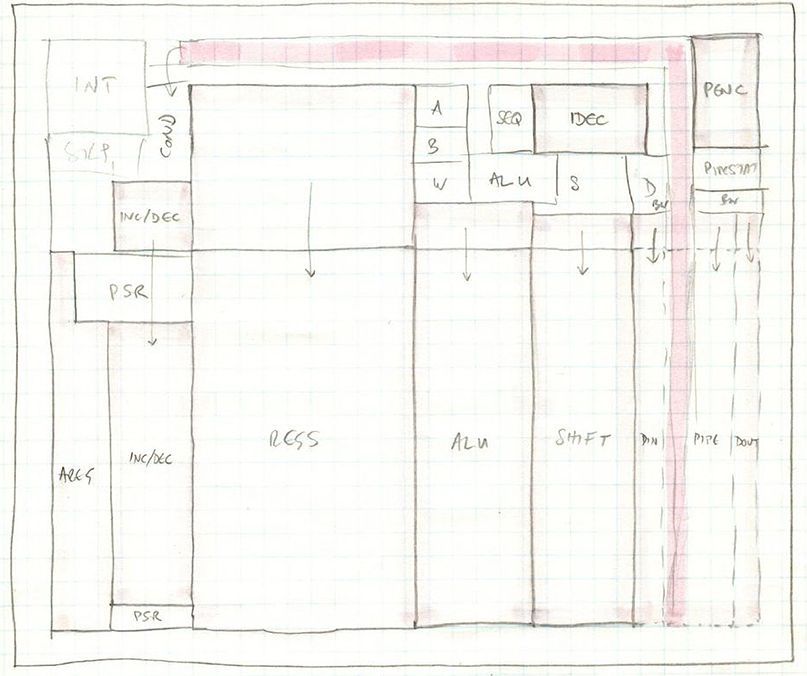

El AL1 era un procesador de 8 bits con 8 registros (incluida el PC) y una ALU completa de 8 bits. Four-Phase usó tres de ellos en un sistema para diseñar un ordenador de 24 bits. También se utilizaron chips adicionales: 3 chips ROM, 3 de lógica aleatoria y generación de reloj de 4 fases, el cual permitió el uso de transistores de tamaño mínimo para la mayoría de las puertas lógicas. Esto aumenta enormemente la densidad y el rendimiento del chip. El AL1 tenía más de 1000 puertas (~ 4000 transistores) con un tamaño de matriz de 130 × 120 mils (100 mm2). Esta era esencialmente la complejidad del Intel 8008 pero con un silicio del tamaño usado por el Intel 4004 de 4 bits. Además, la velocidad era de alrededor de 1 MHz, casi 10 veces más rápido que cualquier otro procesador en ese momento. También contribuyó a la velocidad del AL1 su encapsulado, algo en lo que no se piensa a menudo hoy, pero el encapsulado importaba. El 8008 de Intel era un chip DIP de 18 pines ya que este encapsulado era económico. Esto requería que se multiplexaran las entradas/salidas, lo que provoca una penalización en velocidad. Sin embargo, el AL1 utilizaba un paquete de 40 pines, caro en ese momento, $5, lo que no parece mucho, pero cuando se podía conseguir un encapsulado más pequeño por menos de $1, acaba teniendo su importancia. El beneficio fue que el AL1 tiene todas las entradas/salidas que necesita sin multiplexación. Entonces, ¿por qué el AL1 no es más conocido? Four-Phase nunca hizo publicidad de sus chips, ni siquiera de las placas de procesadores, las consideraba un medio para un fin, vender (o más bien arrendar) sistemas distribuidos muy grandes. En cambio, publicaron un artículo tutorial en Computer Design en abril de 1970 ("Four-phase LSI logic offers new approach to computer designer"). Es por esta razón que el AL1 es prácticamente desconocido, y por esta razón se cita al Intel 4004 como el primer procesador integrado, ya que eso es lo que Intel dijo que era, y nadie en ese momento realmente se molestó en decir lo contrario. Entonces había cosas mucho más importantes que hacer, mucho silicio que construir y probar, y velocidades de reloj que aumentar. En 1995, como parte de un litigio, Four-Phase ensambló en la misma sala del juicio, un sistema en el que se utilizó un solo AL1 de 8 bits como parte de un sistema de ordenador de demostración, junto con tres cartuchos de Super Nintendo que incluían una ROM externa, RAM, y un dispositivo de entrada y salida. Sin embargo esta demostración no acabo de convencer a todo el mundo de que un único AL1 era una CPU de un solo chip (como el Intel 4004): si se realiza un examen detallado, queda claro que el chip AL1 está actuando como un chip aritmético-lógico (de ahí el nombre AL1), y no como una CPU completa. Chip favorito de Nick Tredennick (analista de tecnología de Gilder Publishing). |

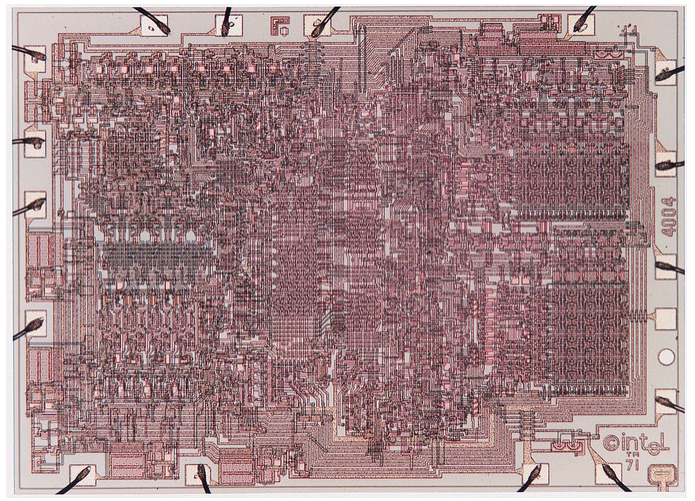

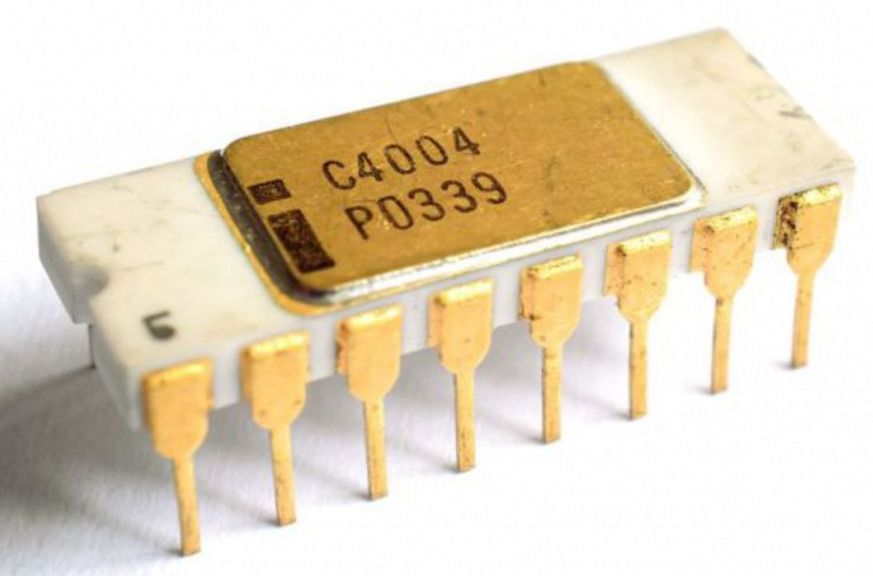

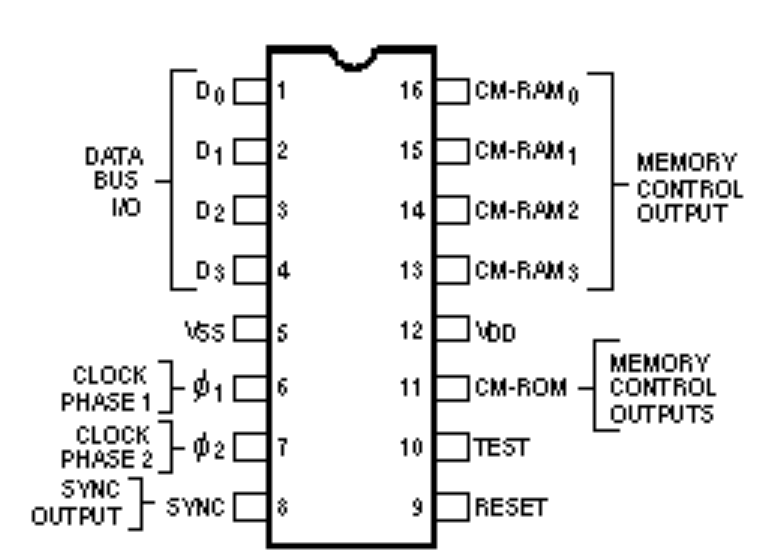

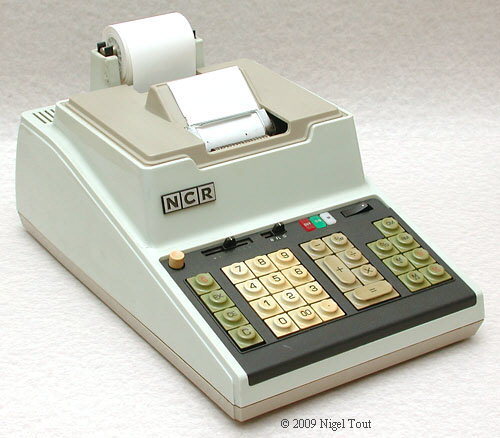

Microprocesador Intel 4004 (1971)

|

|

|

|

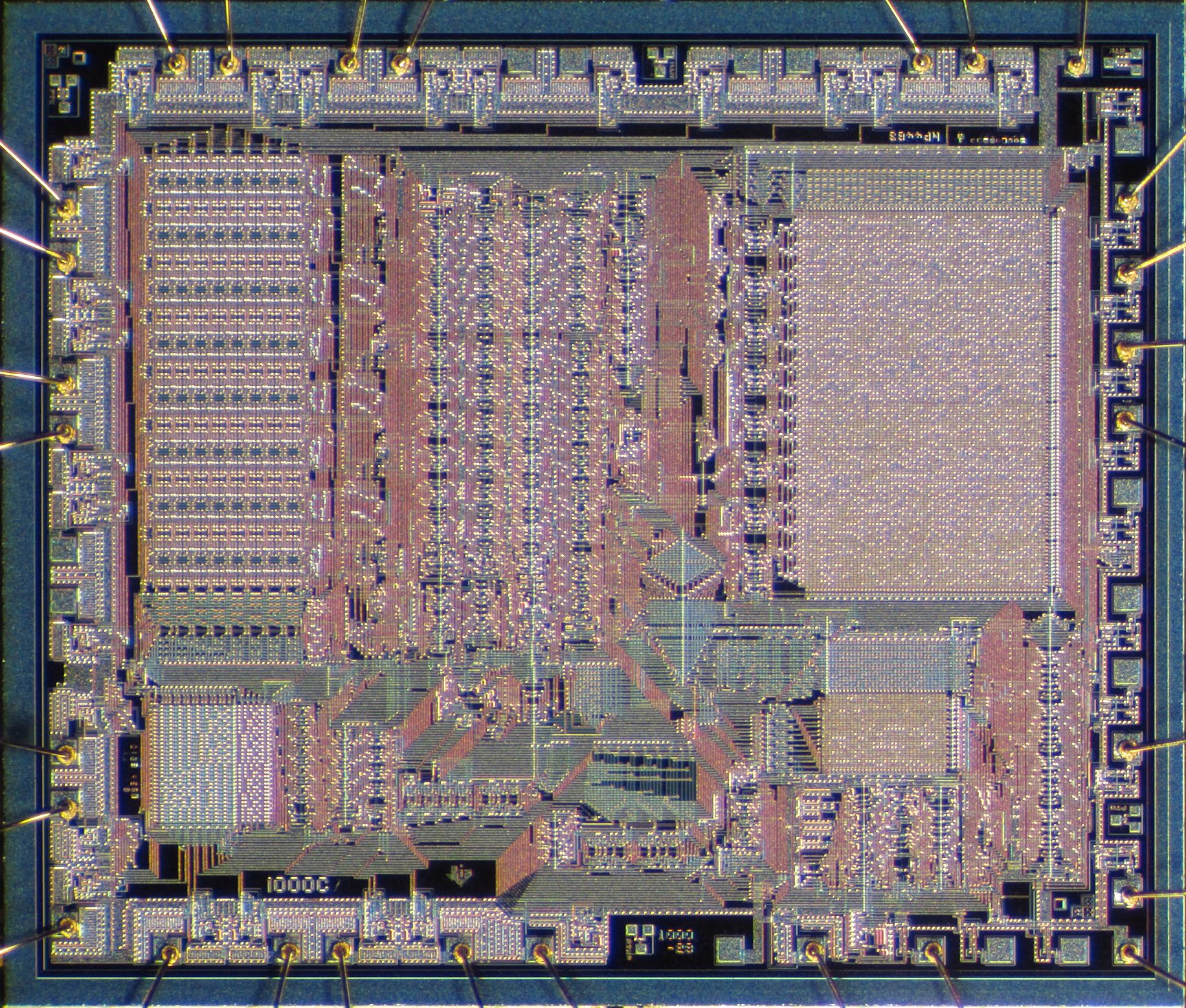

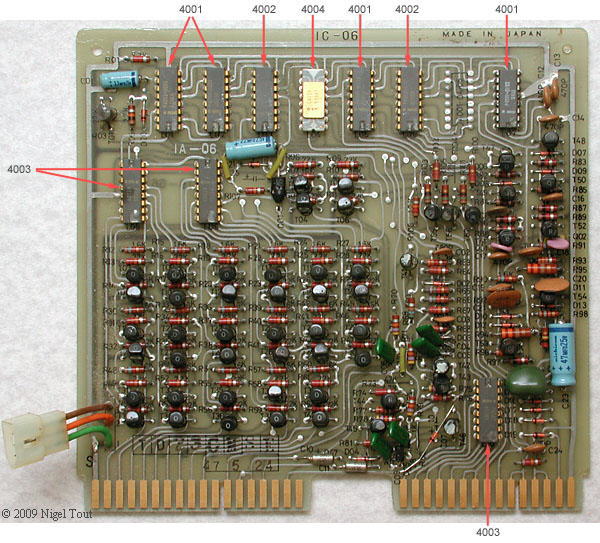

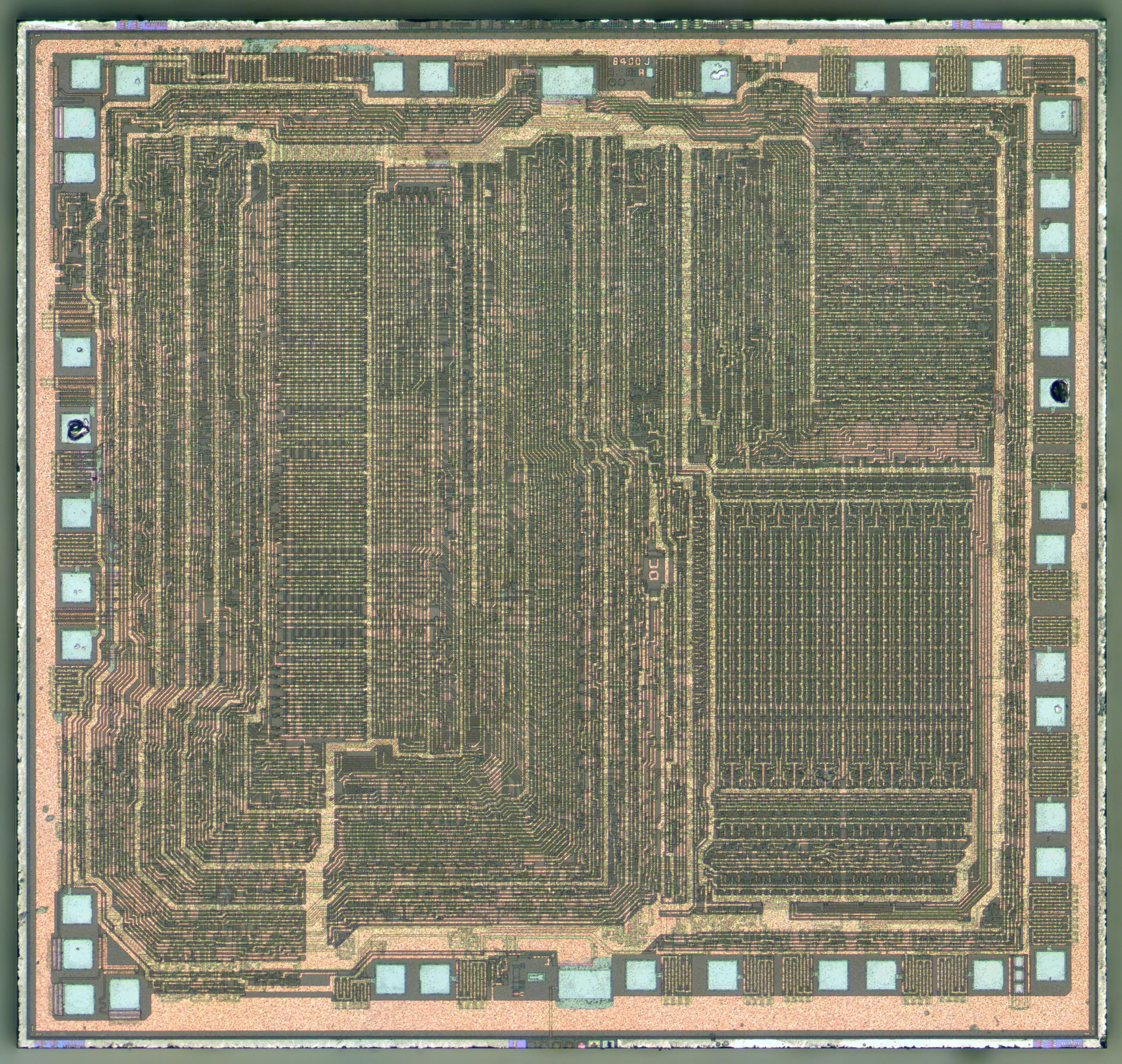

Este año, 2021, es el 50 aniversario de la invención del primer microprocesador de un solo chip, el Intel 4004. El cumpleaños oficial del 4004 fue el 15 de noviembre de 1971, cuando se anunció al público. Hay otros pretendientes al trono, pero sólo el 4004 cumple con todos los criterios clave para ser considerado el primero. Esta CPU de 4bits funcionaba a 0.1-0.7Mhz, en un encapsulado dip de 16 pines, incluyendo 2.300 transistores. Direccionaba hasta 4 KB, tenía 46 instrucciones (de las cuales 41 son de 8 bits de ancho y 5 de 16 bits de ancho), 16 registros de 4 bits cada uno. Su chipset, el MCS-4, estaba compuesto por los siguientes chips: Intel 4001 (ROM), 4002 (RAM), 4003 (registro de desplazamiento), además del 4004 (microprocesador). La primera entrega de un 4004 en pleno funcionamiento se produjo en marzo de 1971 a Busicom Corp. de Japón para su prototipo de calculadora con impresora 141-PF, disponible comercialmente en julio de 1971. Intel ofreció a Busicom un descuento en el costo de los chips si Intel podía vender la familia 4000 para otras aplicaciones. Busicom estuvo de acuerdo e Intel comenzó a anunciar el 4004 en noviembre de 1971: "Anunciando una nueva era de electrónica integrada", decía el texto del anuncio, un caso raro de verdad absoluta en la publicidad. Actualmente, es uno los chips coleccionables/antiguos más codiciados del mundo. |

Microprocesador Intel 8008 (1972) |

|

|

|

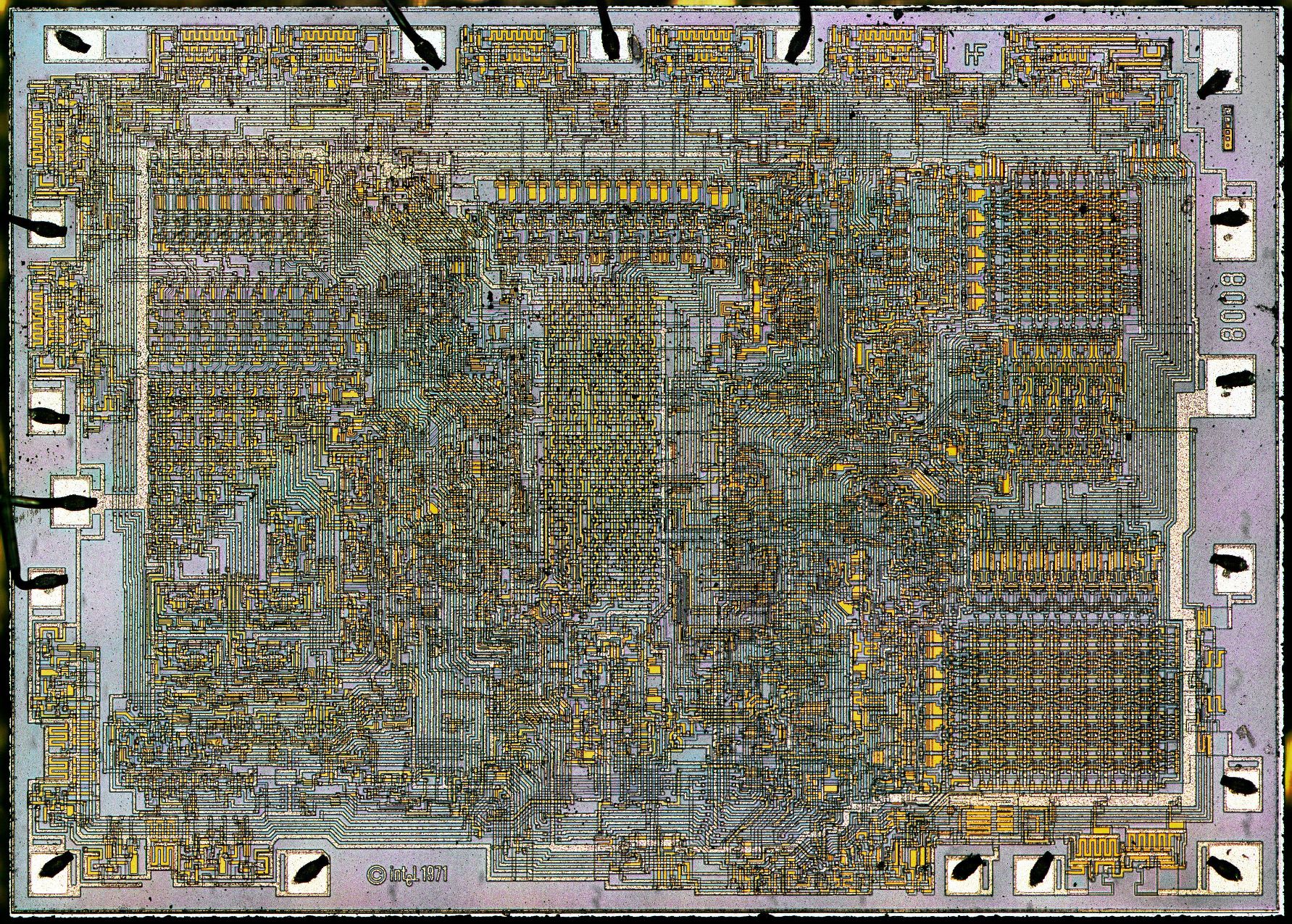

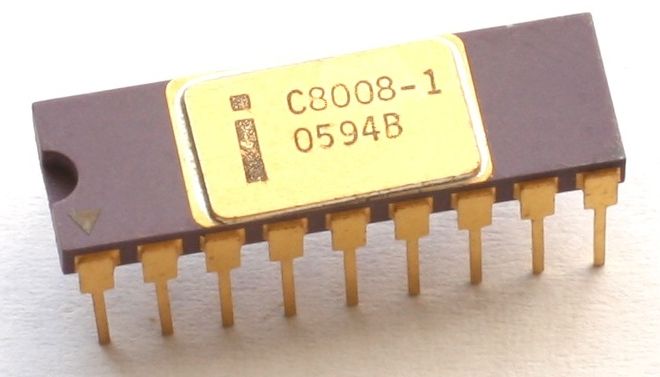

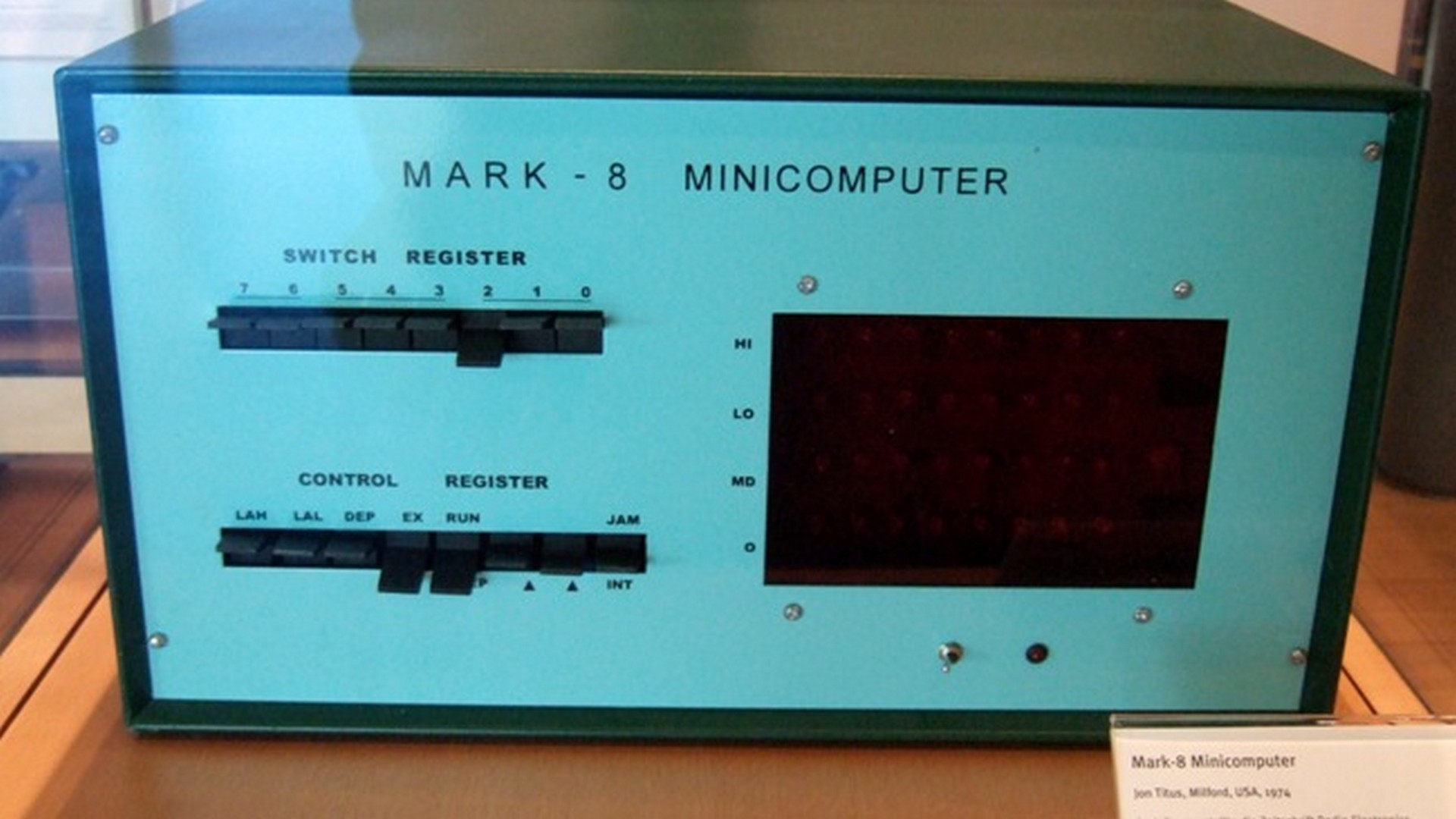

El primer microprocesador de 8 bits, fue el sucesor del 4004. Integraba 3500 transistores en un encapsulado DIP de 18 pines. Aunque un poco más lento que los microprocesadores Intel 4004 e Intel 4040 de 4 bits en cuanto a la cantidad de millones de instrucciones por segundo ejecutadas (0.2-0.8Mhz), el hecho de que el 8008 procesara 8 bits de datos al tiempo y que pudiera acceder a mucha más memoria hacen que el 8008 sea en la práctica unas tres o cuatro veces más rápido que sus predecesores de 4 bits. El 8008 era un diseño aceptable para utilizarlo como el controlador de un terminal, pero no para el resto de tareas, por lo que pocos ordenadores se basaron en él. La mayoría de los ordenadores de la época emplearon el mejorado Intel 8080, con alguna excepción como el Mark-8, el microordenador diseñado en 1974 basado en la CPU Intel 8008. |

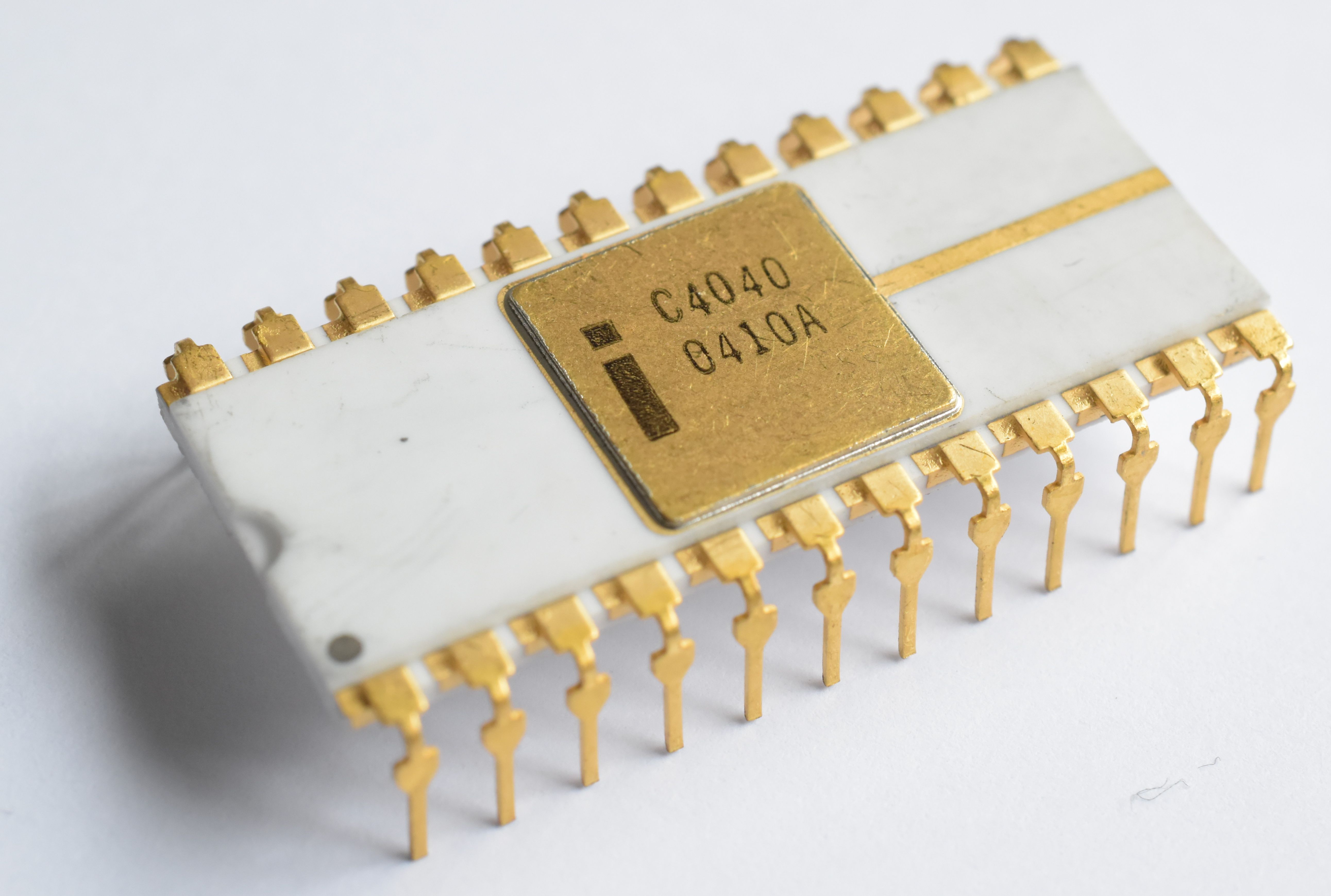

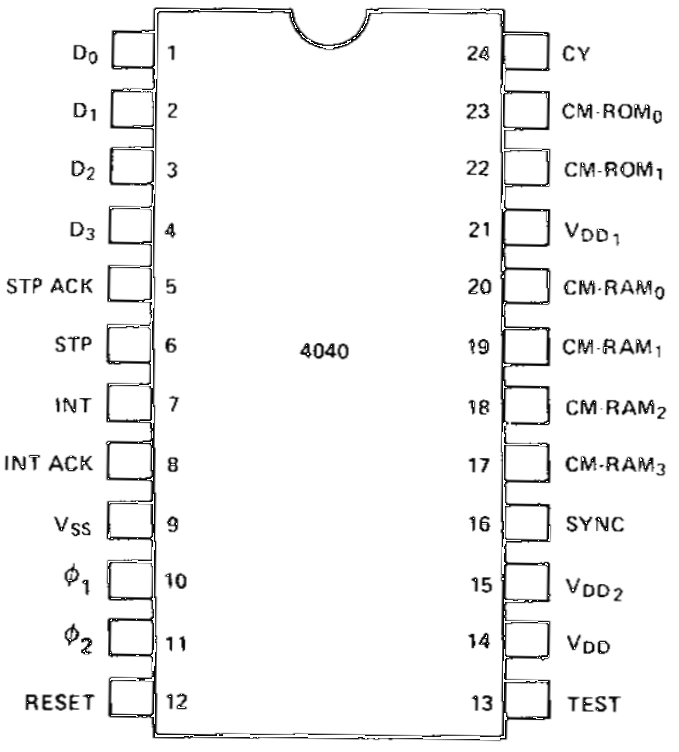

Microprocesador Intel 4040 (1974) |

|

|

|

El Intel 4040 fue el sucesor del Intel 4004. Lanzado al mercado en 1974, fue diseñado por Federico Faggin (quien propuso la arquitectura y condujo el proyecto) y Tom Innes. El 4040 es una versión mejorada del 4004. Ambos son de 4 bits y tienen la misma velocidad de reloj, 0.5-0.8Mhz. El 4040 tiene un mayor tamaño de pila (7 niveles en vez de 3), doble direccionamiento de memoria, 14 nuevas instrucciones, 8 registros adicionales de 4 bits y manejo de interrupciones. El encapsulado del 4040 era más de dos veces el ancho del 4004, con 24 pines en lugar de los 16 del 4004. La familia 4040 también se identifica como MCS-40 y se utilizó principalmente para juegos y equipos de verificación y control. El 4040 fue usado en algunos de los primeros ordenadores personales de la época, como el Intellec 4/40. |

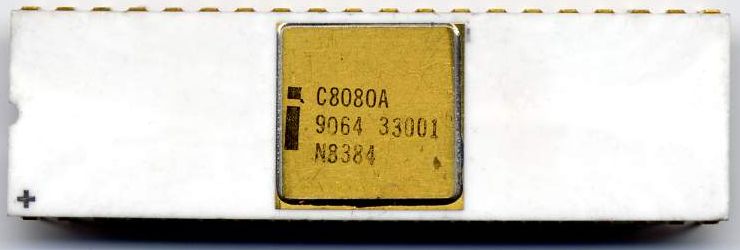

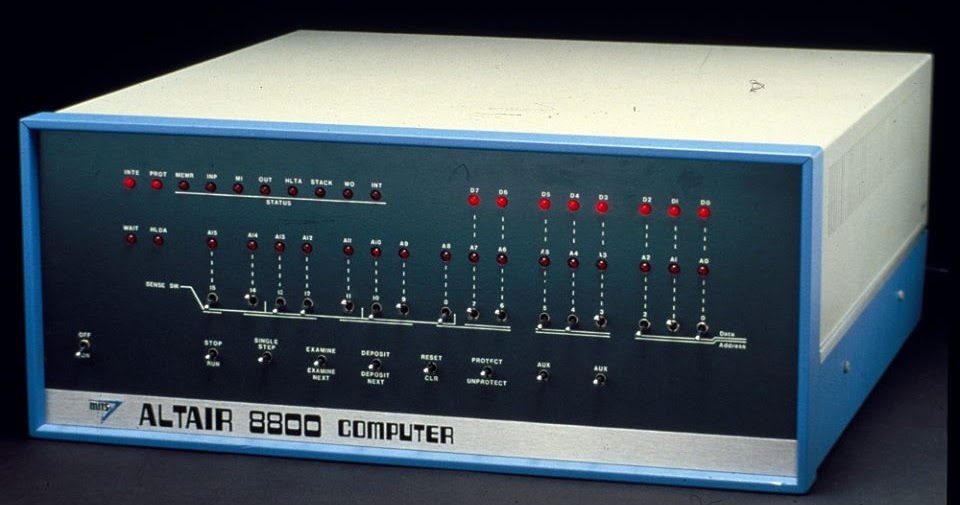

Microprocesador Intel 8080 (1974) |

|

|

|

El Intel 8080 fue un microprocesador temprano diseñado y fabricado por Intel. La CPU de 8 bits fue lanzada en abril de 1974. Corría a 2 MHz, y generalmente se le considera el primer diseño de microprocesador verdaderamente útil. El 8080 es el segundo microprocesador de 8 bits diseñado y fabricado por Intel. Apareció por primera vez en abril de 1974 y es una variante ampliada y mejorada del diseño del 8008, aunque sin compatibilidad binaria. La velocidad era de 2 MHz, y con instrucciones comunes que usan 4, 5, 7, 10 u 11 ciclos, esto significaba que operaba a una velocidad típica de unos pocos cientos de miles de instrucciones por segundo. Una variante más rápida, el 8080A-1 (a veces llamada 8080B) estuvo disponible más tarde a una velocidad de hasta 3,125 MHz. Aunque los microprocesadores anteriores se utilizaron para calculadoras, cajas registradoras, terminales de computadora, robots industriales y otras aplicaciones, el 8080 se convirtió en uno de los primeros microprocesadores de propósito general. El 8080 fue usado en varios de los primeros microcomputadores, tales como los famosos Altair 8800 de MITS y el IMSAI 8080, formando la base para las máquinas que corrían el sistema operativo CP/M. Posteriormente, en 1976, aparece el microprocesador Zilog Z80, completamente compatible con el 8080 pero más potente, convirtiéndose el Z80 y el CP/M en la combinación dominante de CPU y OS de esa época, bastante parecido al x86 y el MS-DOS para el PC de la década posterior de los 80. El primer microordenador en una simple tarjeta fue construido en base al 8080. En 1975, un año tras el lanzamiento del 8080, surge competidores, el Motorola 6800, y más tarde ese mismo año, el 6502, la variante del 6800 desarrollada por MOS Technology. En Intel, el 8080 fue seguido en 1976 por el compatible y más elegante 8085, más adelante, en junio de 1978, por el 8086 de 16 bits y en junio de 1979 por el 8088 de 8/16 bits, que eran compatibles a nivel del lenguaje ensamblador con el 8080. El 8088 fue seleccionado por IBM para su nuevo IBM PC que fue lanzado en 1981. Vemos así que la arquitectura del 8080 tuvo un impacto notable y duradero en historia del microprocesador. |

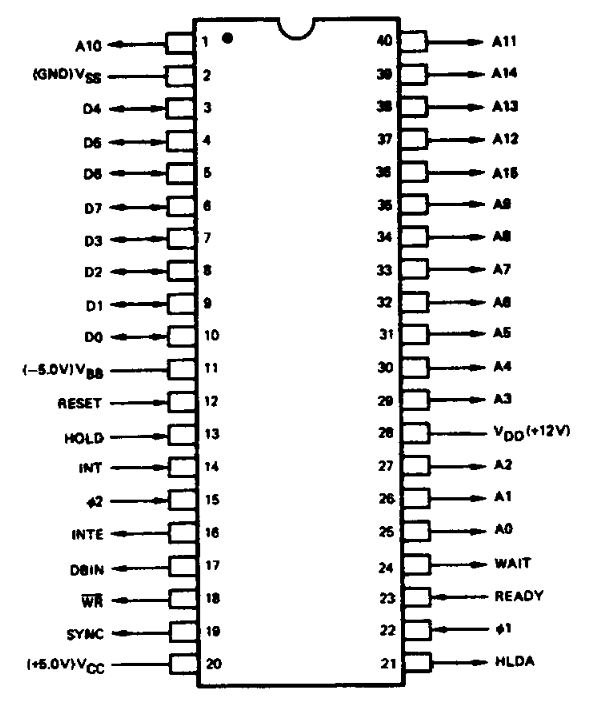

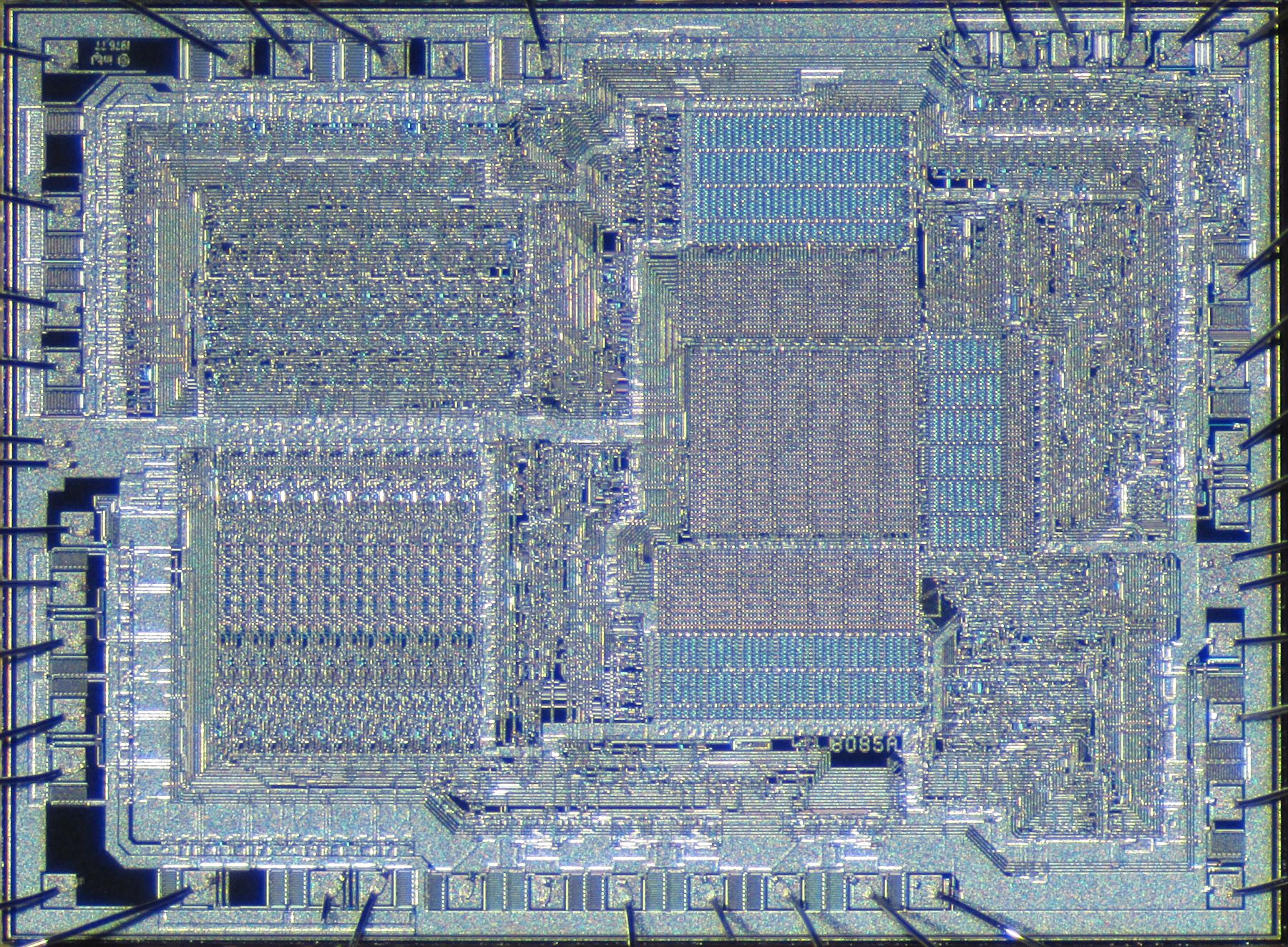

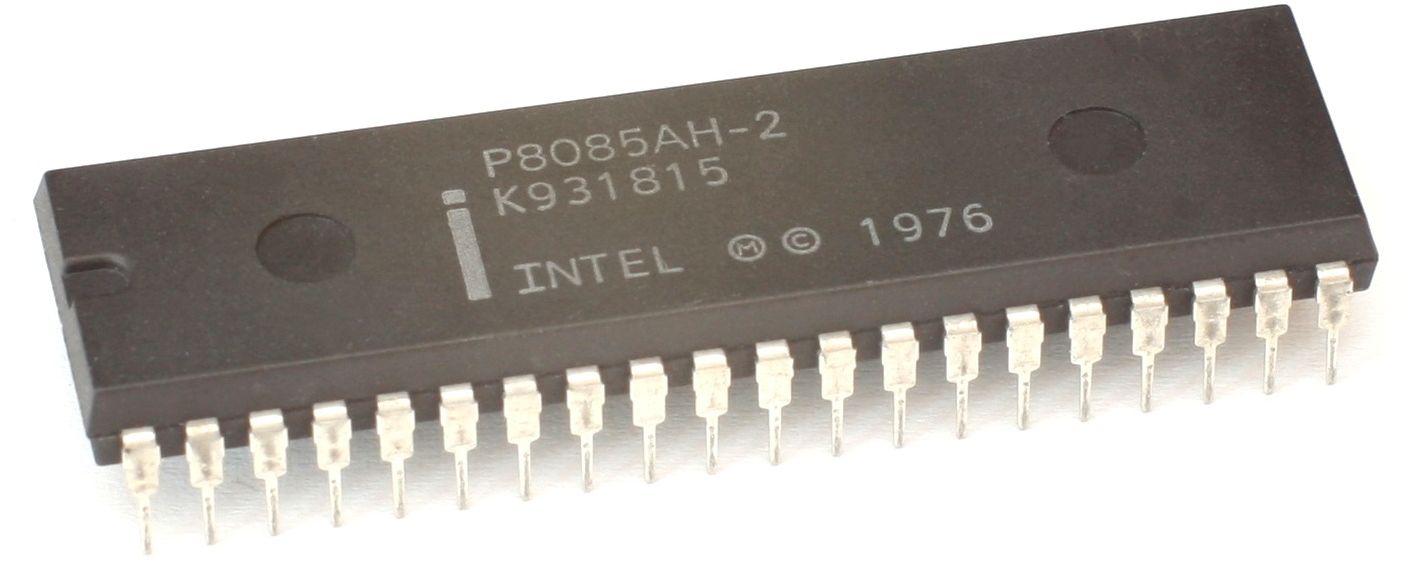

Microprocesador Intel 8085 (1977) |

|

|

|

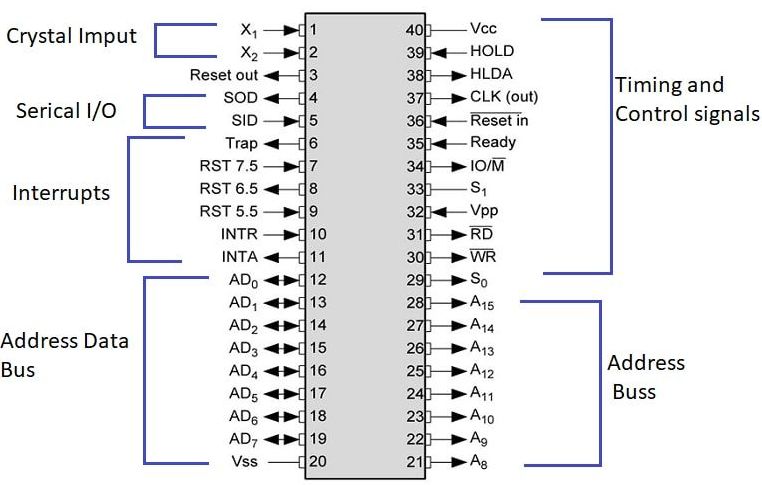

El 8085 era compatible con el anterior Intel 8080 pero exigía menos soporte de hardware, así que permitía contruir sistemas más simples y más baratos. El número 5 de la numeración del procesador proviene del hecho que solamente requería una alimentación de 5 voltios, no como el 8080 que necesitaba alimentaciones de 5 y 12 voltios. Tanto el 8080 como el 8085 fueron usados en ordenadores corriendo el sistema operativo CP/M, pero ambos fueron sobrepasados por el Ziloj Z80 que era más compatible y potente, el cual se llevó todo el mercado de los ordenadores CP/M, al mismo tiempo que participaba en la prosperidad del mercado de los ordenadores domésticos de mediados de los 80 (el Z80 fue la CPU de los Sinclair ZX Spectrum, Amstrad CPC, MSX, etc.). Integrando unos 6500 transistores, y a una velocidad en los primeros modelos de 3Mhz, este microprocesador de 8 bits se usó como CPU de algunos de los primeros ordenadores personales, como la familia TRS-80 Model 100. Aunque, mucho más frecuentemente, el 8085 fue empleado como controlador gracias a sus líneas de entrada/salida de serie y 5 interrupciones priorizadas, características que el Z80 no tenía. De hecho, su vida útil en productos como DECtape y la terminal VT102 se alargó más que la vida comercial de muchos ordenadores personales de la época. |

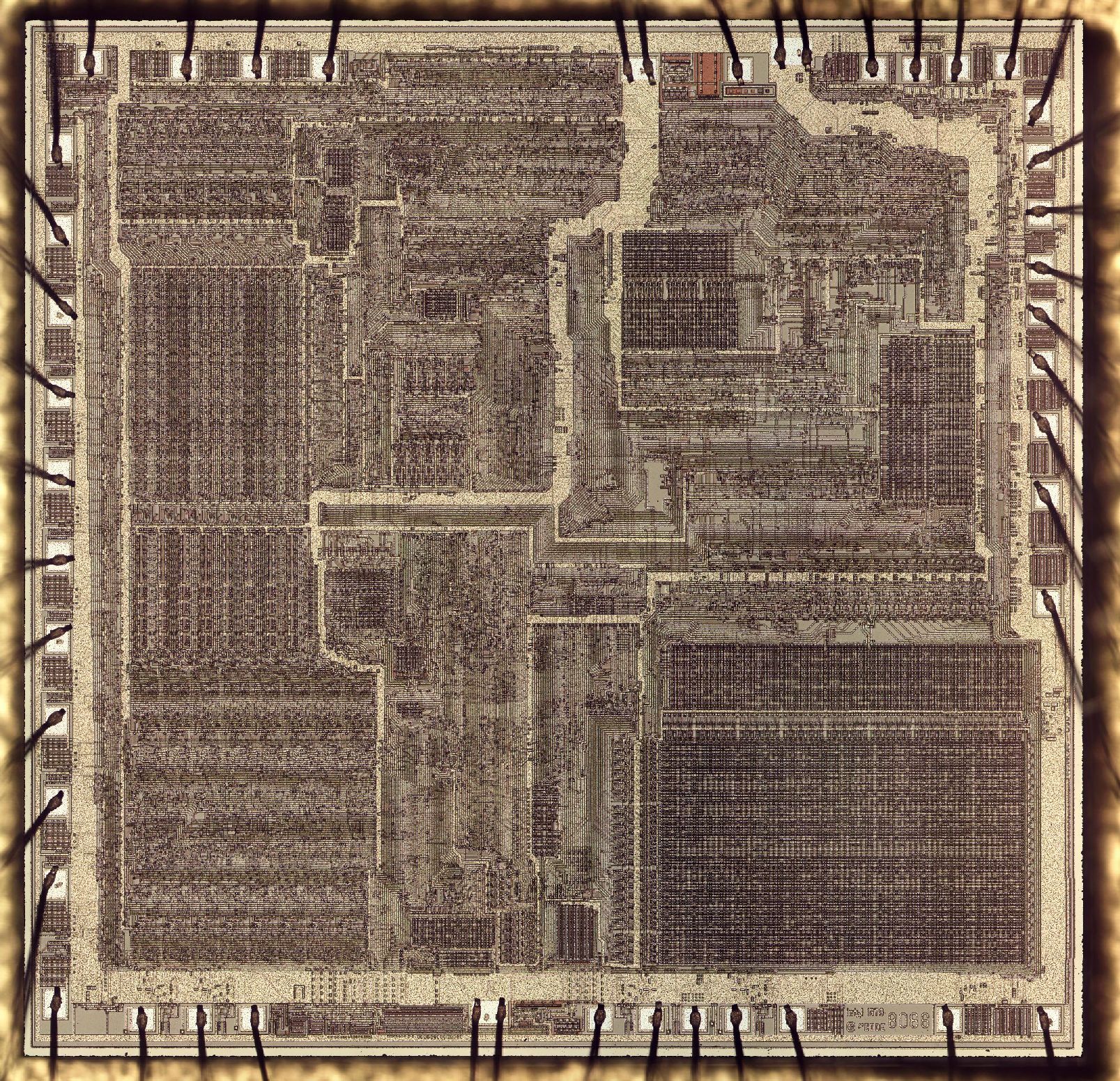

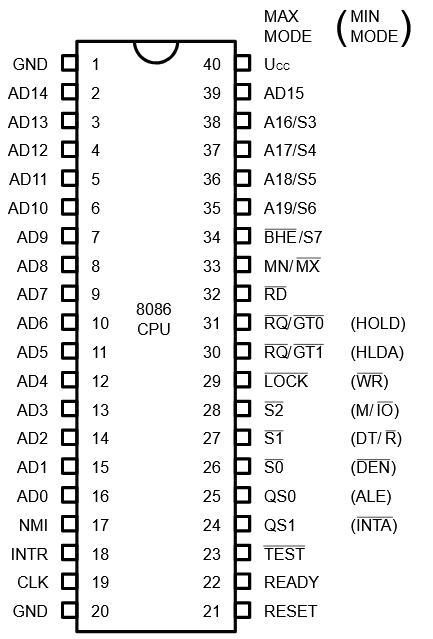

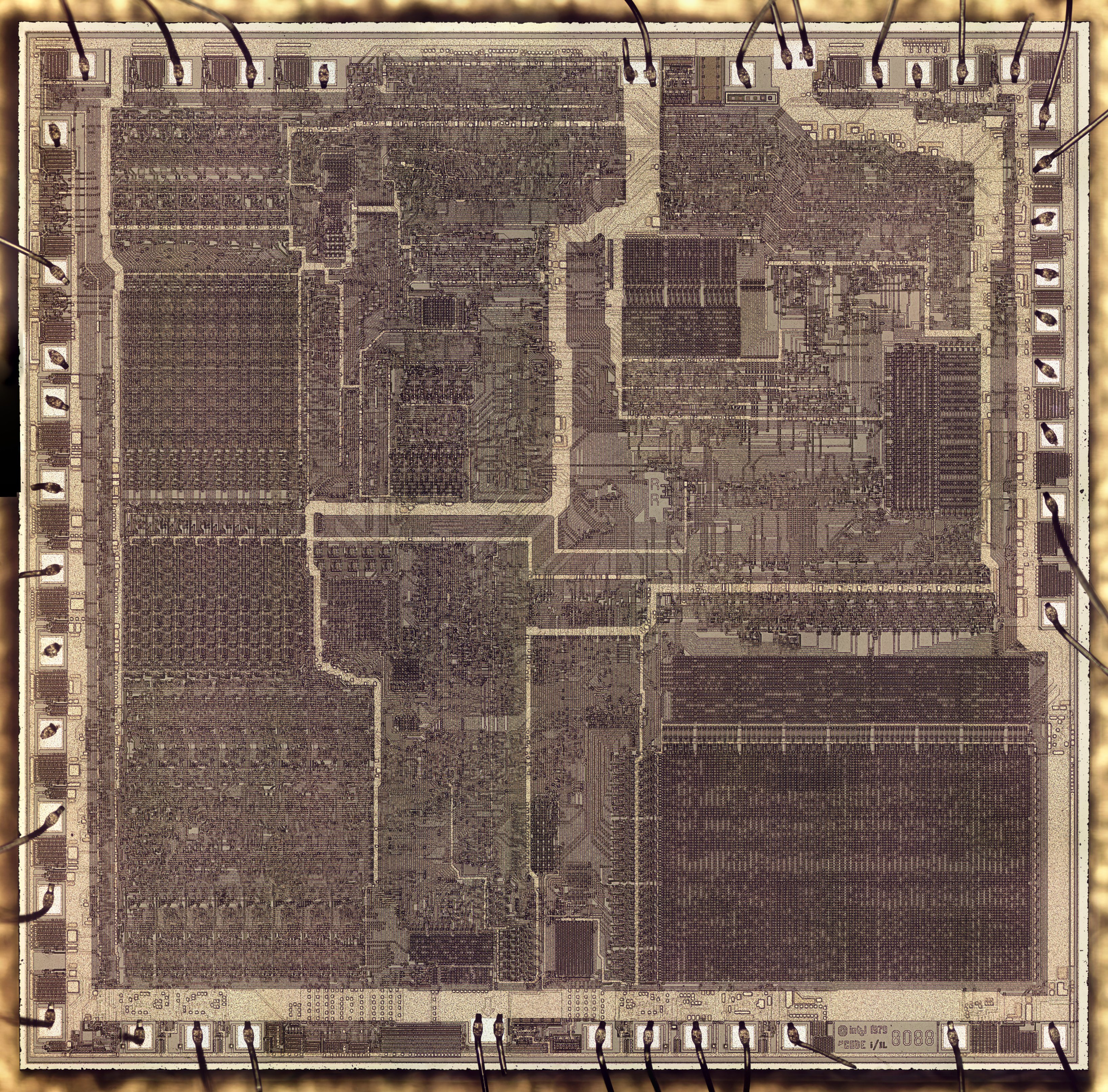

Microprocesador Intel 8086 (1978) |

|

|

|

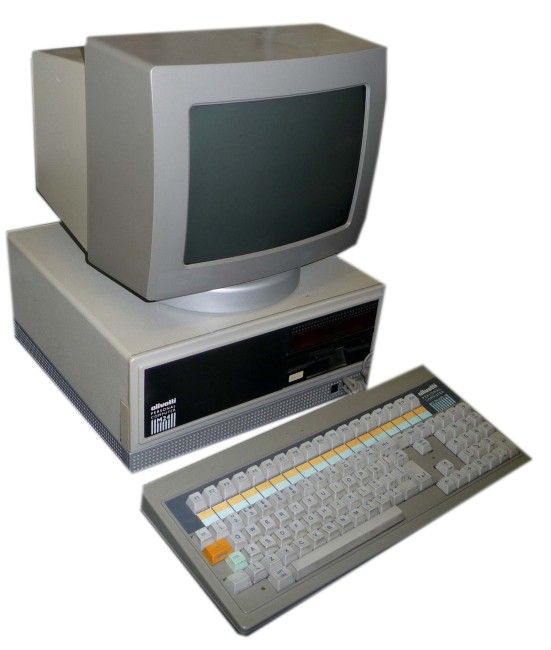

Con este microprocesador Intel da el salto a los 16 bits. Su vida comercial duraría 20 años (lo cual es muy meritorio en un mundo donde la Ley de Moore se cumple a rajatabla), dejando de fabricarse en 1998. El Intel 8086 y el Intel 8088 son los primeros microprocesadores de 16 bits diseñados por Intel. Fueron el inicio y los primeros miembros de la arquitectura x86. El trabajo de desarrollo para el 8086 comenzó en la primavera de 1976 y fue lanzando al mercado en el verano de 1978. El 8088 fue lanzado en 1979. El 8086 y el 8088 ejecutan el mismo conjunto de instrucciones. Internamente son idénticos, excepto que el 8086 tiene una cola de 6 bytes para instrucciones y el 8088 de solo 4. Exteriormente se diferencian en que el 8086 tiene un bus de datos de 16 bits y el del 8088 es de solo 8 bits, por ello, el 8086 era más rápido. Por otro lado, el 8088 podía usar menos circuitos lógicos de soporte, lo que permitía la fabricación de sistemas más económicos. Integrando 29.000 transistores y funcionando de 5-10MHz, el 8086 es unas 10 veces más rápido que el 8080. El 8086 fue elegido como la CPU de numerosos ordenadores personales compatibles con el IBM PC, al cual superaban en rendimiento gracias precisamente a usar el 8086 en lugar del 8088, como por ejemplo, el Compaq Deskpro o el Olivetti M24, además de los IBM PS/2 modelos 25 y 30, y el Amstrad PC1512 y sucesores. Es curioso que hasta el año 2002 la NASA todavía estaba usando la CPU 8086 original en equipos de mantenimiento en tierra del transbordador espacial Discovery, para prevenir los problemas que pudiera resultar por actualizar o cambiar a otras CPUs más modernas pero no tan sólidas y fiables. |

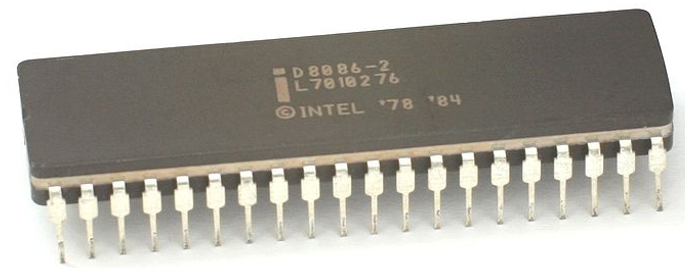

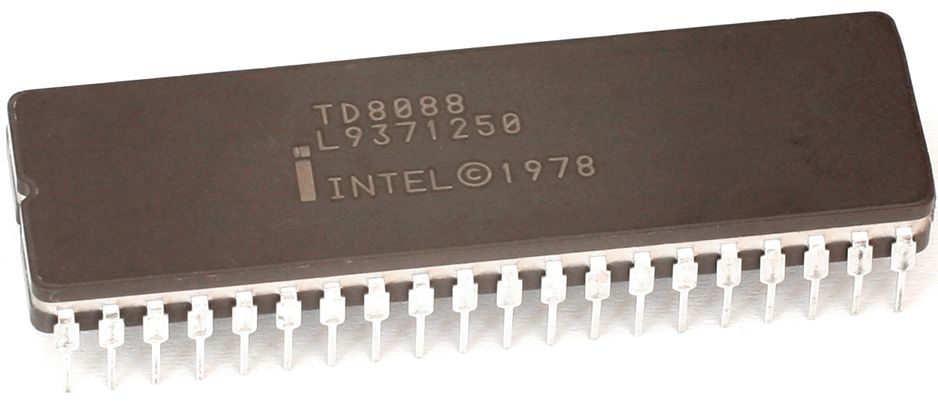

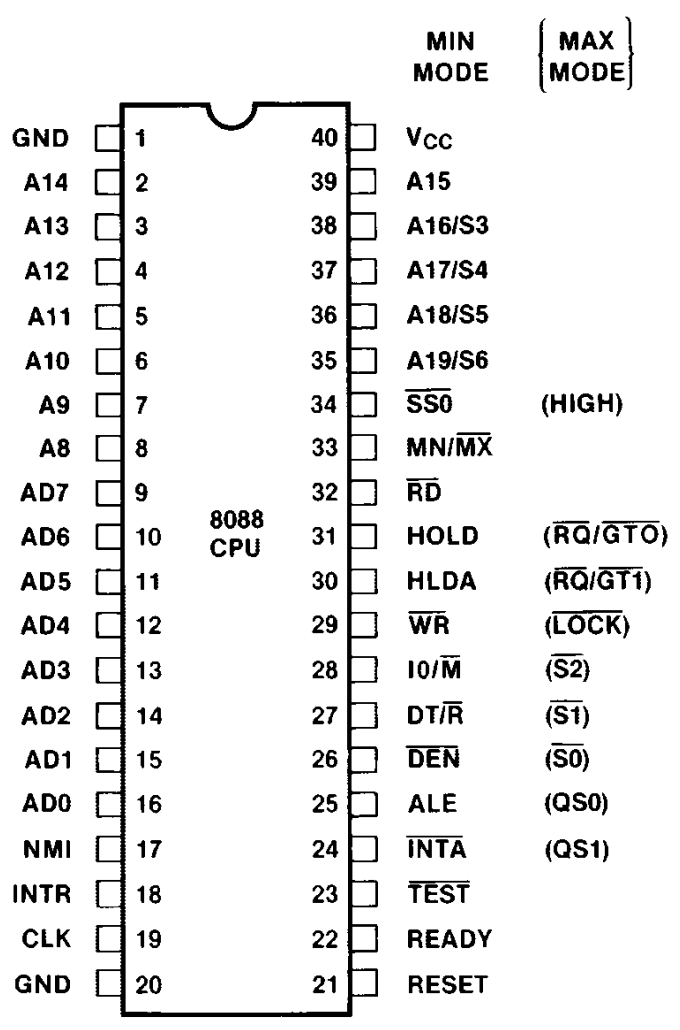

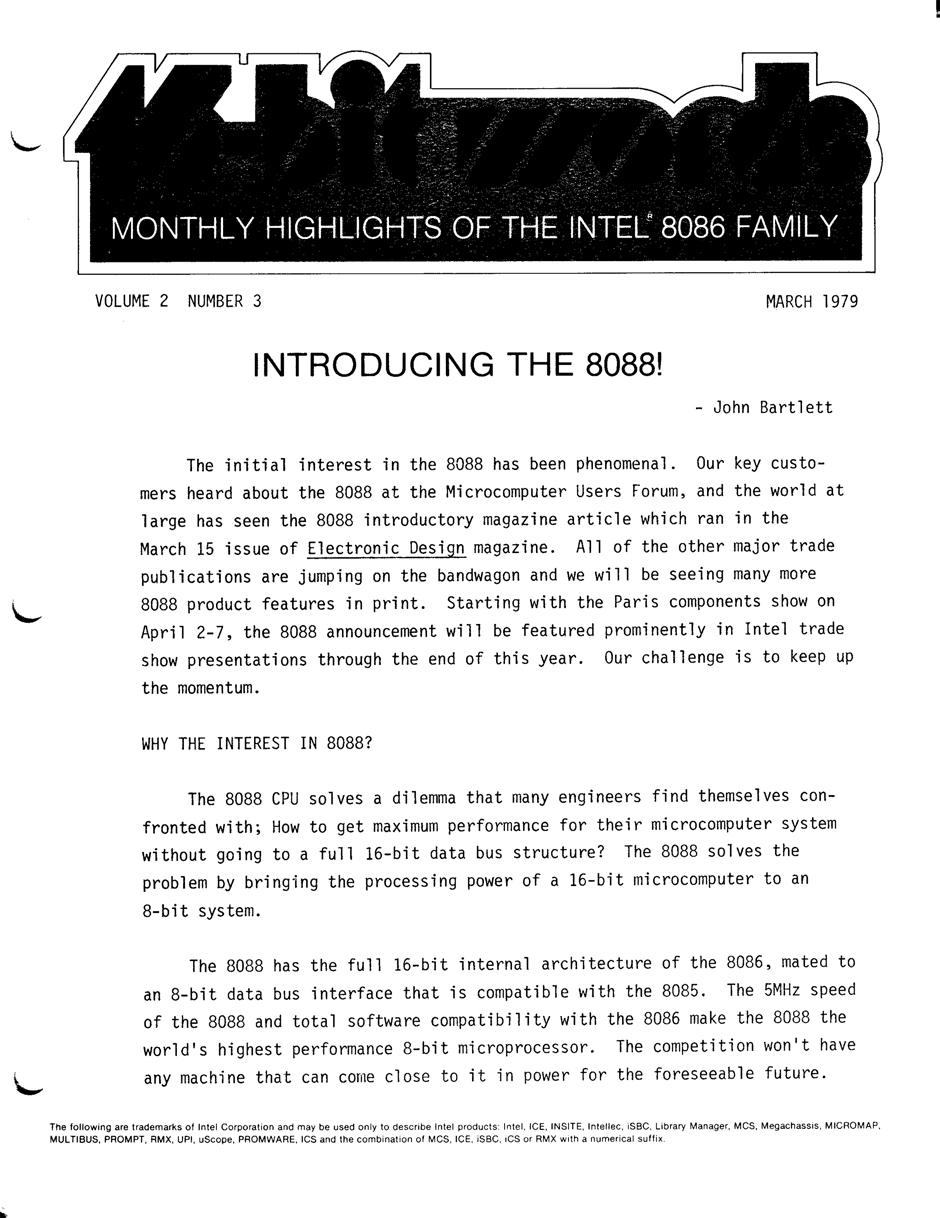

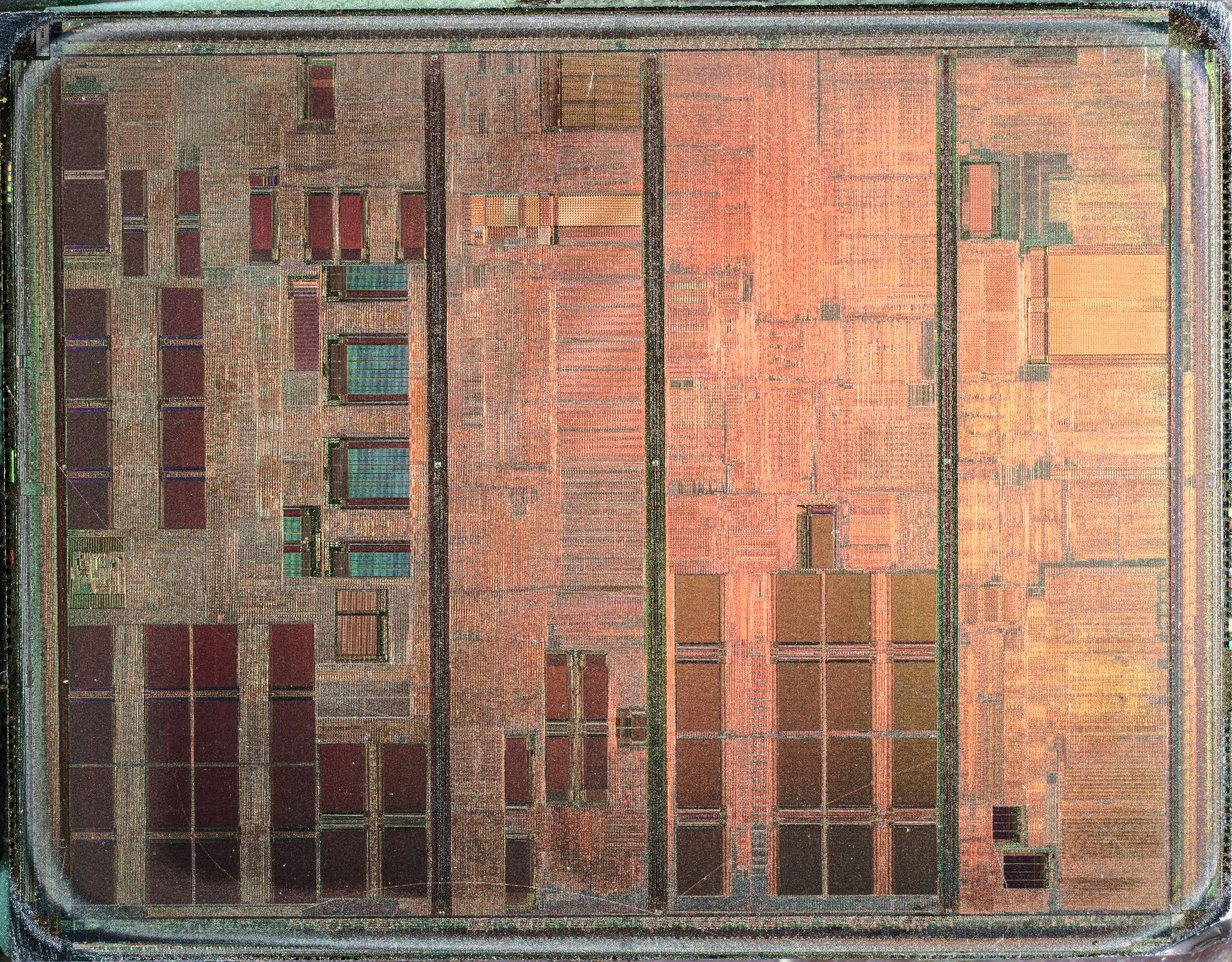

Microprocesador Intel 8088 (1979) |

|

|

|

El microprocesador "castrado" que dio a luz al IBM PC. ¿Hubo algún chip que impulsó a Intel a la lista Fortune 500? Intel dice que sí que lo hubo: el 8088. Esta fue la CPU de 16 bits que IBM eligió para su línea de PC, que pasó a dominar el mercado de ordenadores de sobremesa en todo el mundo. En un extraño giro del destino, el chip que estableció lo que se conocería como la arquitectura x86 no tenía un nombre agregado con un "86". El 8088 era básicamente un 8086, la primera CPU de 16 bits de Intel, ligeramente modificado. O como dijo una vez el ingeniero de Intel Stephen Morse, el 8088 era "una versión castrada del 8086". Esto se debe a que la principal innovación del nuevo chip no fue exactamente un paso adelante en términos técnicos: el 8088 procesaba internamente datos en palabras de 16 bits, pero utilizaba un bus de datos externo de 8 bits. Los gerentes de Intel mantuvieron el proyecto 8088 en secreto hasta que el diseño 8086 estuvo casi completo. "La gerencia no quería retrasar el 8086 ni un día, ni siquiera diciéndonos que tenían la variante 8088 en mente", dice Peter A. Stoll, un ingeniero jefe del proyecto 8086 que hizo algunos trabajos en el 8088, un "grupo de trabajo de un día para corregir un error de microcódigo que tomó tres días". Fue sólo después de lanzar el primer 8086 funcional que Intel envió el material gráfico y la documentación del 8086 a una unidad de diseño en Haifa, Israel, donde dos ingenieros, Rafi Retter y Dany Star, alteraron el chip para tener un bus de sólo 8 bits. La "castración" resultó ser una de las mejores decisiones de Intel. La CPU 8088 de 29.000 transistores requería menos y más baratos chips de soporte que el 8086 y tenía "compatibilidad total con un hardware de 8 bits, al mismo tiempo que proporcionaba un procesamiento más rápido y una transición fluida a procesadores de 16 bits", como Robert Noyce y Ted Hoff, de Intel, escribieron en un artículo de 1981 para la revista IEEE Micro. El primer PC que usó el 8088 fue el modelo 5150 de IBM, una máquina monocromática que costaba 3.000 dólares. Ahora casi todas los PCs del mundo están construidos alrededor de CPUs que tienen al 8088 como su antepasado. No está nada mal para un chip castrado. |

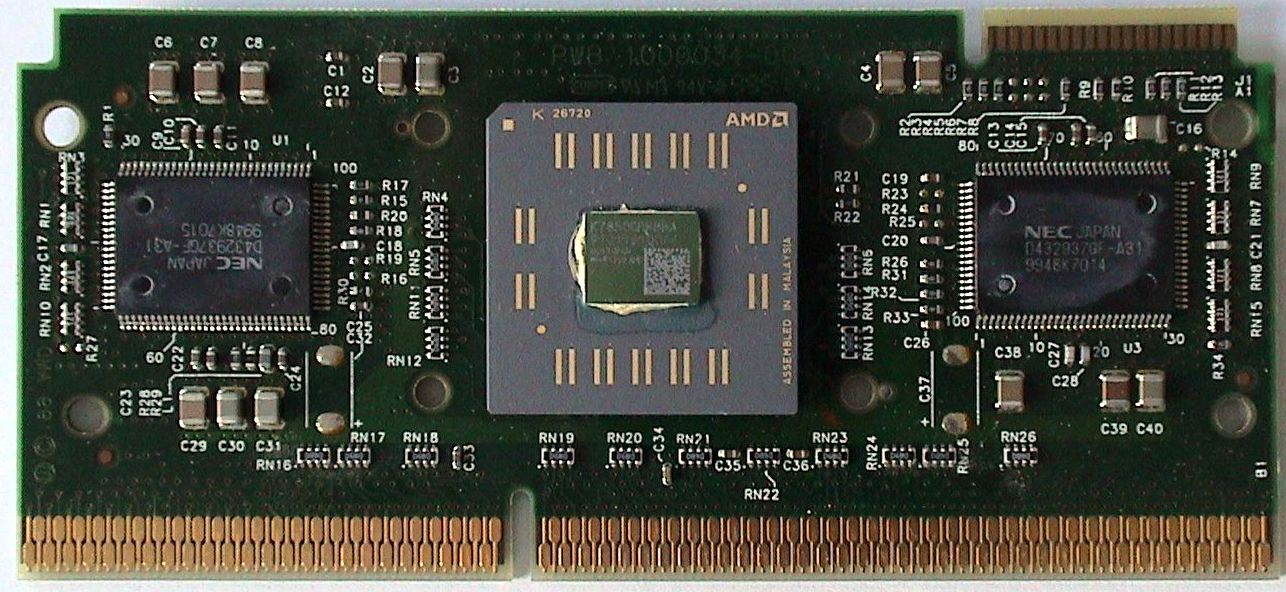

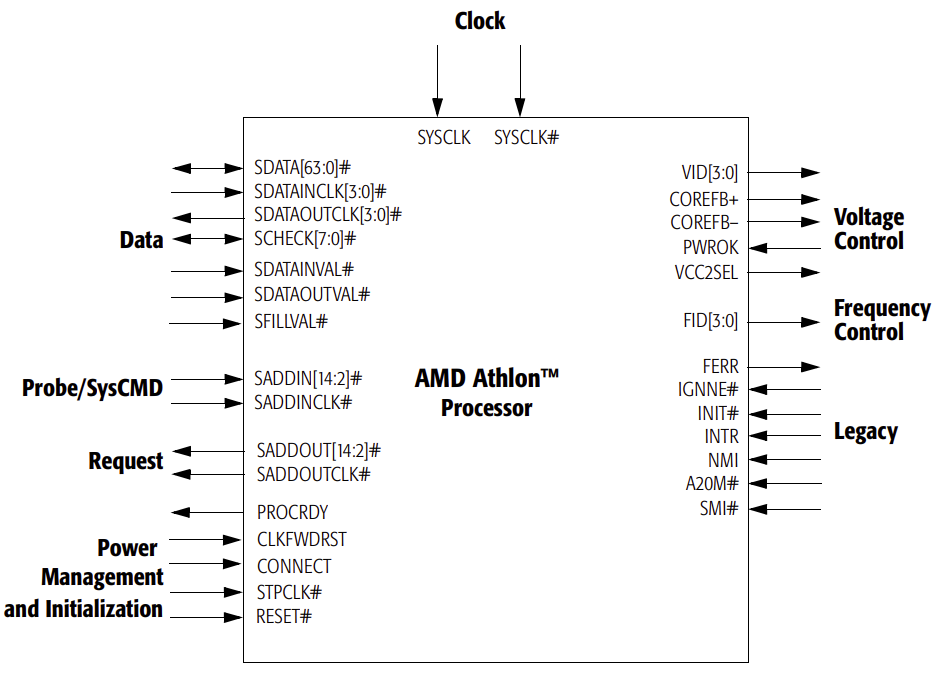

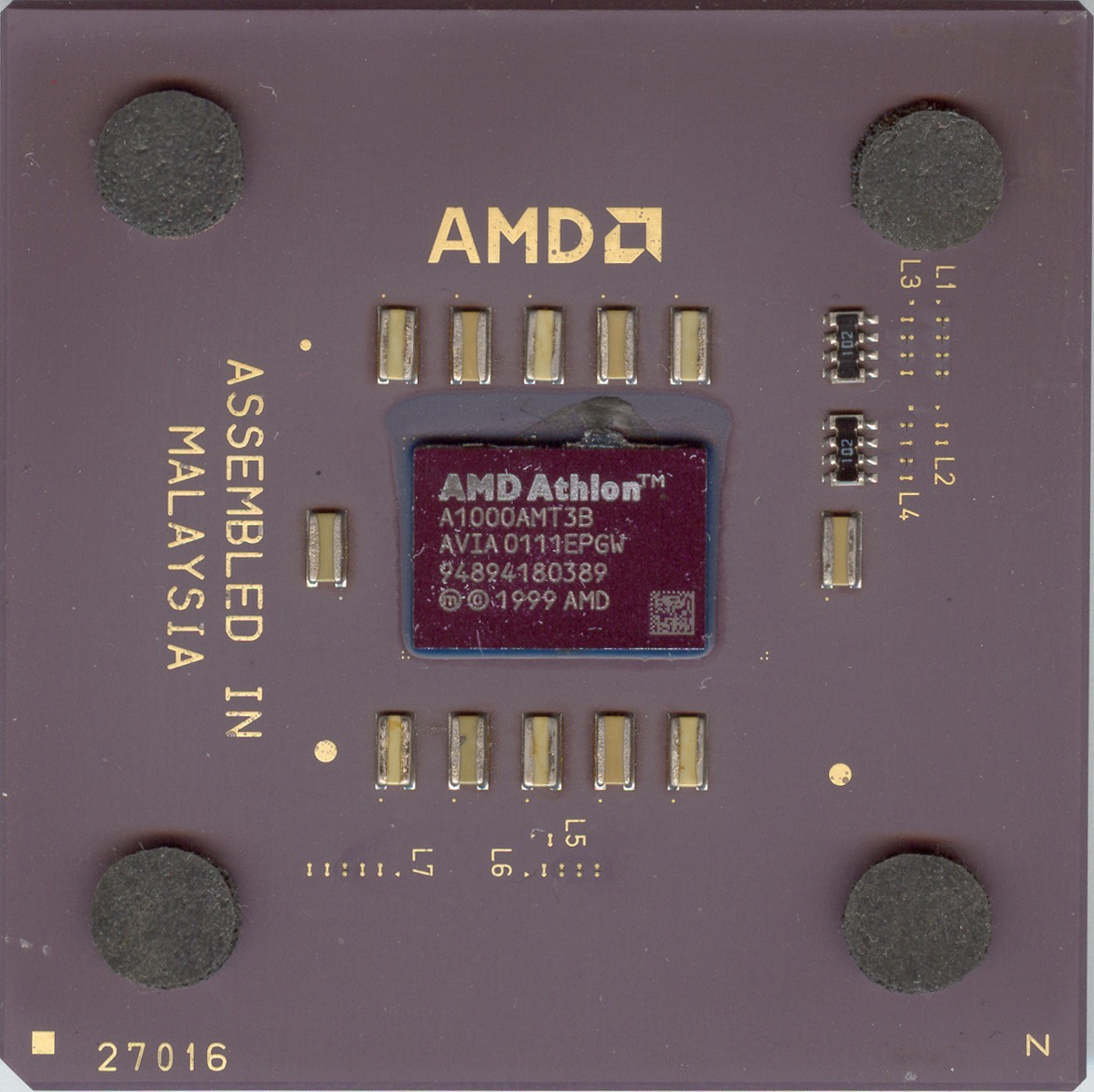

Microprocesador AMD Athlon (K7) (1999) |

|

|

|

El Athlon original, Athlon Classic, fue el primer procesador x86 de séptima generación. Nunca antes había ocurrido que el primer micro de una nueva generación de microprocesadores (7ª) no fuera Intel. Advanced Micro Devices (AMD) se fundó el 1 de mayo de 1969 por un grupo de ejecutivos de Fairchild Semiconductor, desde entonces es el segundo proveedor de microprocesadores basados en la arquitectura x86, tras Intel. Sin embargo las cosas cambian en 1995, cuando AMD desarrolla su primer procesador completamente nuevo: el AMD K5. Este primer modelo resulta interesante por tener una arquitectura RISC, con un traductor x86 integrado para que los PCs de la época pudieran entender las instrucciones emitidas por el procesador. La "K" es una referencia a la kriptonita que, como sabemos, es la única sustancia que puede perjudicar a Superman (en una clara referencia a Intel, que dominaba en el mercado en ese momento). El número "5" se refiere a la quinta generación de procesadores, en la cual Intel introdujo el nombre Pentium, debido a que la Oficina de Patentes de los Estados Unidos dictaminó que un solo número no podía ser registrado como marca. En ese mismo año, AMD adquirió NexGen, fabricante de procesadores de arquitectura RISC, a cuyo equipo de diseño dio un edificio propio, los dejó solos, y les dio tiempo y dinero para reelaborar el Nx686. El resultado fue el procesador K6, introducido en 1995 y 1996; algunas versiones como el K6-3/450 fueron más rápidas que el Pentium II de Intel (procesador de sexta generación). AMD comenzaba a enseñar sus dientes. El procesador Athlon se lanzó al mercado el 21 de agosto de 1999. El primer núcleo del Athlon, conocido en clave como "K7" (en homenaje a su antecesor, el K6), estuvo disponible inicialmente en versiones de 500 a 650 MHz, siendo desde entonces un serio rival para los microprocesadores Intel. Y es precisamente un microprocesador Athlon, el Athlon Thunderbird A1000AMT3B, lanzado en el año 2000, el que se convierte en el primer microprocesador para PCs capaz de alcanzar 1 GHz de velocidad. En 2003, AMD lanza su nueva línea de procesadores Athlon 64, las primeras CPUs de 64 bit para PC. |

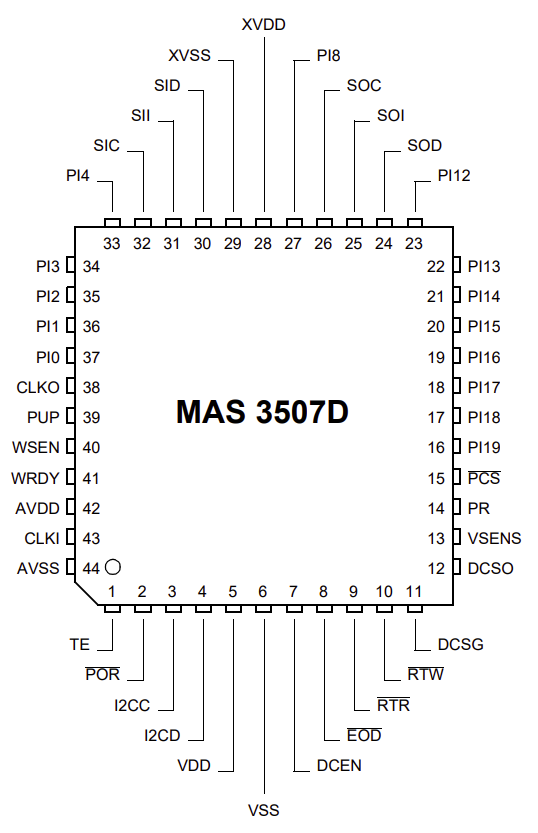

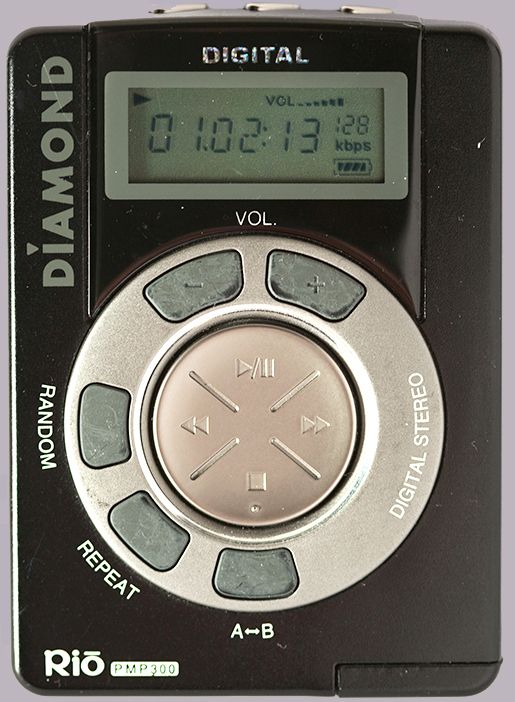

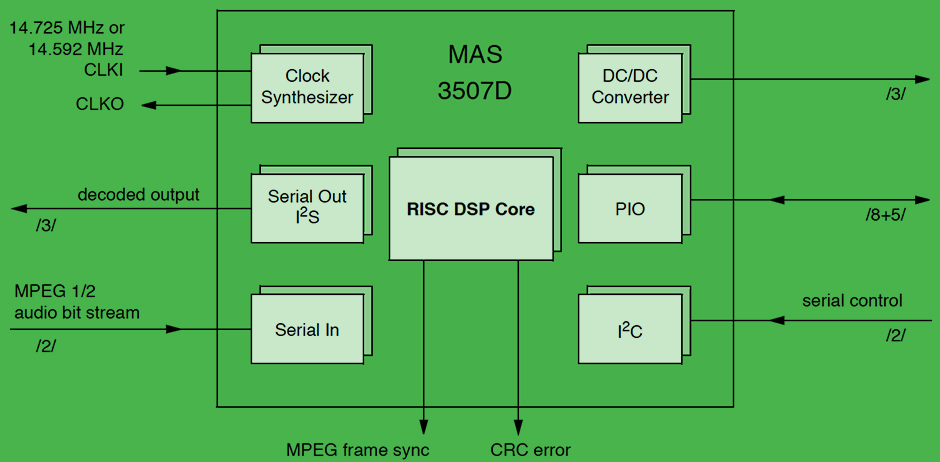

Decodificador de MP3 Micronas Semiconductor MAS3507 (1997) |

|

|

|

Este chip inició la revolución de la música digital. Antes del iPod, estaba el Diamond Rio PMP300... aunque entendemos que no lo recuerdes. Lanzado en 1998, el PMP300 se convirtió en un éxito instantáneo, pero luego el entusiasmo se desvaneció más rápido que Milli Vanilli. Sin embargo, una cosa fue notable sobre este dispositivo. Llevaba el chip decodificador de MP3 MAS3507, un procesador digital de señal, de arquitectura RISC con un conjunto de instrucciones optimizado para la compresión y descompresión de audio. El chip, desarrollado por Micronas (ahora TDK-Micronas), permitió que Rio metiera alrededor de una docena de canciones en su memoria flash. Si, ese es un número ridículo para los estándares actuales, pero en ese momento era suficiente para competir con los reproductores de CD portátiles, que tenían una tendencia a dar saltos en la reproducción si se les movía mucho. El Rio y sus sucesores allanaron el camino para el iPod, y ahora puedes llevar miles de canciones (y todos los álbumes y videos musicales de Milli Vanilli) en tu bolsillo. |

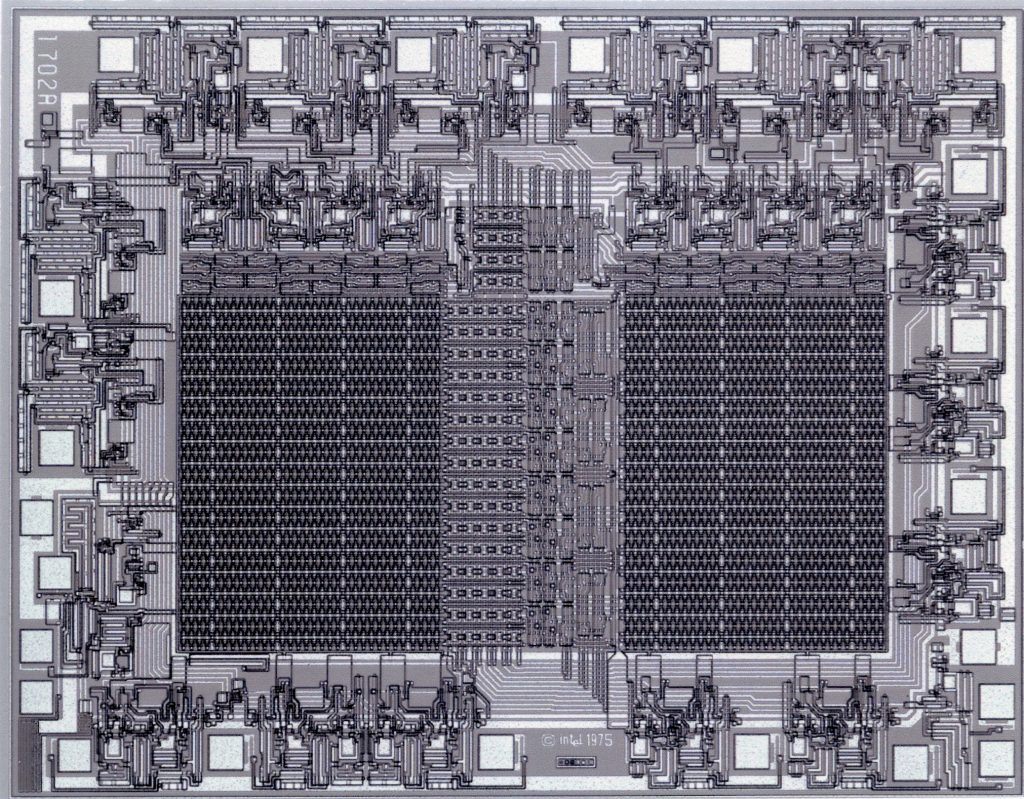

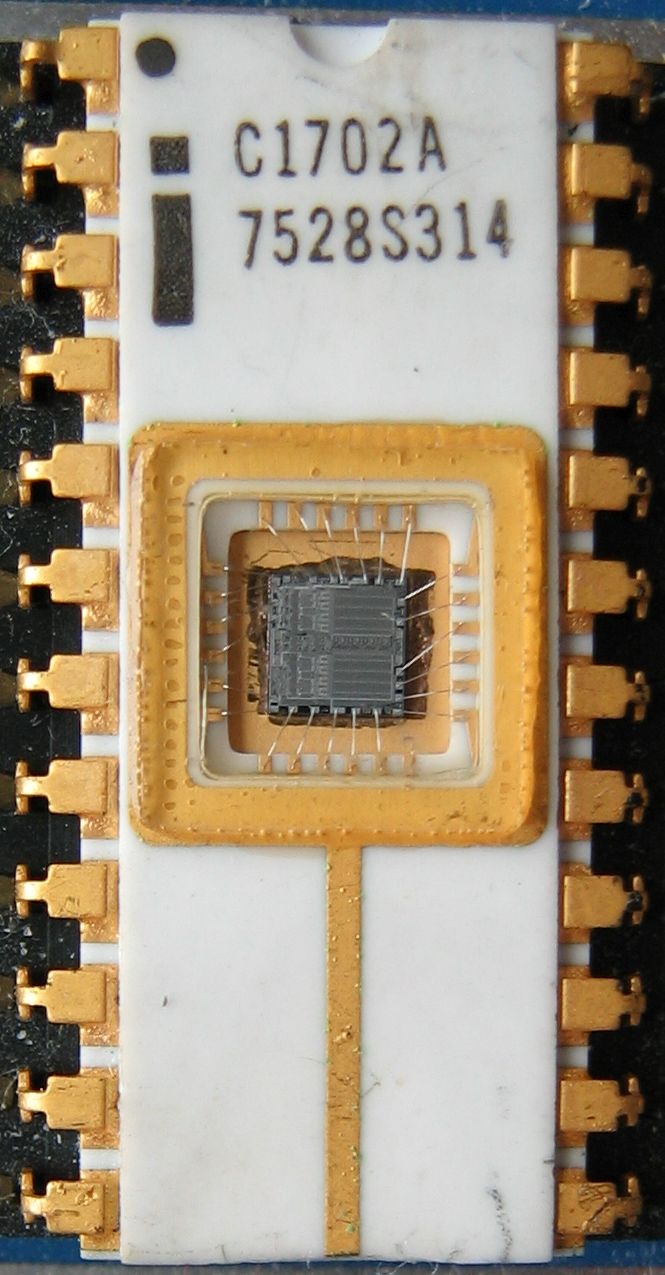

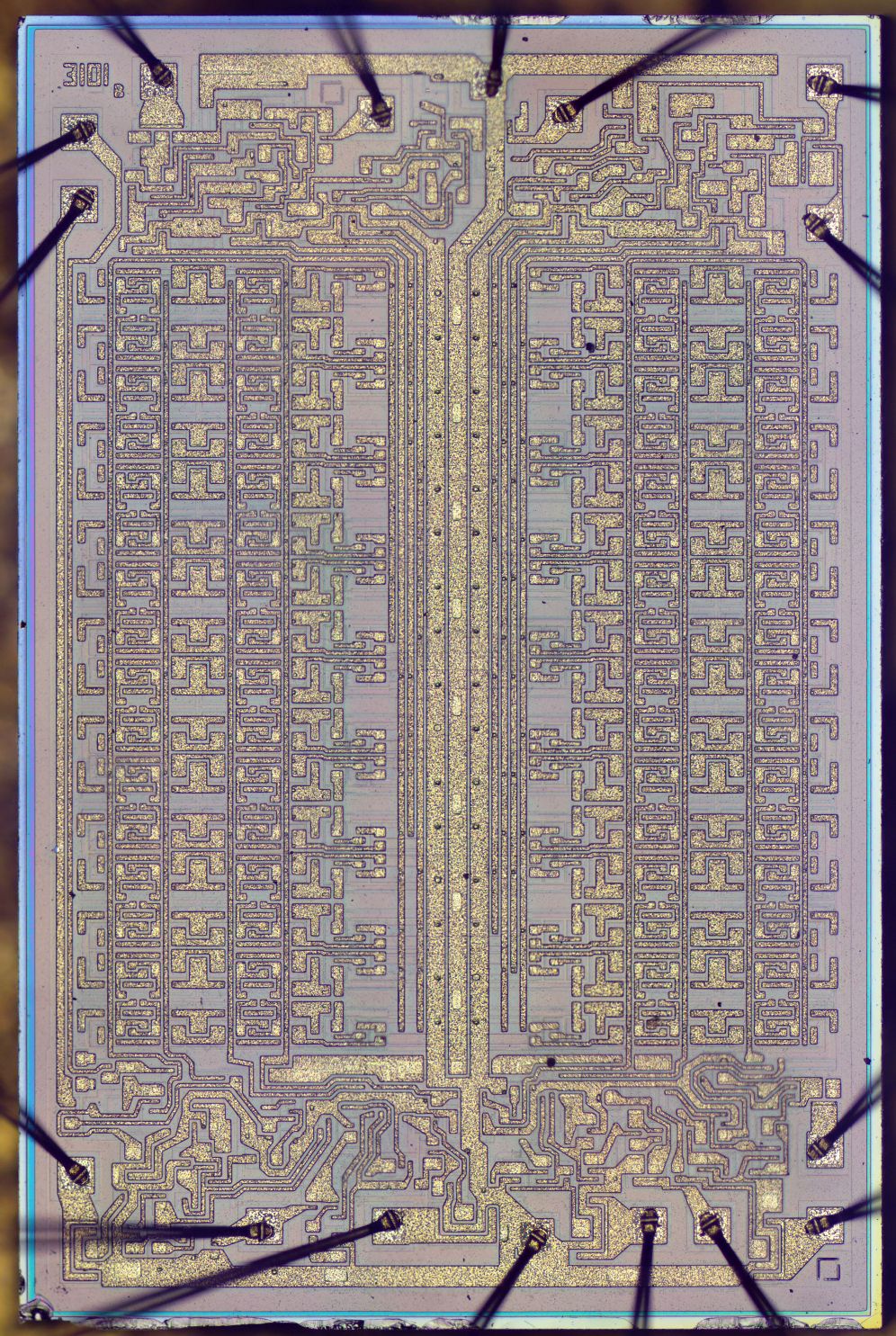

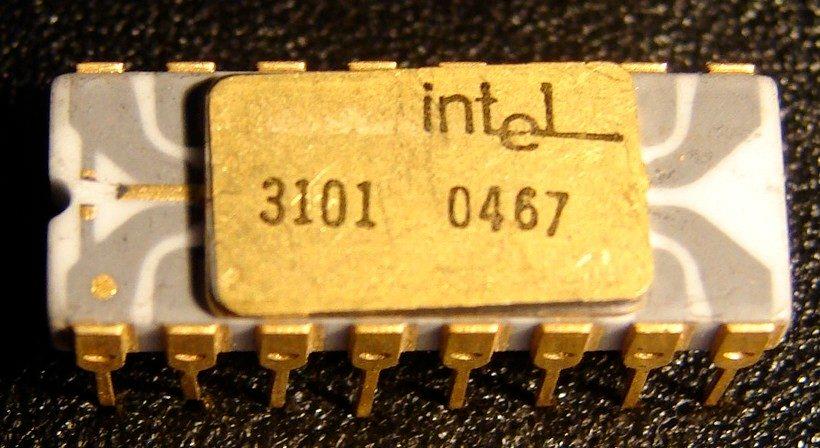

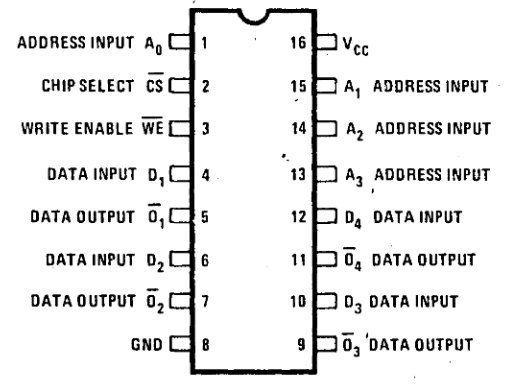

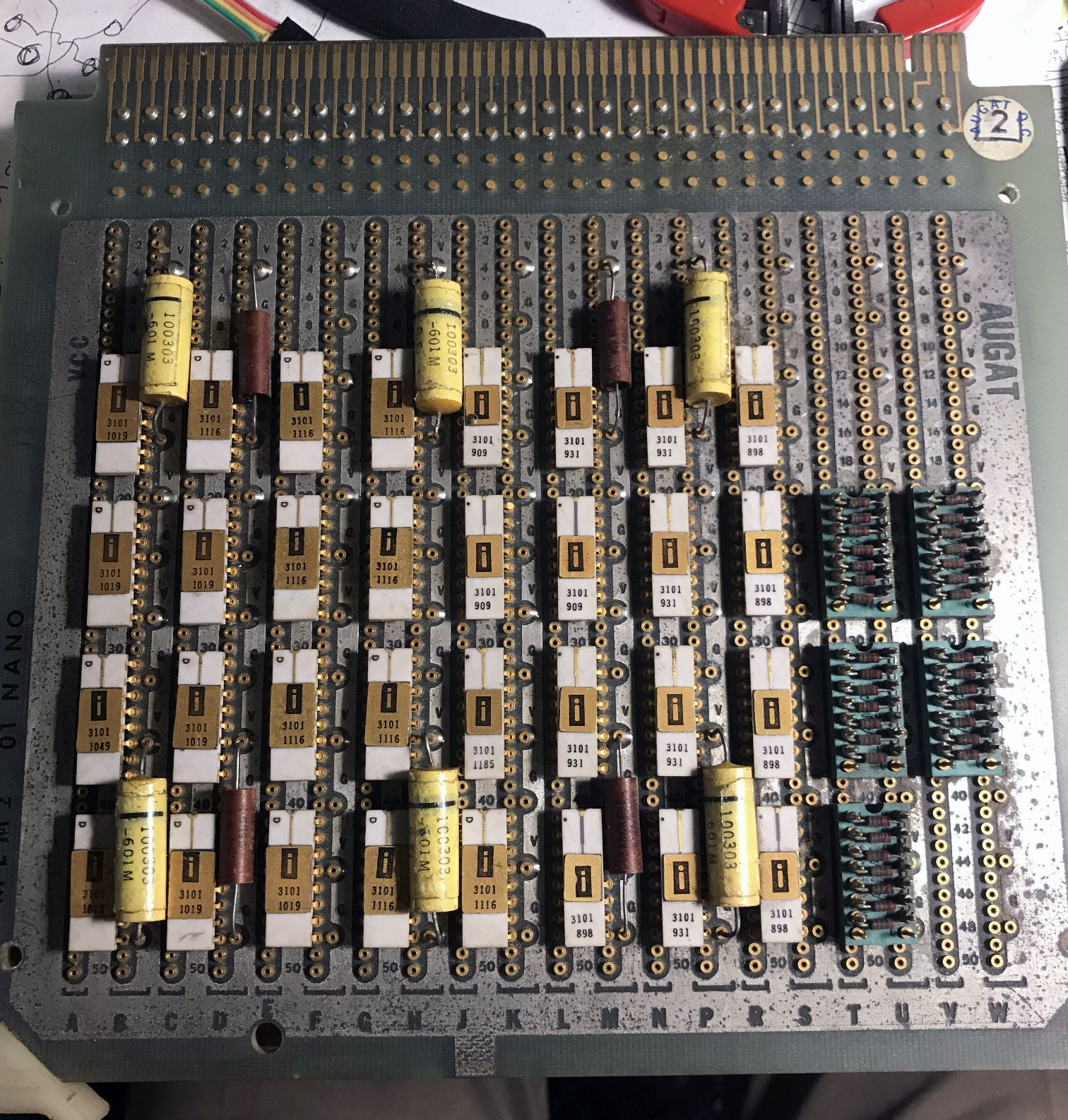

Chip de memoria SRAM Intel 3101 de 64 bits (1969) |

|

|

|

El 3101 es el primer producto comercial de Intel, y el primer chip de memoria RAM estática. Intel se fundó en Mountain View, California, en 1968 por Gordon E. Moore (sí, el mismo de "la Ley de Moore"), químico, y Robert Noyce, físico y coinventor del circuito integrado basado en silicio, ambos antiguos empleados de Fairchild. Arthur Rock (inversor de capital-riesgo) les ayudó a encontrar inversores, mientras que Max Palevsky estuvo a bordo desde los comienzos. Su primer producto, y así empezaron fuerte en el competitivo mercado de la memoria de acceso rápido, se comercializa en 1969, el Intel 3101, el primer chip de memoria estática de acceso aleatorio (SRAM, por sus siglas en inglés), de 64 bits de capacidad. Si, podría parecer una capacidad realmente despreciable hoy en día pero en 1969 y en un encapsulado de 16 pines era toda una innovación, sobre todo porque, al estar basado el Intel 3101 en transistores bipolares Schottky y tecnología TTL, era dos veces más rápido que los chips de memoria de Fairchild, incluyendo los de otras compañías. En el mismo año, Intel lanzó el 3301, un chip de ROM de 1024 bits basado en la misma tecnología que el 3101, y el primer chip comercial basado en transistores MOSFET, el 1101, con 256 bits de SRAM. |

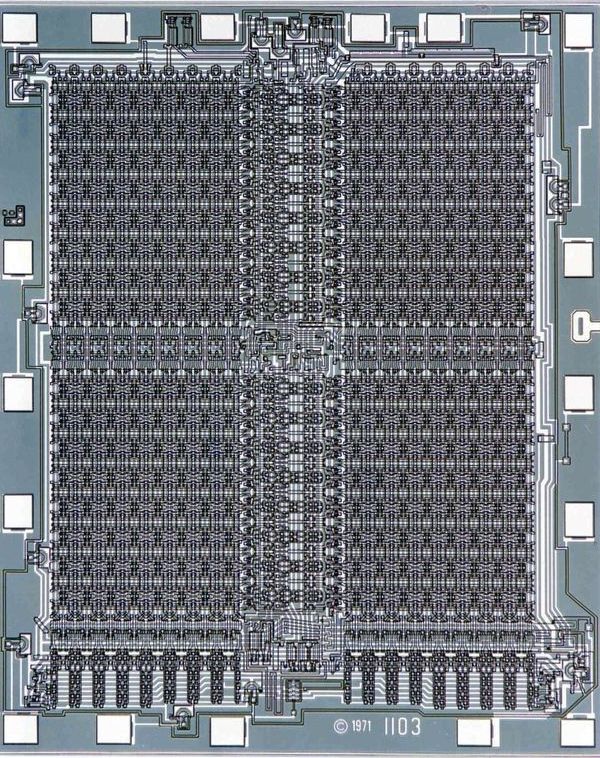

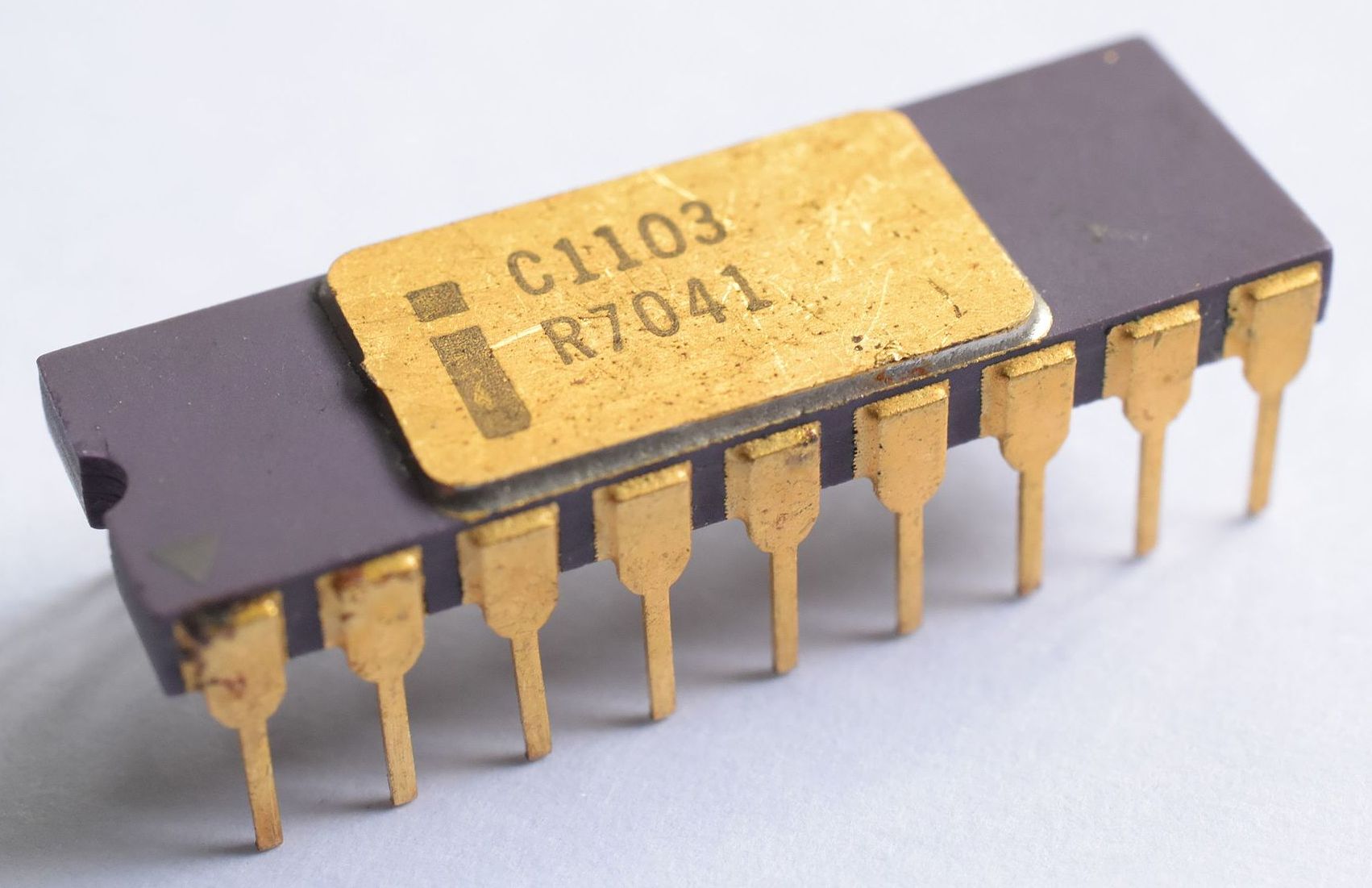

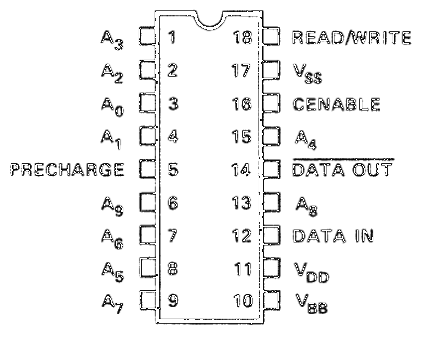

Chip de memoria DRAM Intel 1103 de 1024 bits (1970) |

|

|

|

El Intel 1103 es el primer chip de memoria dinámica de acceso aleatorio (DRAM), y esta ampliamente reconocido como el chip que reemplazó a la memoria de núcleos de ferrita. Aclaremos algunos conceptos antes de entrar en detalles. Los ordenadores usan memoria de acceso aleatorio, o RAM, como su espacio de trabajo cuando la CPU ejecuta programas, y los chips de RAM pueden ser de dos tipos, RAM estática (SRAM) o dinámica (DRAM). Mientras el ordenador tenga corriente, la SRAM mantiene su contenido mientras que la DRAM necesita que se refresque su contenido continuamente. Pero la ventaja de la DRAM sobre la SRAM es que la simplicidad de sus celdas de memoria permite meter mucha mas capacidad en el mismo espacio. Por esa razón, la mayoría de los ordenadores actuales usan DRAM como memoria principal. En 1969 el 1101 (SRAM) fue un avance significativo, pero la complejidad de cada celda de memoria lo hacía demasiado lento y costoso para las memorias de los mainframes de la época. Para resolver esos problemas, la aún joven compañía Intel lanzó en 1970 el 1103, la primera RAM dinámica comercial de 1024 bits. En un chip de 18 pines y con un coste de sólo 1 centavo por bit (3 transistores por celda + 1 condensador) era un competidor imbatible para la tradicional memoria de núcleos de ferrita. El éxito fue total. En 1971, 14 de los 18 principales fabricantes de computadores ya usaban el Intel 1103, y en 1972 el 1103 se convirtió en el chip de memoria más vendido en el mundo, jubilando definitivamente a la memoria de núcleos de ferrita, ganándose merecidamente el apodo de "core (memory) killer". El primer ordenador comercial que usó la DRAM del 1103 fue la serie HP 9800. Gordon Moore dice: "Hay montones de grandes chips pero uno siempre será muy especial para mi, el Intel 1103. Fue el chip que realmente volvió a Intel muy rentable. Incluso hoy, cuando miro a mi reloj digital y veo que son las 11:03, no puedo evitar recordar este producto clave en la historia de Intel". Chip favorito de Gordon Moore (cofundador y presidente emérito de Intel) y de Morris Chang (fundador de TSMC). |

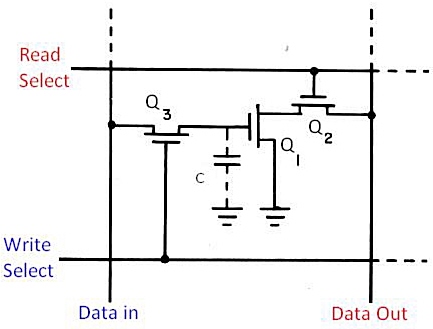

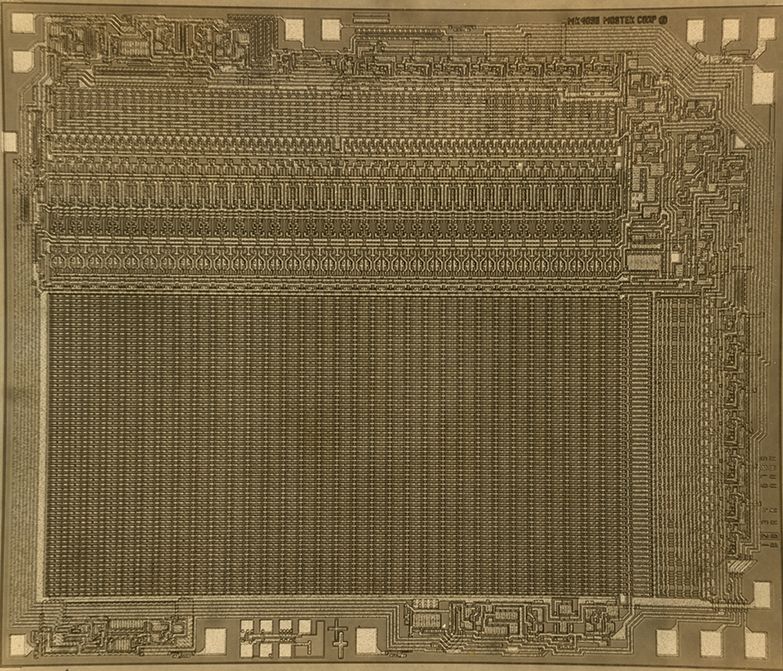

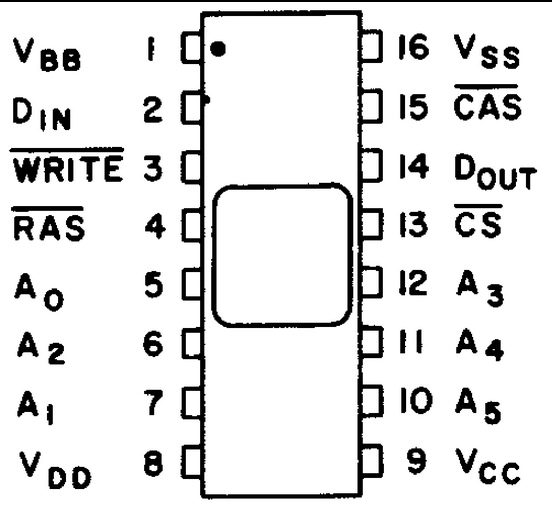

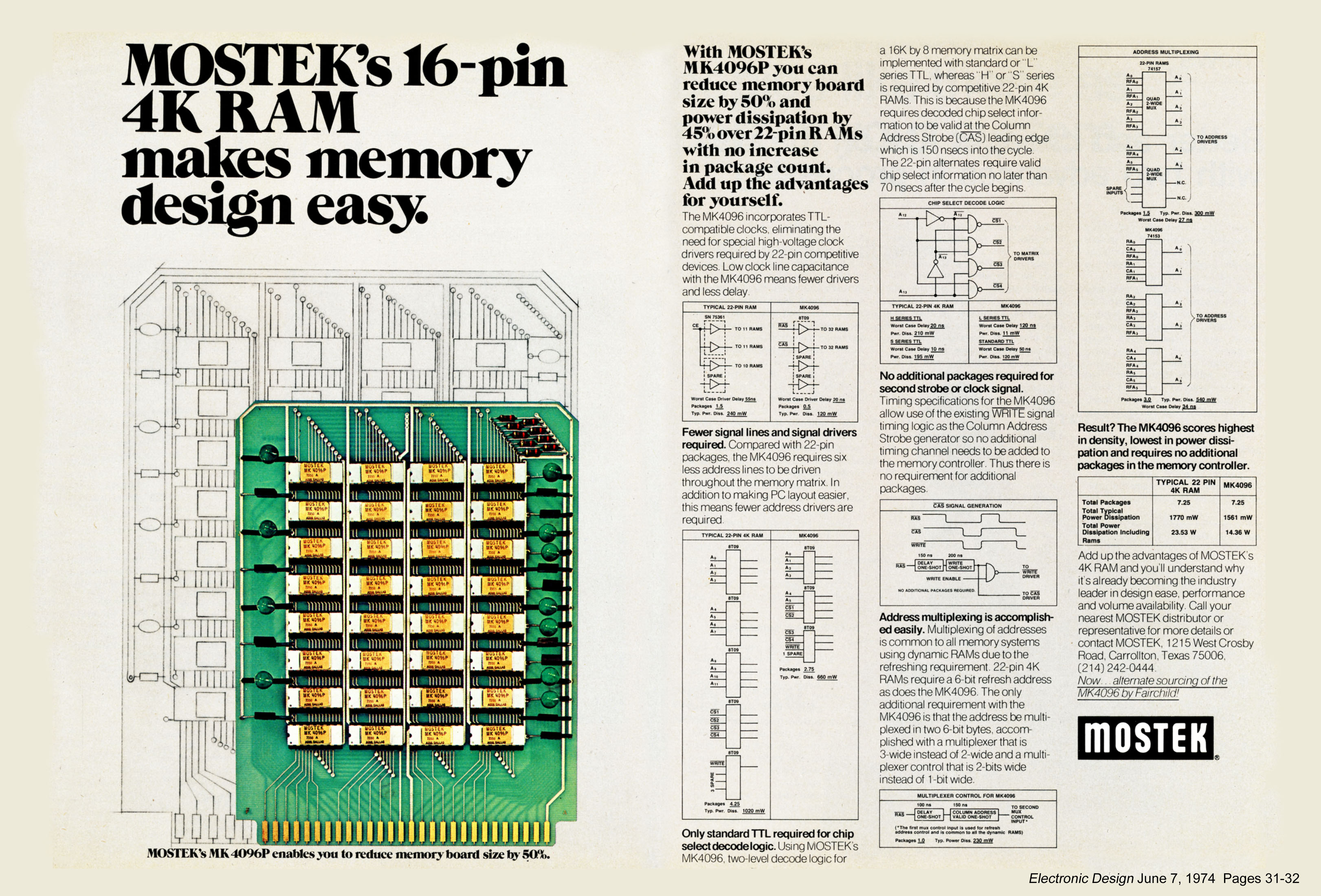

Chip de memoria DRAM Mostek MK4096 de 4Kbits (1973) |

|

|

|

La arquitectura básica de este chip de memoria se sigue utilizando siempre que se necesita más de una pequeña cantidad de RAM. El primer chip DRAM fue lanzado por Intel en 1970, el 1103. Pero el chip DRAM de 4 kilobits de Mostek produjo una innovación clave, un truco de circuitos llamado multiplexación de direcciones, inventado por el cofundador de Mostek, Bob Proebsting. Básicamente, el chip usaba los mismos pines para acceder a las filas y columnas de la memoria. Lo hizo enviando señales de direccionamiento de filas y columnas por turnos, en lugar de todas a la vez, como en diseños anteriores. Como resultado, el chip no requería más pines a medida que aumentaba la densidad de la memoria y se podía fabricar por menos dinero. Sólo hubo un pequeño problema de compatibilidad: el 4096 usaba 16 pines, mientras que las memorias hechas por Texas Instruments, Intel, y Motorola tenían 22 pines. Lo que siguió fue uno de los enfrentamientos más épicos en la historia de la DRAM. Con Mostek apostando su futuro en el chip, sus ejecutivos se propusieron hacer proselitismo entre sus clientes, socios, la prensa e incluso entre su personal. Fred K. Beckhusen, quien fue contratado por entonces para probar los chips 4096, recuerda cuando Proebsting y el director ejecutivo L.J. Sevin llegaron a su turno de noche para dar un seminario, a las 2 de la mañana. “Predijeron audazmente que en seis meses nadie escucharía o se preocuparía por los chips DRAM de 22 pines ”, dice Beckhusen. Y acertaron. El 4096 y sus sucesores se convirtieron en la DRAM dominante durante años, y la multiplexación de direcciones se convirtió en la forma estándar de manejar memorias cada vez más grandes. Chip favorito de Charles G. Sodini (profesor del MIT). |

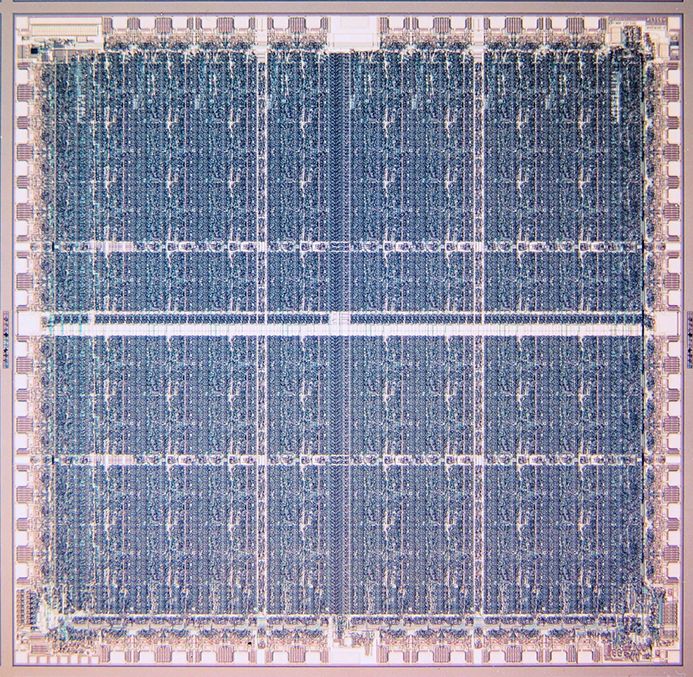

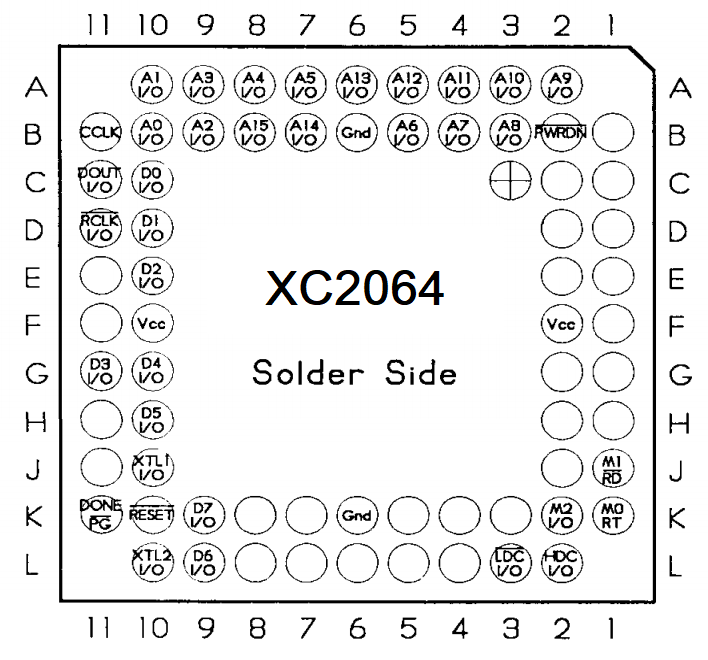

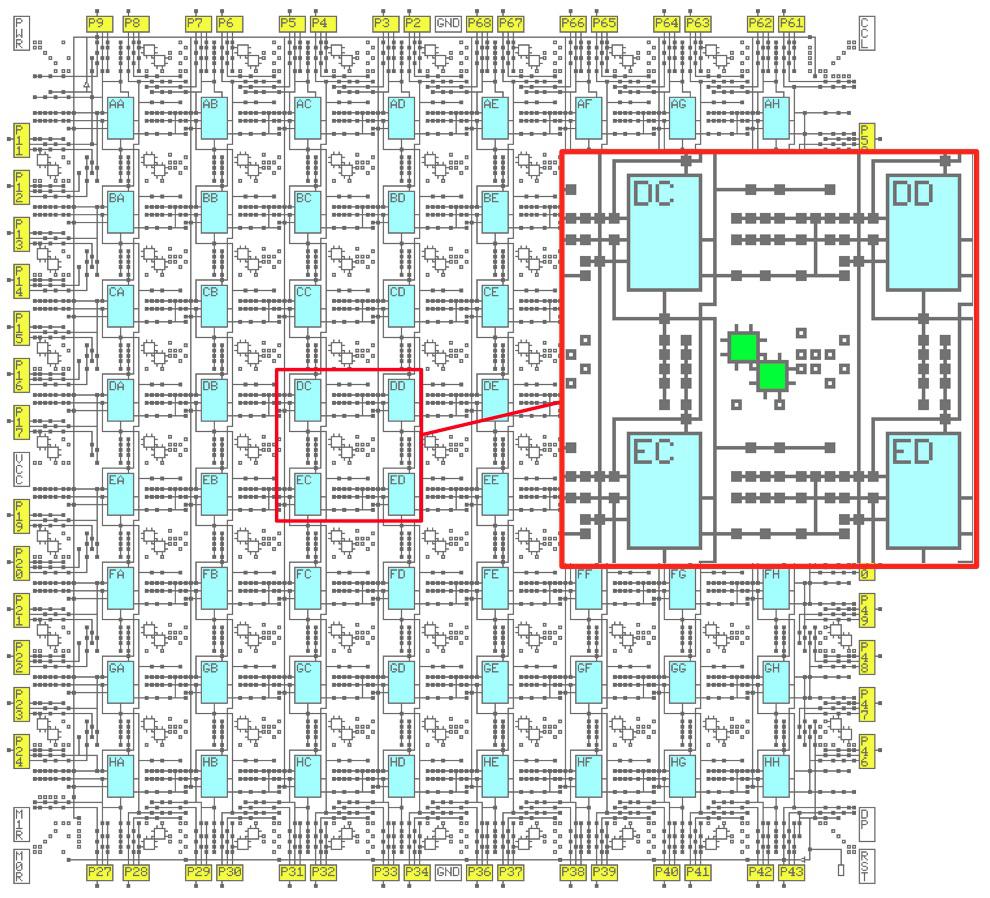

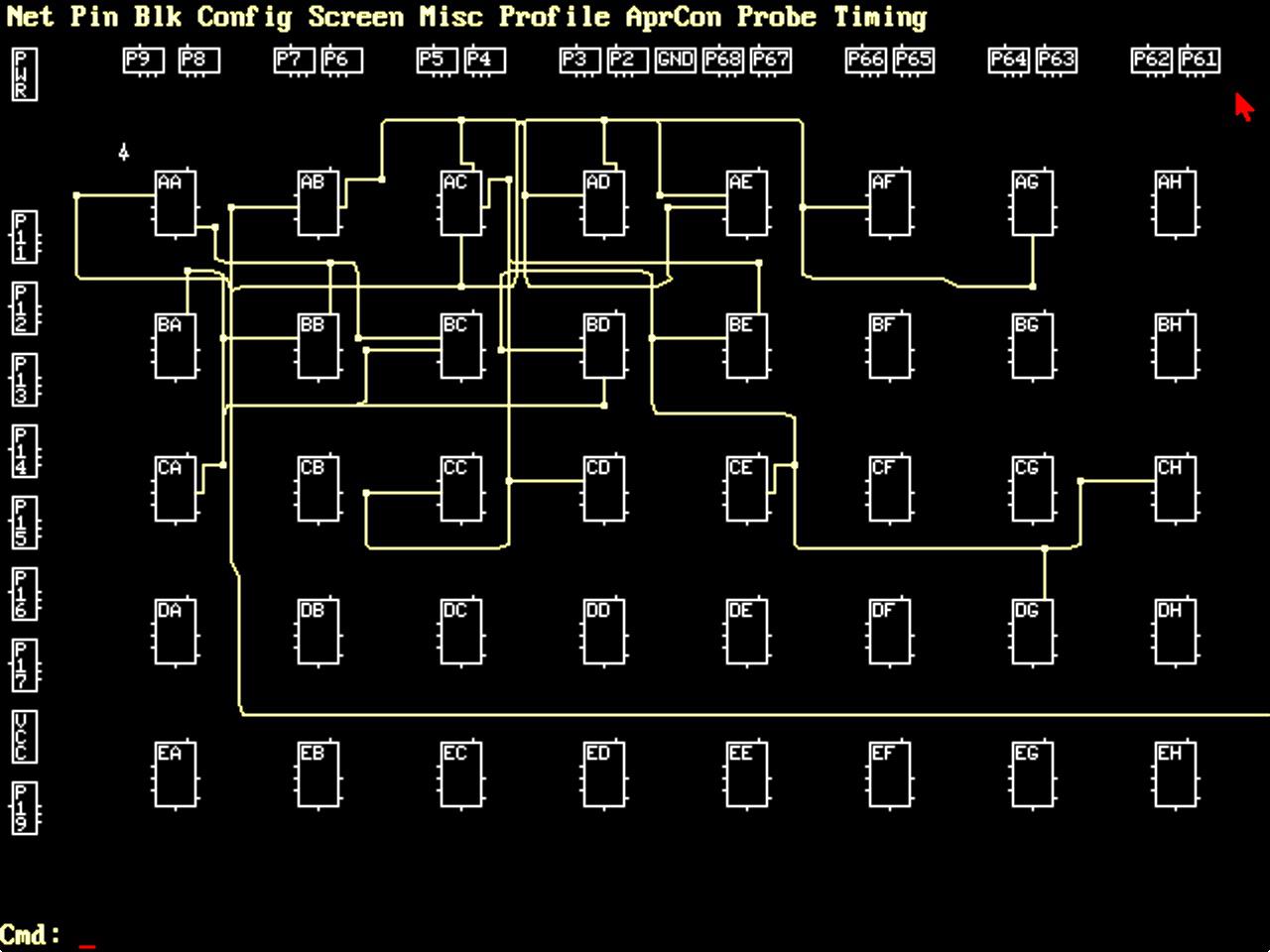

FPGA Xilinx XC2064 (1985) |

|

|

|

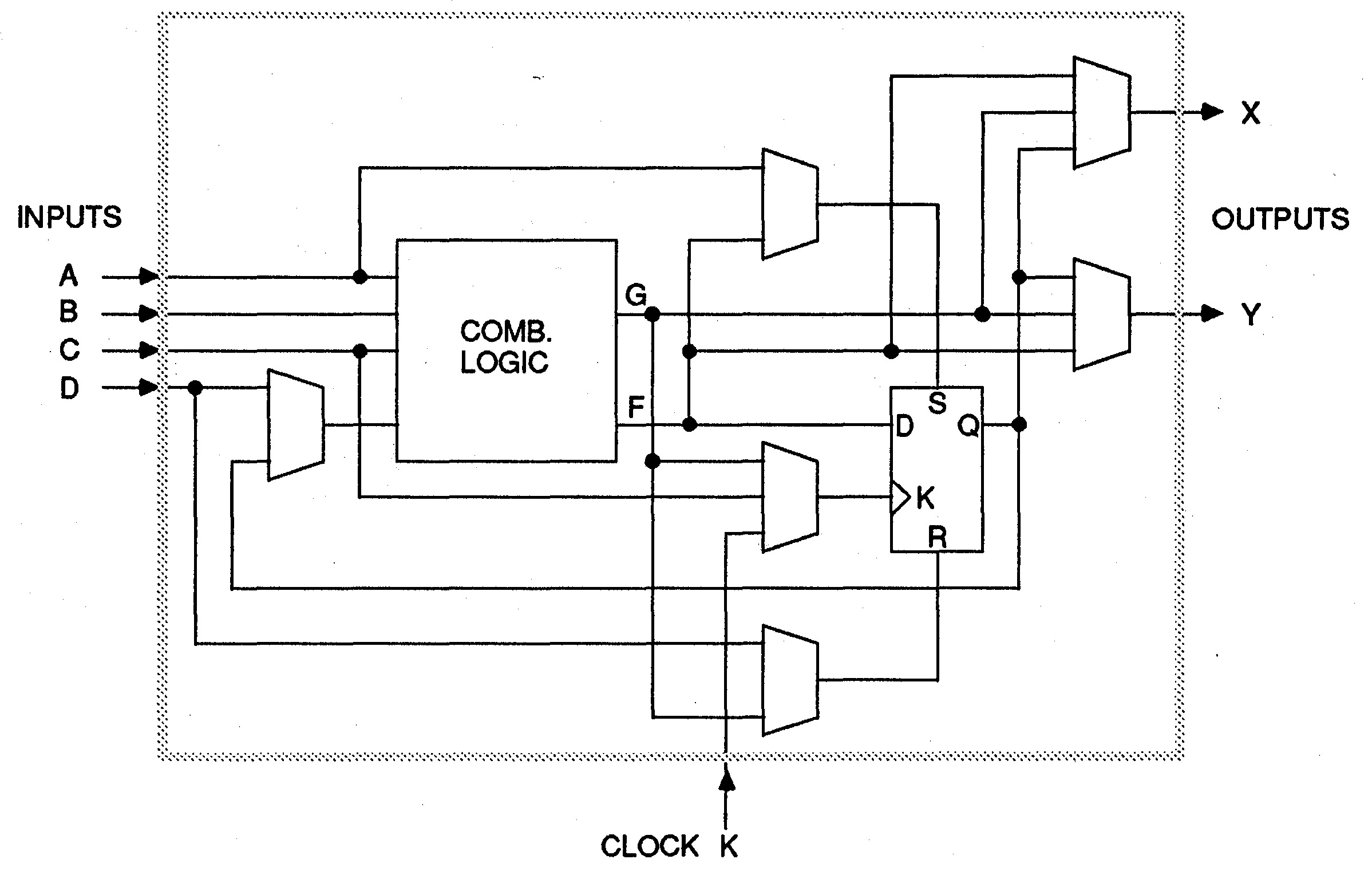

La primera FPGA, un chip con transistores organizados en bloques lógicos cuyas conexiones pueden reconfigurarse por software. Hoy en día las FPGAs pueden encontrarse en todo tipo de equipos informáticos. A principios de la década de 1980, los diseñadores de chips intentaron aprovechar al máximo todos y cada uno de los transistores de sus circuitos. Pero luego Ross Freeman tuvo una idea bastante radical. Se le ocurrió un chip lleno de transistores que formaban bloques lógicos con conexiones que podían configurarse y reconfigurarse por software. Como resultado, a veces no se usarían un montón de transistores (¡herejía!), pero Freeman apostaba a que la ley de Moore eventualmente haría que los transistores fueran tan baratos que a nadie le importaría. Y acertó de pleno. Para comercializar su chip, llamado matriz de puertas de programables, o FPGA (Field-Programmable Gate Array), Freeman cofundó Xilinx (un concepto extraño requería un nombre de empresa igual de extraño). Cuando en 1985 sale el primer producto de la empresa, el XC2064, a los empleados se les asignó una tarea: tenían que dibujar, a mano, un circuito de ejemplo utilizando los bloques lógicos del XC2064, tal como lo harían los clientes de Xilinx. Bill Carter, ex director de tecnología, recuerda que el director ejecutivo Bernie Vonderschmitt se le acercó y le dijo que tenía "un poco de dificultad para hacer los deberes". Carter estaba encantado de ayudar al jefe. "Allí estábamos", dice, "con papel y lápices de colores, ¡trabajando en las tareas de Bernie!" La FPGA inventada por Ross Freeman era mucho más simple que las FPGA modernas (incluye solamente 64 bloques lógicos, en comparación con los miles o millones de las FPGA modernas) pero fue el origen de la industria actual de FPGAs de miles de millones de dólares. Hoy en día, las FPGAs, vendidas por Xilinx y otros fabricantes, se utilizan en demasiadas cosas como para enumerarlas aquí de manera exhaustiva, pero se pueden encontrar en dispositivos como radios definidas por software, redes neuronales, y enrutadores de centros de datos. ¡Viva la reconfiguración! |

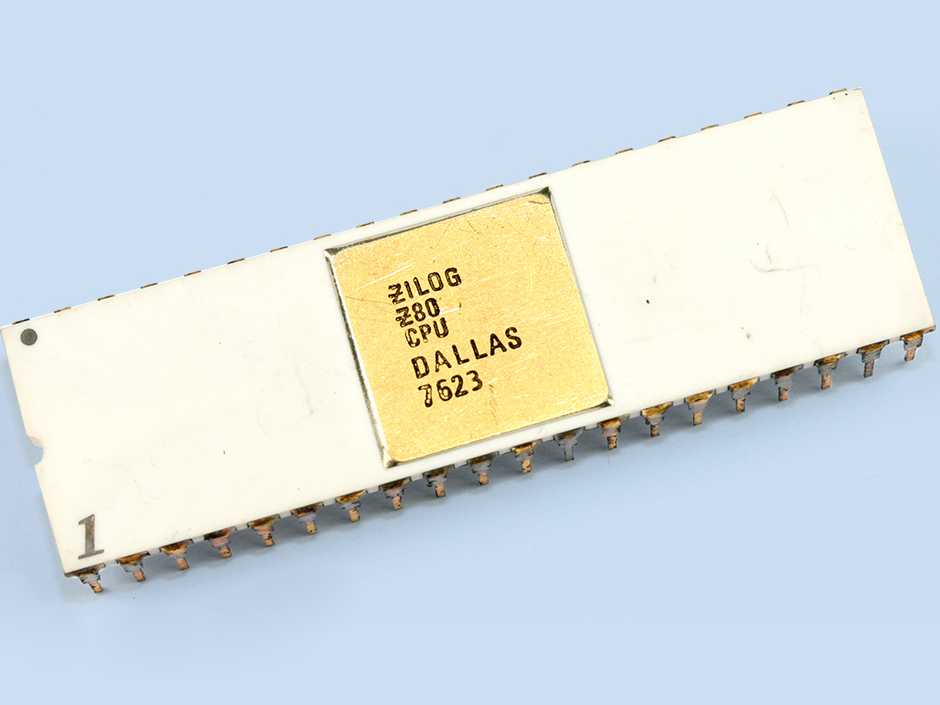

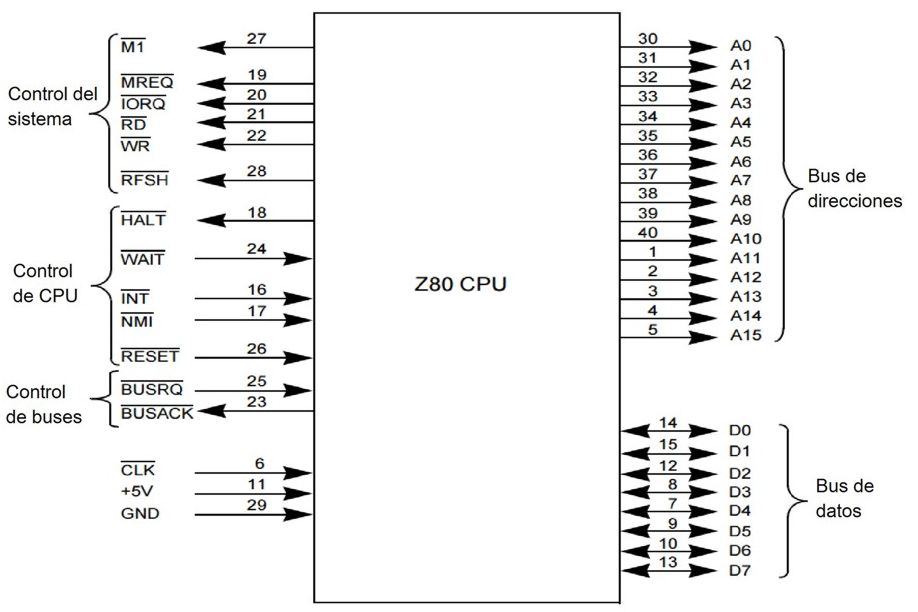

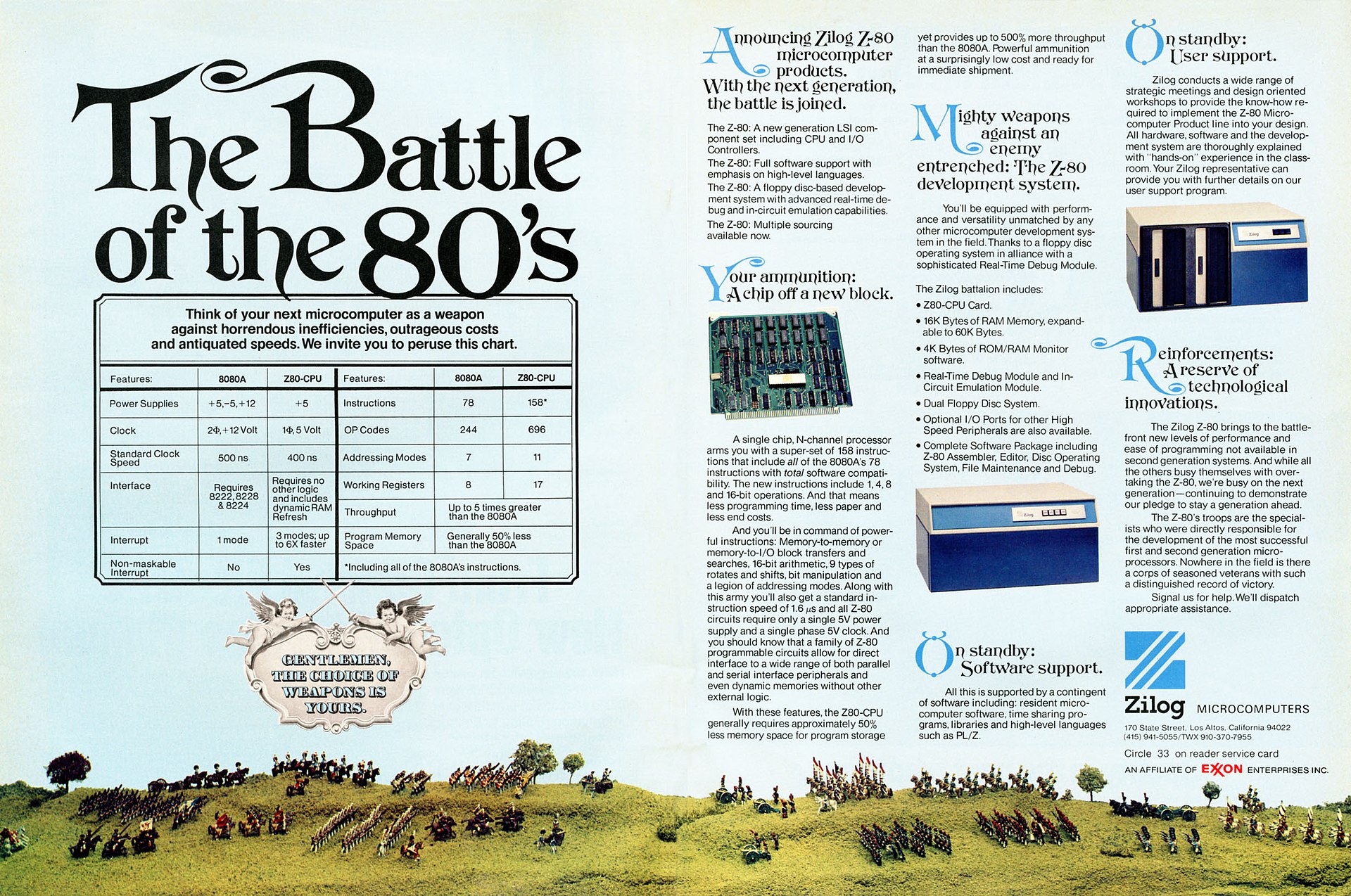

Microprocesador Zilog Z80 (1976) |

|

|

|

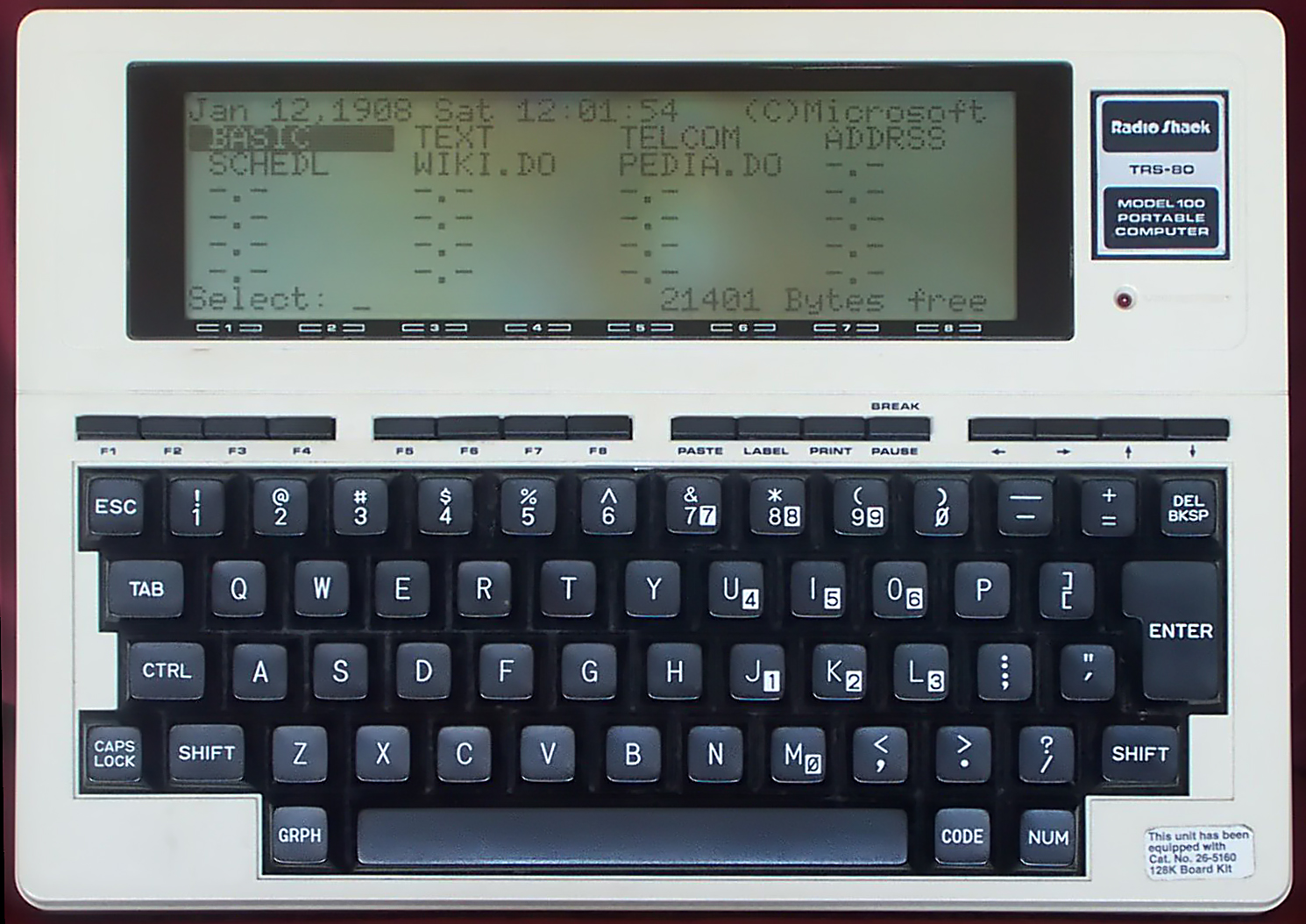

Una de las mayores leyendas de la era de los 8 bits, este procesador alimentó el primer ordenador portátil, así como los míticos Sinclair ZX Spectrum, MSX, y Amstrad CPC, y decenas de otros ordenadores personales de los 80. Federico Faggin conocía bien la cantidad de dinero y las horas de trabajo necesarias para comercializar un microprocesador. Mientras estaba en Intel, había contribuido a los diseños de dos buenos ejemplares: el primigenio 4004 y el 8080, que dió fama al Altair. Entonces, cuando fundó Zilog con su ex colega de Intel Ralph Ungermann, decidieron comenzar con algo más simple: un microcontrolador de un único chip. Aún así, su dedicación era tal que siempre comían queso Camenberg y galletas saladas compradas en el supermercado de enfrente. Pero los ingenieros pronto se dieron cuenta de que el mercado de los microcontroladores estaba repleto de chips muy buenos. Incluso si el suyo fuera mejor que los demás, las ganancias serían escasas... y seguirían comiendo queso y galletas saladas. Zilog tenía que apuntar más alto en la cadena alimentaria, por así decirlo, y nació el proyecto del microprocesador Z80. El objetivo era superar al 8080 y a la vez ofrecer compatibilidad total con el software del 8080, para alejar a los clientes de Intel. Durante meses, Faggin, Ungermann y Masatoshi Shima, otro ex ingeniero de Intel, trabajaron 80 horas a la semana encorvados sobre mesas, dibujando los circuitos del Z80. Faggin pronto aprendió que cuando se trata de microchips, lo pequeño es hermoso pero puede lastimar tus ojos. “Al final tuve que conseguir anteojos”, dice. "Me volví miope". El equipo trabajó duro durante 1975 y 1976. Y en marzo de ese año, finalmente tuvieron un prototipo del chip. El Z80 era un contemporáneo del 6502 de MOS Technology y, al igual que él, destacaba no sólo por su elegante diseño sino también por ser muy barato (alrededor de $25). El Z80 terminó en miles de productos, incluido el Osborne I (el primer ordenador portátil o "cargable") y los ordenadores domésticos Radio Shack TRS-80, Sinclair ZX Spectrum, MSX, Amstrad CPC, y decenas de otros ordenadores personales de los 80, así como en impresoras, máquinas de fax, fotocopiadoras, módems, y satélites. Zilog todavía fabrica el Z80, que es popular en algunos sistemas empotrados. En una configuración básica hoy en día cuesta alrededor de $5, no mucho más de lo que costaría una comida de queso y galletas saladas. |

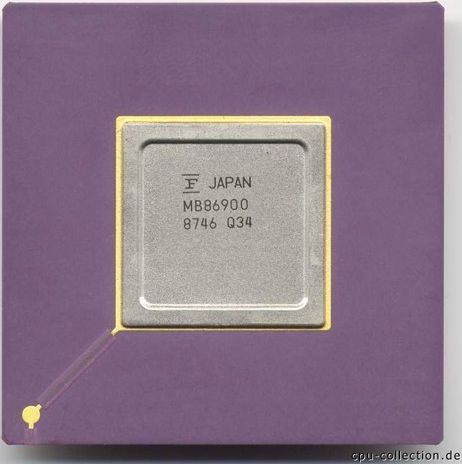

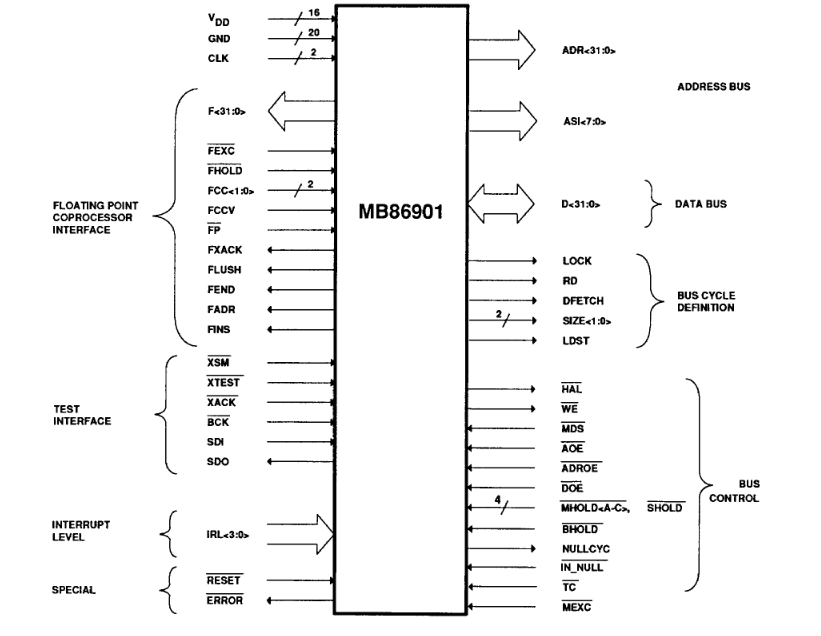

Microprocesador Sun Microsystems SPARC (1987) |

|

|

Categoría: Procesadores |

Utilizando una nueva arquitectura no probada antes, este procesador puso a Sun Microsystems en el mapa. Hubo una época, hace mucho tiempo (principios de la década de 1980), cuando la gente usaba calentadores de piernas de colores neón y veía la serie "Dallas", y los arquitectos de microprocesadores buscaban aumentar la complejidad de las instrucciones de la CPU como una forma de hacer más cosas en cada ciclo de reloj. Pero un grupo de la Universidad de California en Berkeley (siempre un bastión de la contracultura), pidió justo lo contrario: simplifiquen el conjunto de instrucciones, dijeron, y procesarán las instrucciones a un ritmo tan rápido que compensará con creces el hacer menos cosas en cada ciclo. El grupo de Berkeley, liderado por David Patterson, llamó a su enfoque RISC (Reduced-Instruction-Set Computing). Como estudio académico RISC sonaba genial. ¿Pero era comercializable? Sun Microsystems apostó por ello. En 1984, un pequeño equipo de ingenieros de Sun se propuso desarrollar un procesador RISC de 32 bits llamado SPARC (Scalable Processor ARChitecture). La idea era utilizar los chips en una nueva línea de estaciones de trabajo. Un día, Scott McNealy, entonces director ejecutivo de Sun, se presentó en el laboratorio de desarrollo de SPARC. "Dijo que SPARC llevaría a Sun de una empresa de 500 millones de dólares al año a una empresa de mil millones de dólares al año", recuerda Patterson, consultor del proyecto SPARC. Por si eso no fuera suficiente presión, muchos fuera de Sun habían expresado dudas de que la empresa pudiera lograrlo. Peor aún, el equipo de marketing de Sun se había dado cuenta de algo aterrador: SPARC deletreado al revés era ... ¡CRAPS! (juego de dados). Los miembros del equipo tenían que jurar que no dirían esa palabra a nadie, incluso dentro de Sun, para que no se corriera la voz a su archirrival MIPS Technologies, que también estaba explorando el concepto RISC. La primera versión del SPARC minimalista fue el chip Fujitsu MB86900 (también conocido como SF9010) que se utilizó como CPU del servidor Sun 4/260 'Sunrise' y el 4/110 'Cobra', el primer ordenador de sobremesa SPARC (1987). Consistía en un "procesador con una matriz de 20.000 puertas lógicas sin siquiera instrucciones de multiplicar/dividir enteros", dice Robert Garner, el arquitecto líder de SPARC y ahora investigador de IBM. Sin embargo, a 10 millones de instrucciones por segundo, funcionaba aproximadamente tres veces más rápido que los más clásicos procesadores CISC (Complex-Instruction-Set Computer) de la época. Sun utilizaría SPARC como la CPU de las rentables estaciones de trabajo y servidores que crearía durante los próximos años, y que rápidamente dominarían el mercado, ayudando a impulsar los ingresos de la empresa más allá de los mil millones de dólares, tal como había profetizado McNealy. |

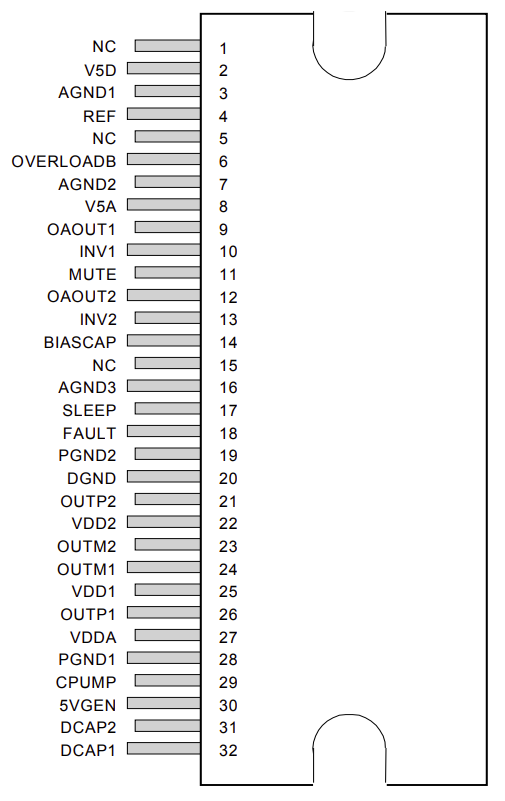

Amplificador de audio Tripath Technology TA2020 (1998) |

|

|

|

Este amplificador de estado sólido de alta potencia llevó un gran sonido a dispositivos económicos. Hay un subconjunto de audiófilos que insisten en que los amplificadores basados ??en tubos de vacío producen el mejor sonido y siempre lo harán. Entonces, cuando algunos en la comunidad del audio afirmaron que un amplificador basado únicamente en semiconductores brindaba un sonido tan cálido y vibrante como los amplificadores de válvulas, hubo una gran controversia. El amplificador en cuestión era un amplificador de clase D inventado por una empresa de Silicon Valley llamada Tripath Technology. Los amplificadores de clase ?D funcionan al no intentar amplificar la señal de audio analógica entrante directamente, sino que primero la convierten en un flujo de pulsos digitales que se pueden usar para encender y apagar los transistores de potencia. La señal resultante se vuelve a convertir en una señal analógica con una mayor amplitud. El truco de Tripath consistía en utilizar un sistema de muestreo de 50 MHz para impulsar el amplificador. La compañía se jactó de que su chip TA2020 funcionaba mejor y costaba mucho menos que cualquier amplificador de estado sólido comparable. Para mostrar el chip en las ferias comerciales, "tocábamos esa canción tan romántica de la película 'Titanic'", dice Adya Tripathi, fundador de Tripath. Como la mayoría de los amplificadores de clase D, el TA2020 fue muy eficiente en términos de energía; no requería un disipador de calor y podría usar un encapsulado compacto. La versión de gama baja del TA2020, de 15 vatios, se vendió por $3 y se utilizó en equipos de sonido portátiles y miniestéreos. Otras versiones (la más potente tenía una salida de 1000 W) se utilizaron en sistemas de cine en casa, sistemas de audio de alta gama, y televisores de Sony, Sharp, Toshiba, entre otros. Finalmente, las grandes empresas de semiconductores se pusieron al día, crearon chips similares y enviaron a Tripath al olvido. Sin embargo, sus chips se convirtieron en objetos de culto. Los kits y productos amplificadores de audio basados ??en el TA2020 y sus chips hermanos todavía están disponibles en compañías como Sure Electronics y Audiophonics. |

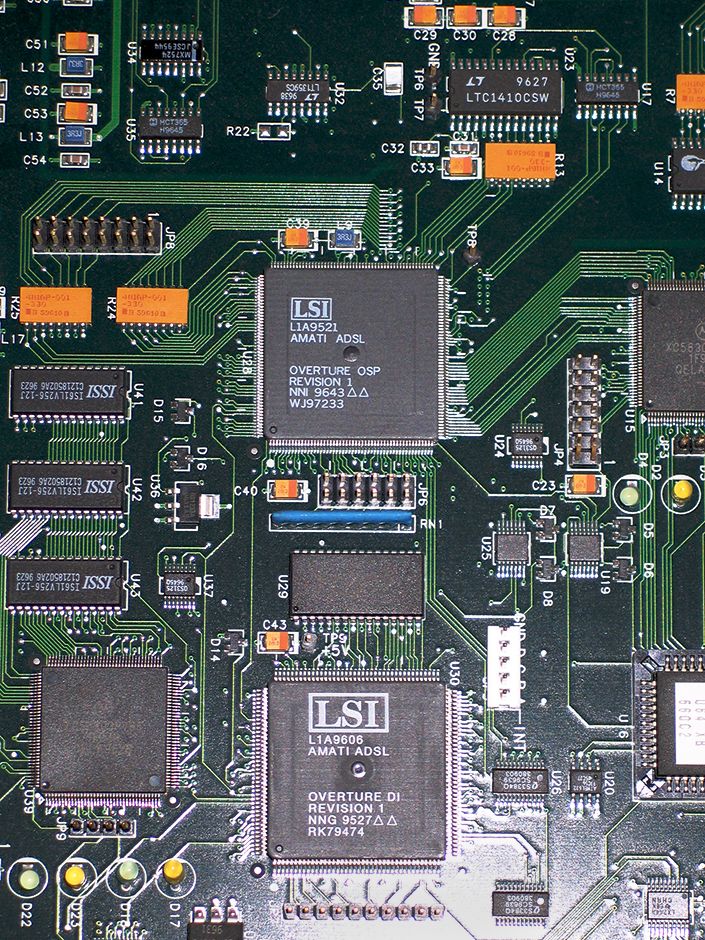

ADSL Amati Communications Overture Chip Set (1994) |

|

|

|

Este chip de comunicaciones ayudó a marcar el comienzo de la era del Internet de banda ancha. ¿Recuerdas cuando apareció ADSL y tiraste ese patético módem de 56,6 kilobits por segundo a la basura? Tu y las dos terceras partes de los usuarios de banda ancha del mundo que utilizaron ADSL deberían agradecerselo a Amati Communications. De acuerdo, unos años más tarde también terminaste tirando ese módem ADSL a la basura cuando se desplegaron las redes de banda ancha basadas en fibra óptica. Pero para muchos consumidores, ADSL fue la primera prueba de lo que se podía hacer con un acceso a Internet de alta velocidad, sobre todo como sistema de distribución de música y películas, y juegos online. El epicentro de esta revolución de la banda ancha fue Amati Communications, una startup de la Universidad de Stanford. En la década de 1990, se les ocurrió un enfoque de modulación ADSL llamado multitono discreto o DMT. Básicamente, es una forma de hacer que una línea telefónica parezca como cientos de subcanales y mejorar la transmisión mediante una estrategia de Robin Hood inversa: “Se roban bits de los canales más pobres y se entregan a los canales más ricos”, dice John M. Cioffi, cofundador de Amati y ahora profesor de ingeniería en Stanford. DMT superó los enfoques de la competencia, incluidos los de gigantes como AT&T, y se convirtió en un estándar global para ADSL. A mediados de la década de 1990, el chipset ADSL de Amati (uno analógico y dos digitales) se vendía en cantidades modestas, pero en 2000, el volumen había aumentado a millones. A principios de la década de 2000, las ventas superaron los 100 millones de chips por año. Texas Instruments compró Amati en 1997. |

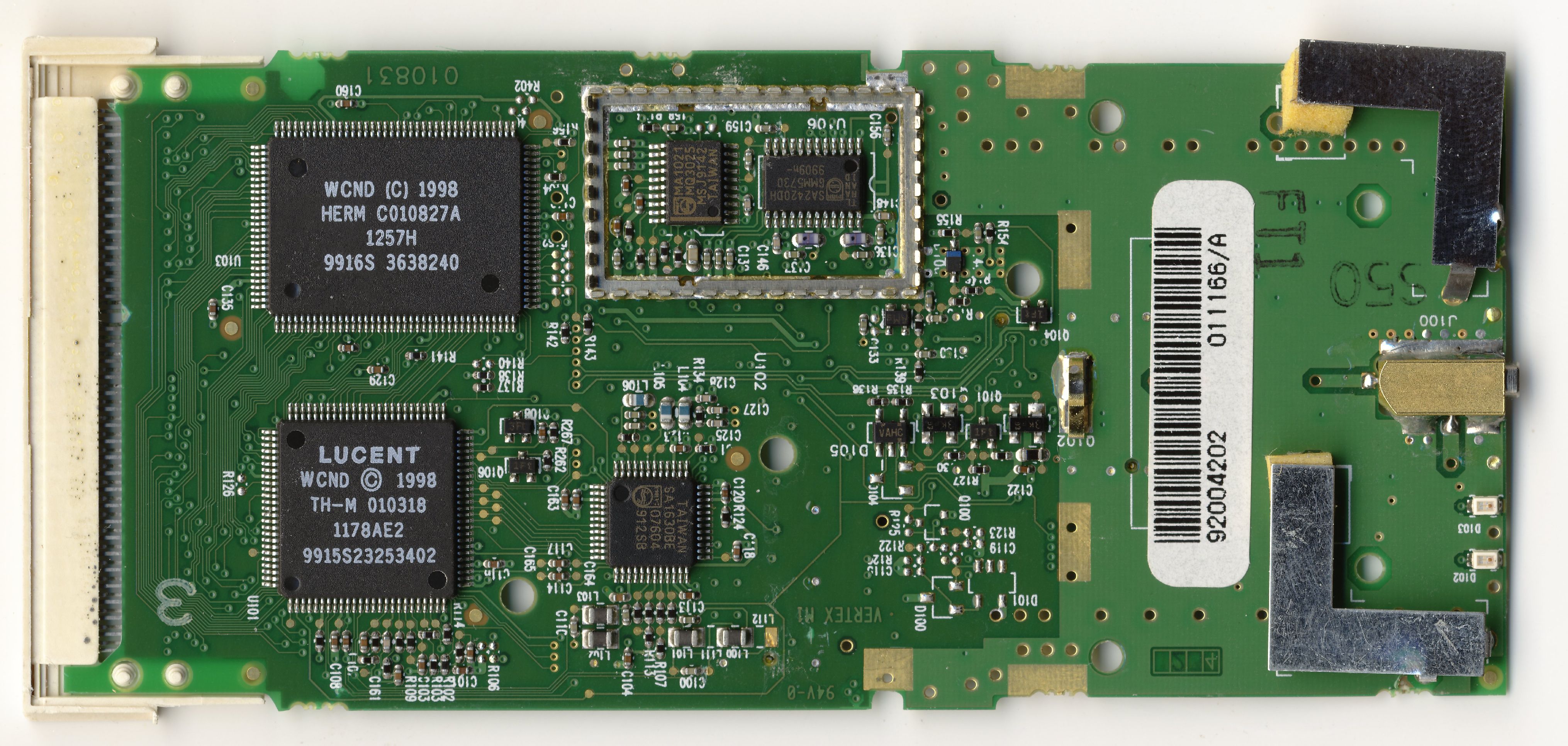

Lucent WaveLAN IEEE Wi-Fi Chip Set (1998) |

|

|

|

Nadie puede negar que navegar por la Web de forma inalámbrica mientras tomamos un café con leche es una gran cosa. Pero resulta que la creación de la tecnología inalámbrica que hizo posible este elemento básico de la modernidad implicó acalorados debates entre las empresas de tecnología más poderosas del mundo. Antes de que apareciera el Wi-Fi, una torre de Babel de estándares inalámbricos recorría el espectro; cada empresa tenía su propia tecnología. Fue necesario un ingeniero holandés llamado Vic Hayes, dotado con habilidades diplomáticas del nivel de la ONU, para que todas las empresas estuvieran juntas (e incluso en la misma sala). Como presidente del Grupo de Trabajo IEEE 802.11, Hayes consiguió que se definiera el estándar de red inalámbrica que se generalizaría en hogares, oficinas, escuelas, aeropuertos y, por supuesto, cafeterías. En 1996, el grupo lanzó la primera versión del estándar 802.11. Luego, Hayes lo llevó al departamento de ingeniería de la empresa donde trabajaba, Lucent Technologies, y sus colegas del mismo grupo de trabajo hicieron lo mismo en sus empresas. Por supuesto, redactar un estándar era una cosa e implementarlo en silicio en un producto rentable era otra. Lucent fue uno de los primeros en crear un chipset 802.11, que presentó en 1998 como WaveLAN IEEE, vendido como parte de routers y módems inalámbricos. El chipset se actualizó pronto para admitir la revisión 802.11b, que podría transmitir datos a una velocidad sin precedentes de 11 megabits por segundo y popularizaría la tecnología Wi-Fi. Lucent no se beneficiaría mucho de la línea WaveLAN IEEE: escindió su división de semiconductores como Agere Systems en 2000 y renombró el chipset como Orinoco, que luego fue adquirido por Proxim. Para entonces, el Wi-Fi había cobrado vida propia y ahora los chips Wi-Fi de Atheros, Broadcom, Cisco, Intel, Marvell y otros forman parte de todos los ordenadores que se venden en la actualidad. ¿Te apetece otro café con leche? |

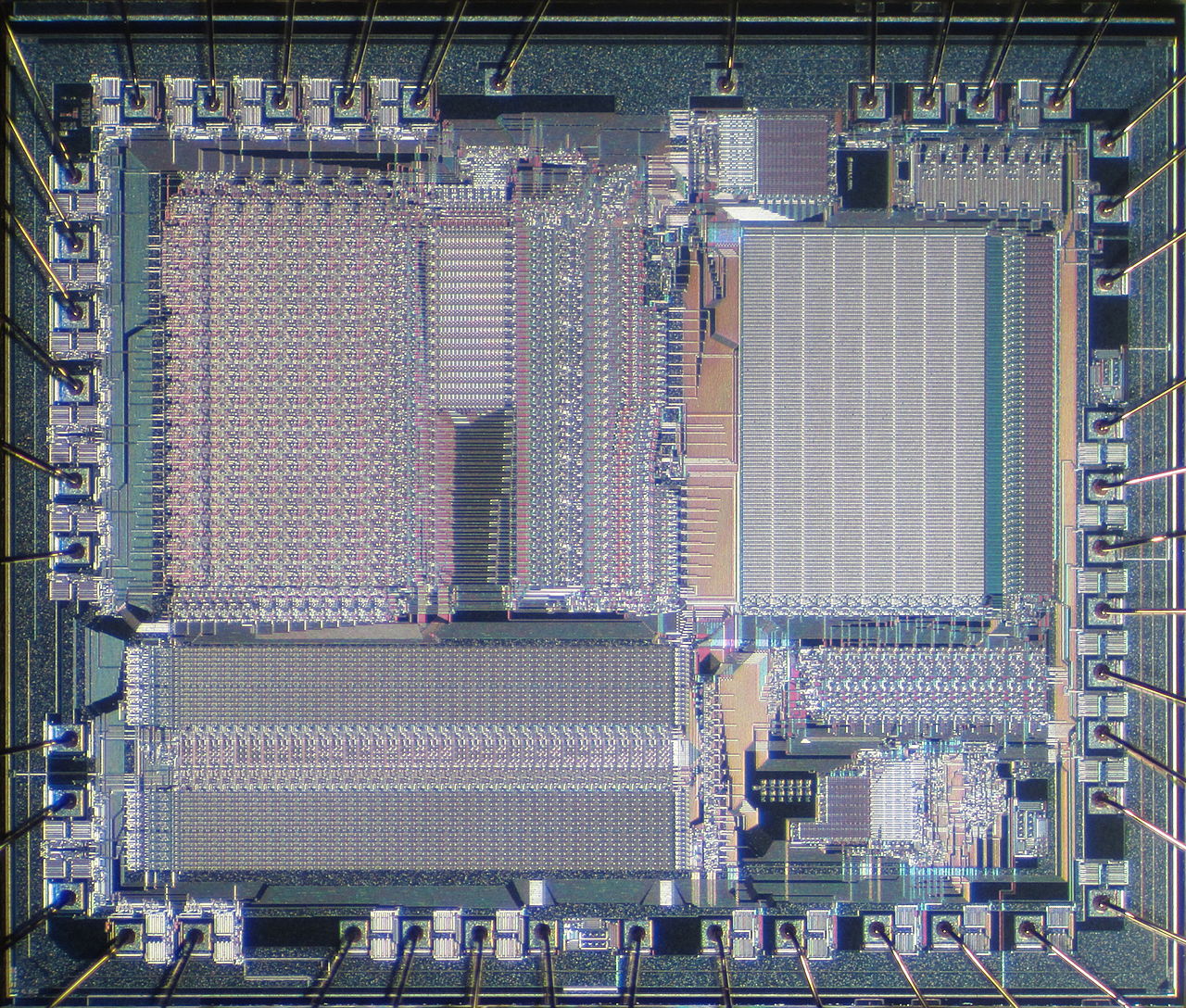

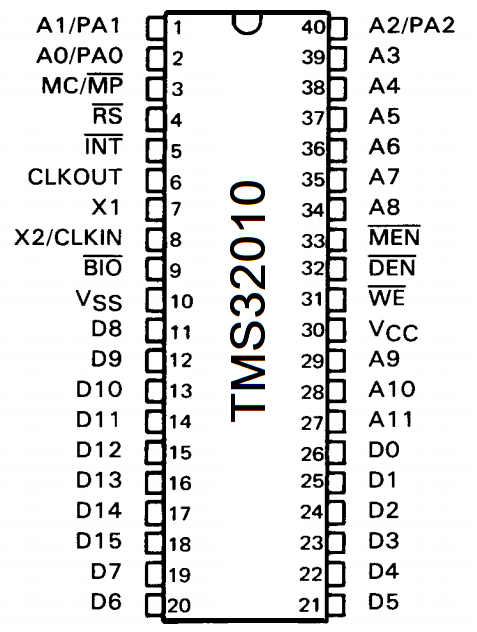

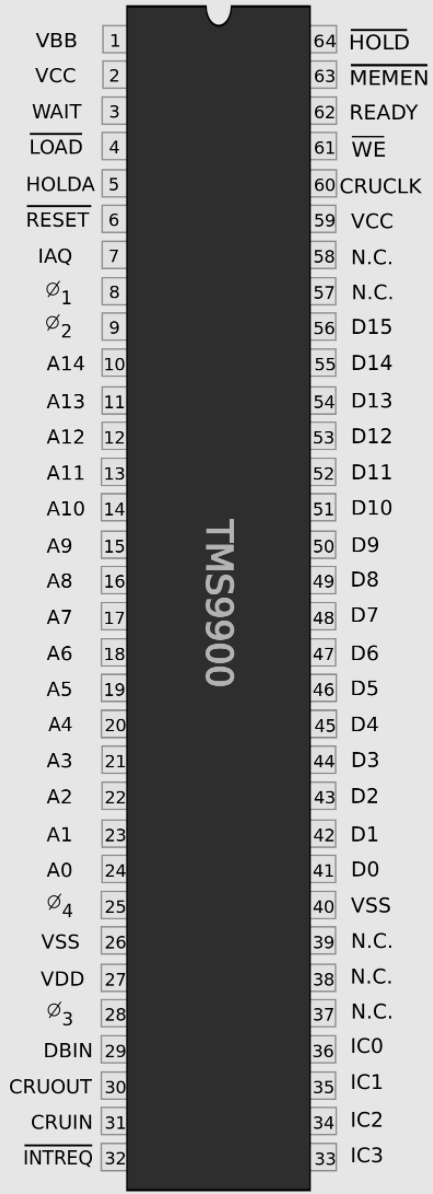

Microprocesador Texas Instruments TMS9900 (1976) |

|

|

Categoría: Procesadores |

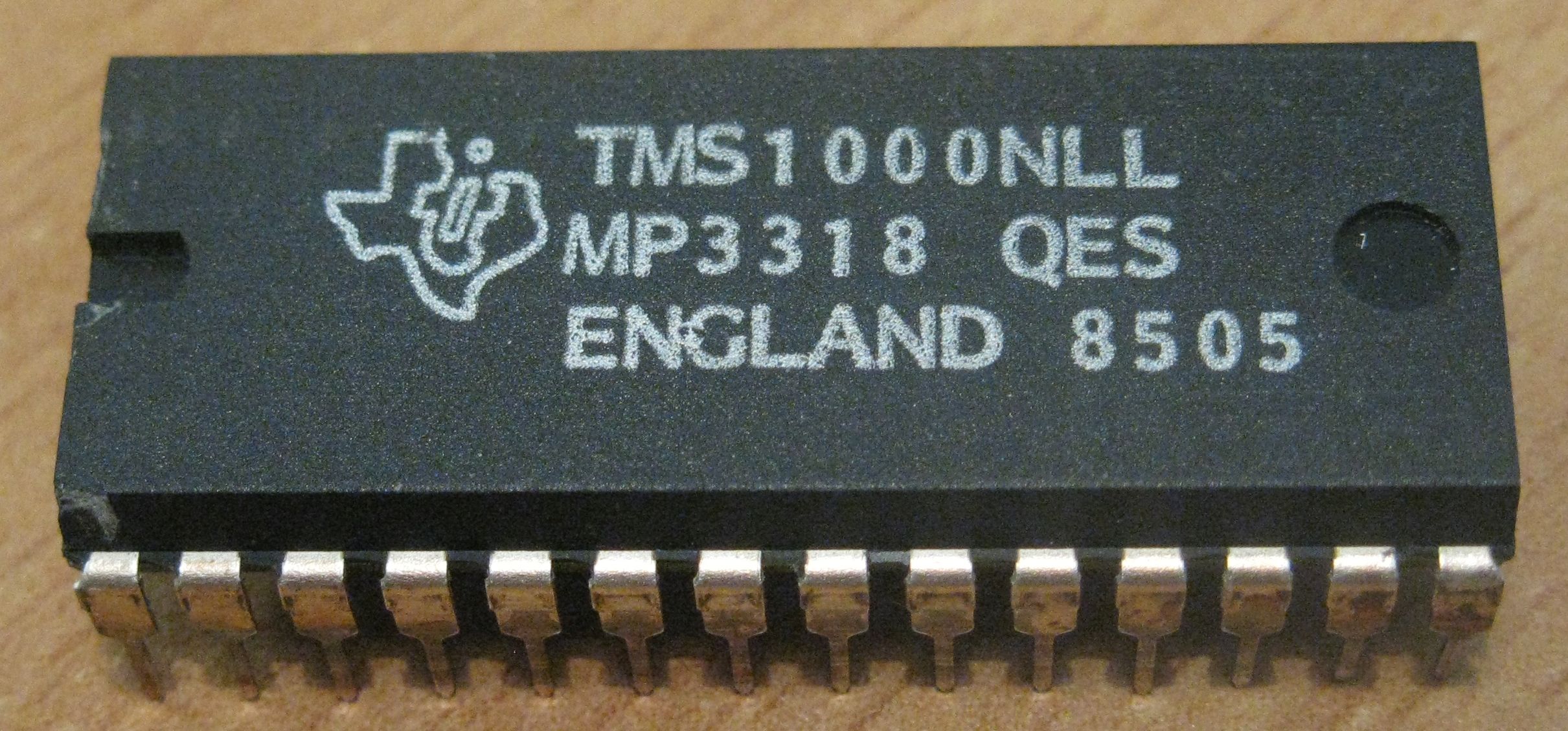

Tan ambicioso como fallido, este chip fue la CPU del primer ordenador doméstico de 16 bits. A principios de los 70, Texas Instruments sabía que el reciente mercado de los microprocesadores, inaugurado en 1971 por el Intel 4004, iba a demandar chips mas potentes que las CPUs de 8 bits que inundaban el mercado. Y Texas Intruments tenía los recursos de I+D y la capacidad de marketing necesarios para adelantarse a la competencia. Asi, en 1976 se lanza el TMS9900, el tercer microprocesador de 16 bits de la historia en un único chip. Fue diseñado como una versión de un único chip del microordenador TI 990. Disponía de un buen manejo de interrupciones y un excelente conjunto de instrucciones. Pero el TMS9900 perdería su oportunidad de llevarse el premio gordo: ser la CPU elegida para el IBM Personal Computer. El mayor problema era que su arquitectura, a pesar de ser la misma que la de la familia de miniordenadores de Texas Instruments, solamente disponía de 16 bits para direccionamiento de memoria, lo mismo que tenían los microprocesadores de 8 bits de la época, como el MOS 6502 y el Ziloj Z80. El TMS9900 se utilizó en los ordenadores domésticos Texas Instruments TI-99/4 (1979) y TI-99/4A (1981), dándoles el honor de ser los primeros ordenadores domésticos de 16 bits. Aunque su CPU era muy rápida, para reducir los costos de producción se utilizó en estos ordenadores una memoria RAM de 8 bits, lo que disminuía de forma notable su rendimiento. Aunque el TI-99/4A ganó un cierto mercado fue a costa de perder rentabilidad. Una serie de variantes sucecieron al TMS9900, como el TMS9995, que encontraron su uso en sistemas empotrados y en ordenadores personales como el Tomy Tutor de Texas Instruments, pero esta línea nunca se recuperó de sus tropiezos iniciales: cuando entró en el mercado de PCs, la propia Texas Instruments acabó usando microprocesadores Intel. Aunque en una comparación con un microprocesador Intel 8086 se puede comprobar que el TMS9900 usa programas más pequeños y veloces. Rara vez un chip se acercó tanto a la verdadera grandeza, sólo para ver cómo se le escapaba de las manos. |

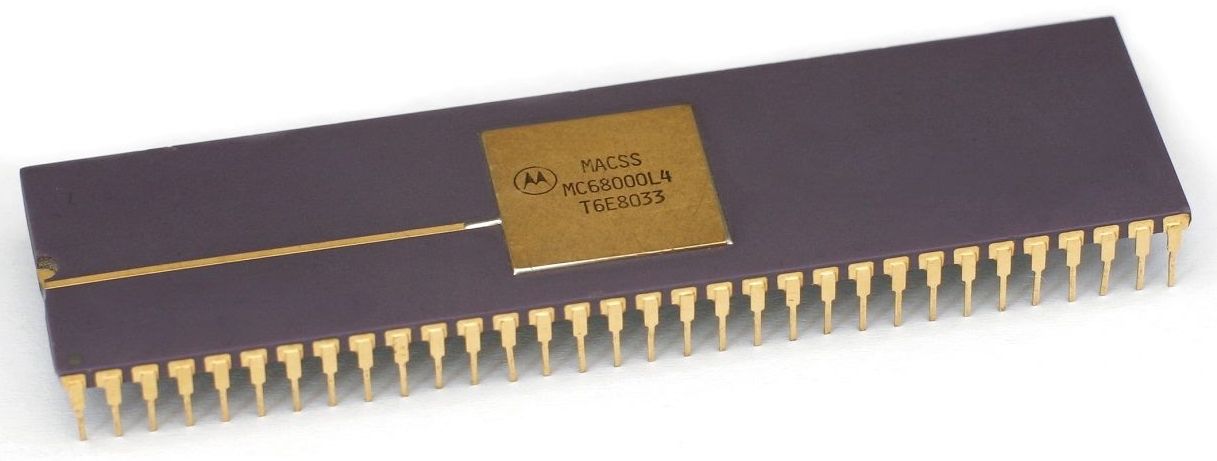

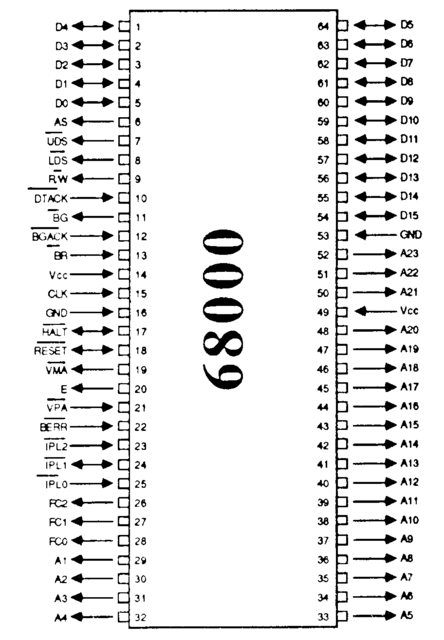

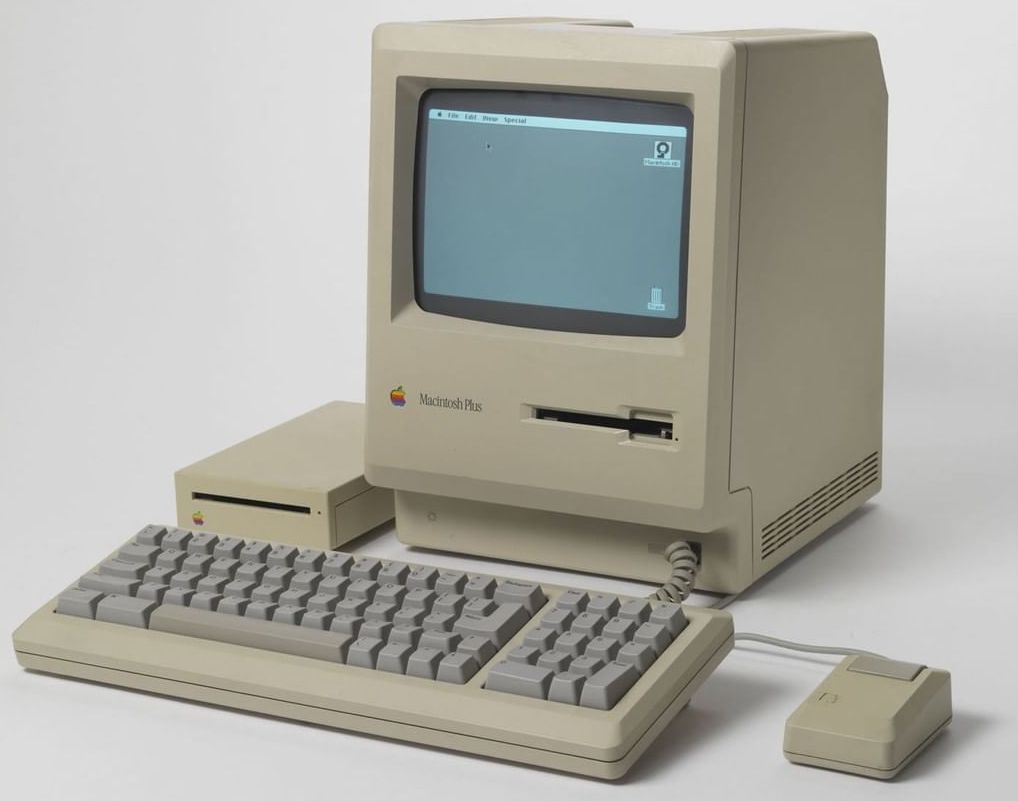

Microprocesador Motorola MC68000 (1979) |

|

|

Categoría: Procesadores |

El procesador que usaba el Macintosh original, así como los queridos ordenadores Amiga. Motorola llegó tarde a la fiesta del microprocesador de 16 bits, por lo que decidió hacerlo con estilo. El MC68000 híbrido de 16/32 bits integraba 68,000 transistores, más del doble que el Intel 8086. Internamente, era un procesador de 32 bits, pero una dirección de 32 bits y/o un bus de datos lo hubieran hecho prohibitivamente. caro, por lo que el 68000 utilizó direcciones de 24 bits y líneas de datos de 16 bits. El 68000 parece haber sido el último gran procesador diseñado con lápiz y papel. "Distribuí copias de tamaño reducido de diagramas de flujo, recursos de unidades de ejecución, decodificadores, y lógica de control a otros miembros del proyecto", dice Nick Tredennick, quien diseñó la lógica del 68000. Las copias eran pequeñas y difíciles de leer, y sus colegas con los ojos llorosos finalmente encontraron una manera de manifestarselo de forma bien clara. “Un día entré en mi oficina y encontré en mi escritorio una copia del tamaño de una tarjeta de crédito de los diagramas de flujo”, recuerda Tredennick. El 68000 se incluyó en todas los primeros ordenadores Macintosh, así como en los Amiga y el Atari ST. El mayor número de unidades vendidas son para aplicaciones integradas en impresoras láser, juegos arcade, y controladores industriales. Pero el 68000 también fue objeto de uno de los cuasi fallos más grandes de la historia, justo cuando Pete Best perdió su puesto como baterista de los Beatles. IBM quería usar el 68000 en su línea de PCs, pero la compañía eligió el 8088 de Intel porque, entre otras cosas, el 68000 todavía era relativamente escaso. Como reflexionó un observador más tarde, si Motorola hubiera prevalecido, el exitoso duopolio Windows-Intel conocido, como Wintel, podría haber sido Winola. |

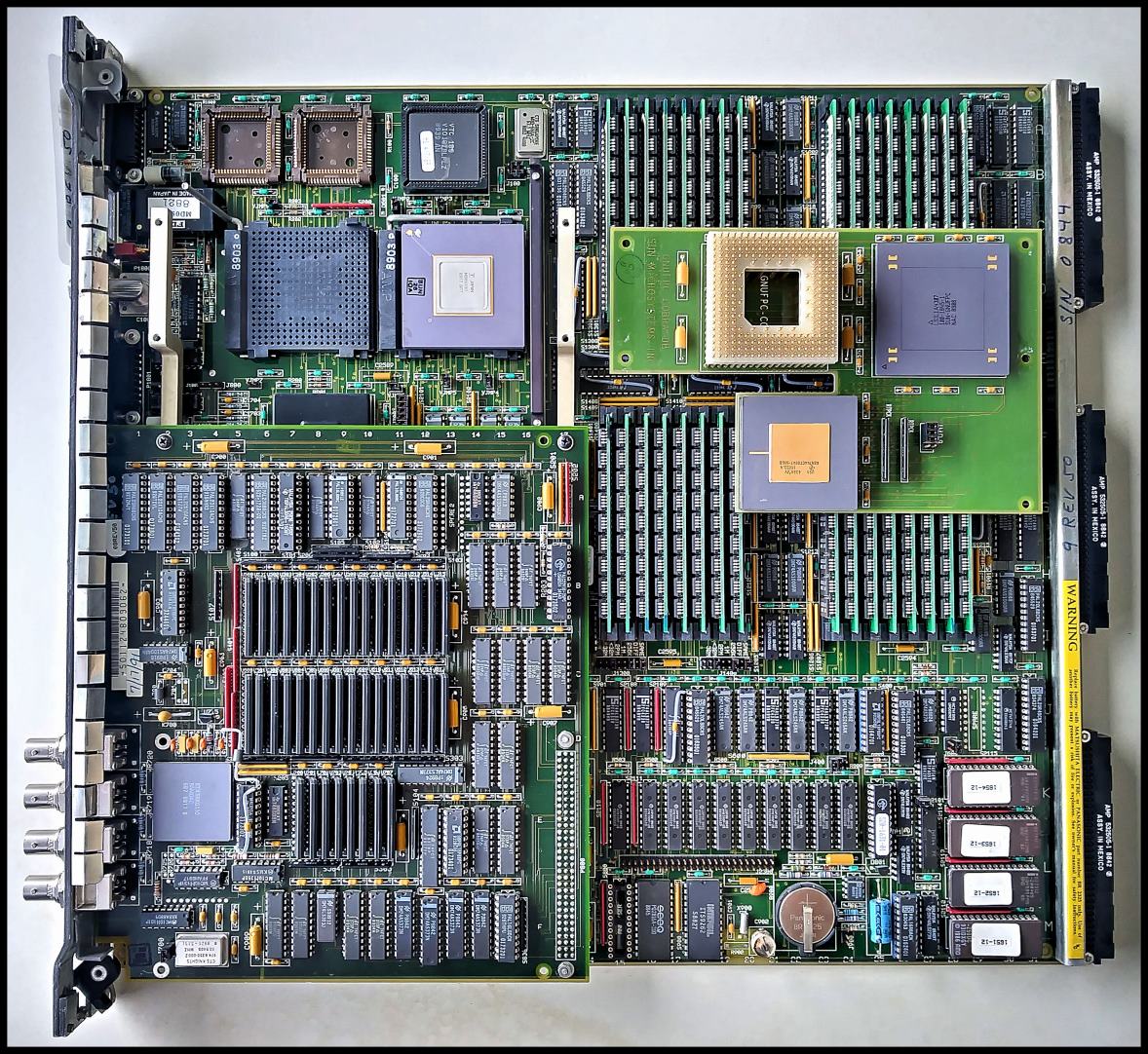

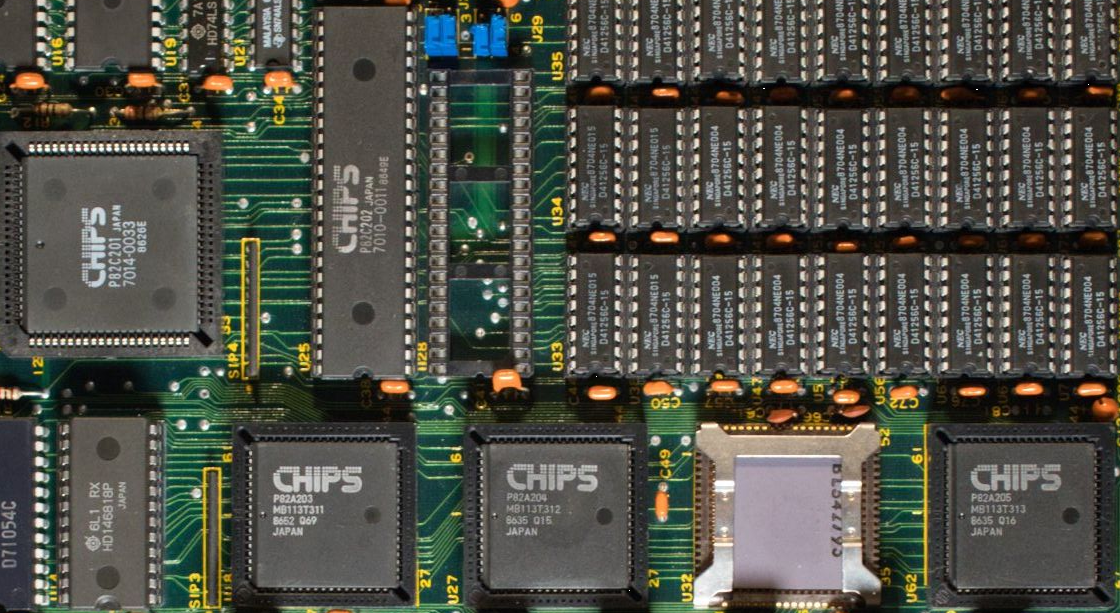

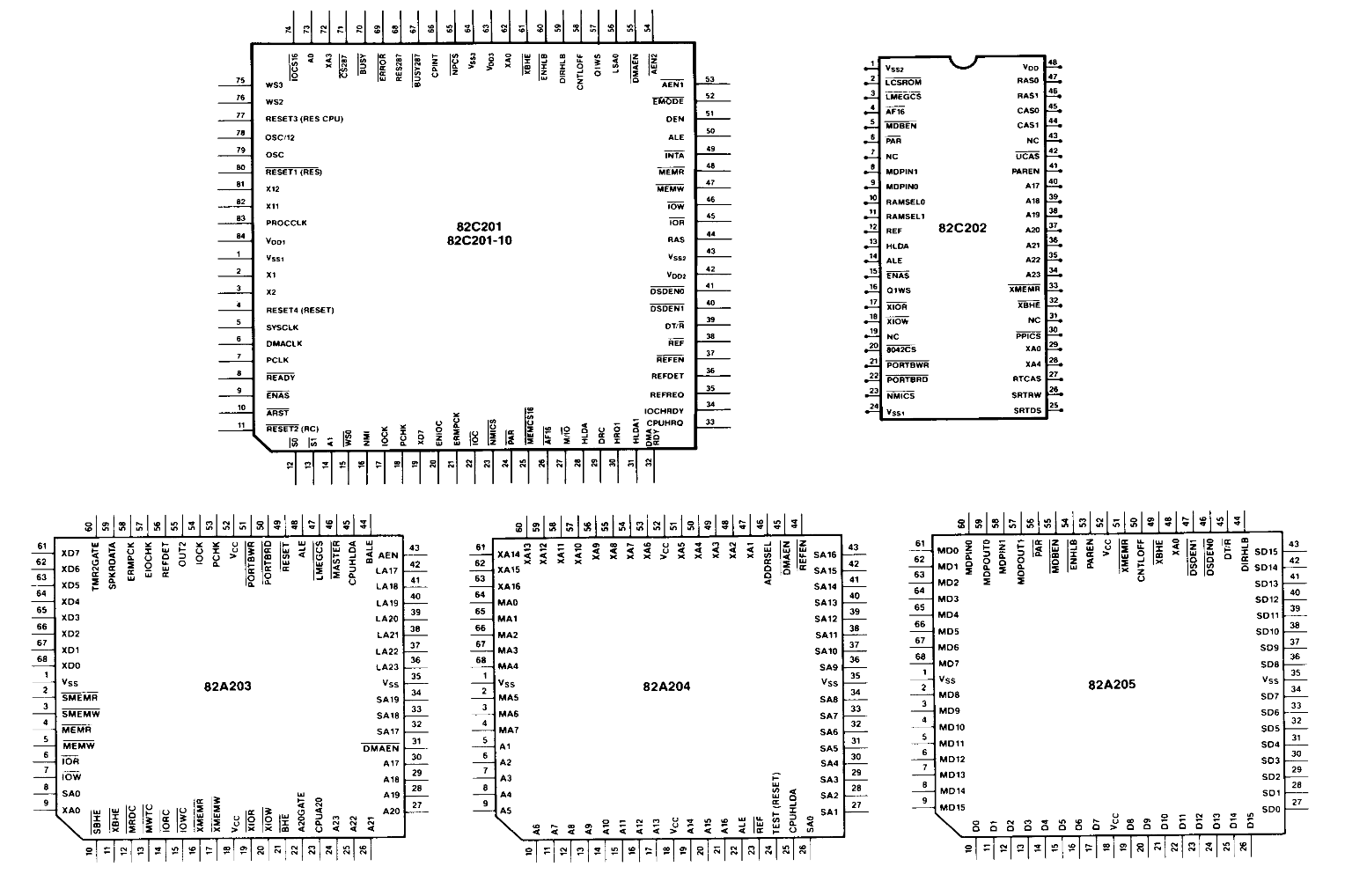

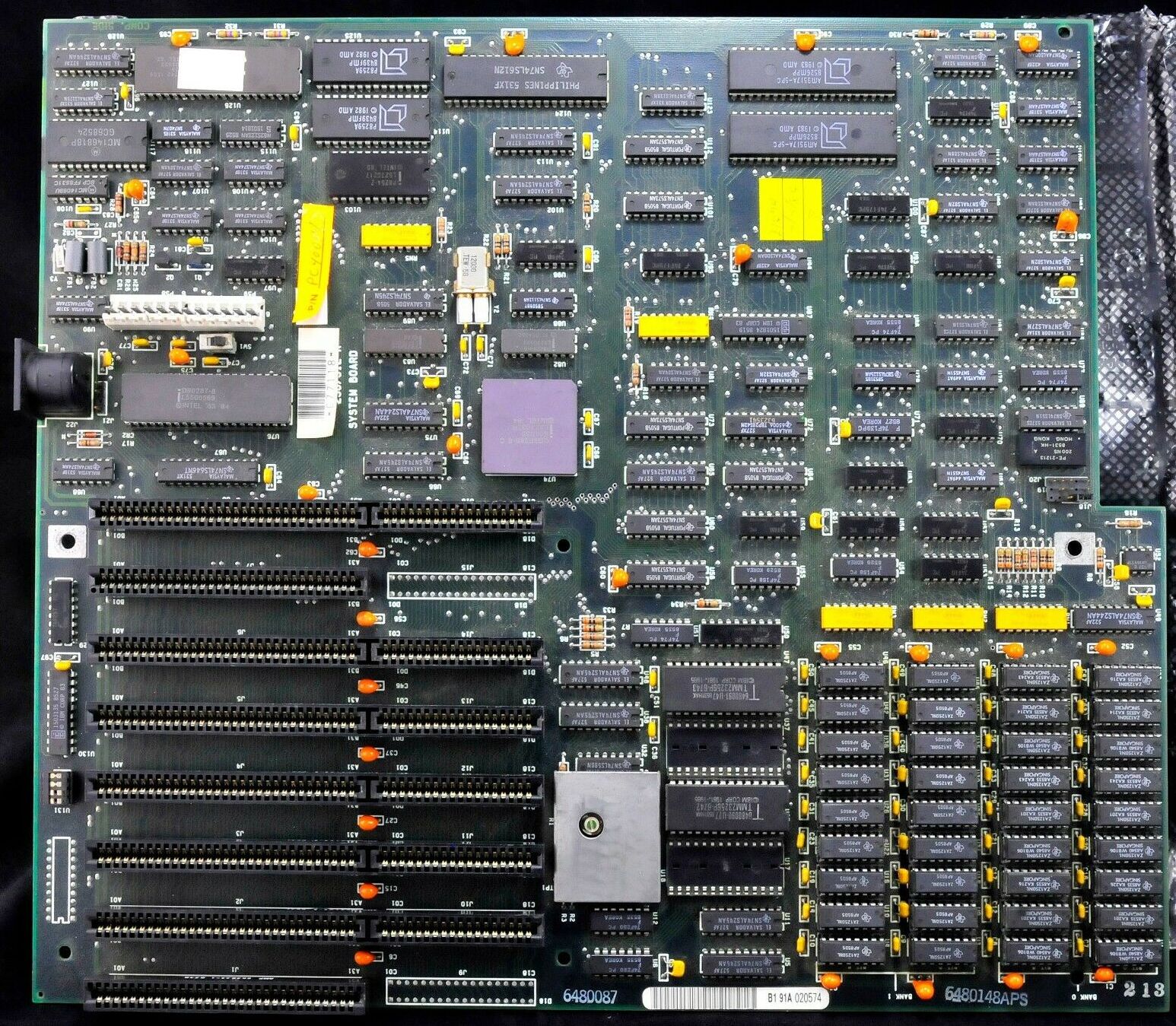

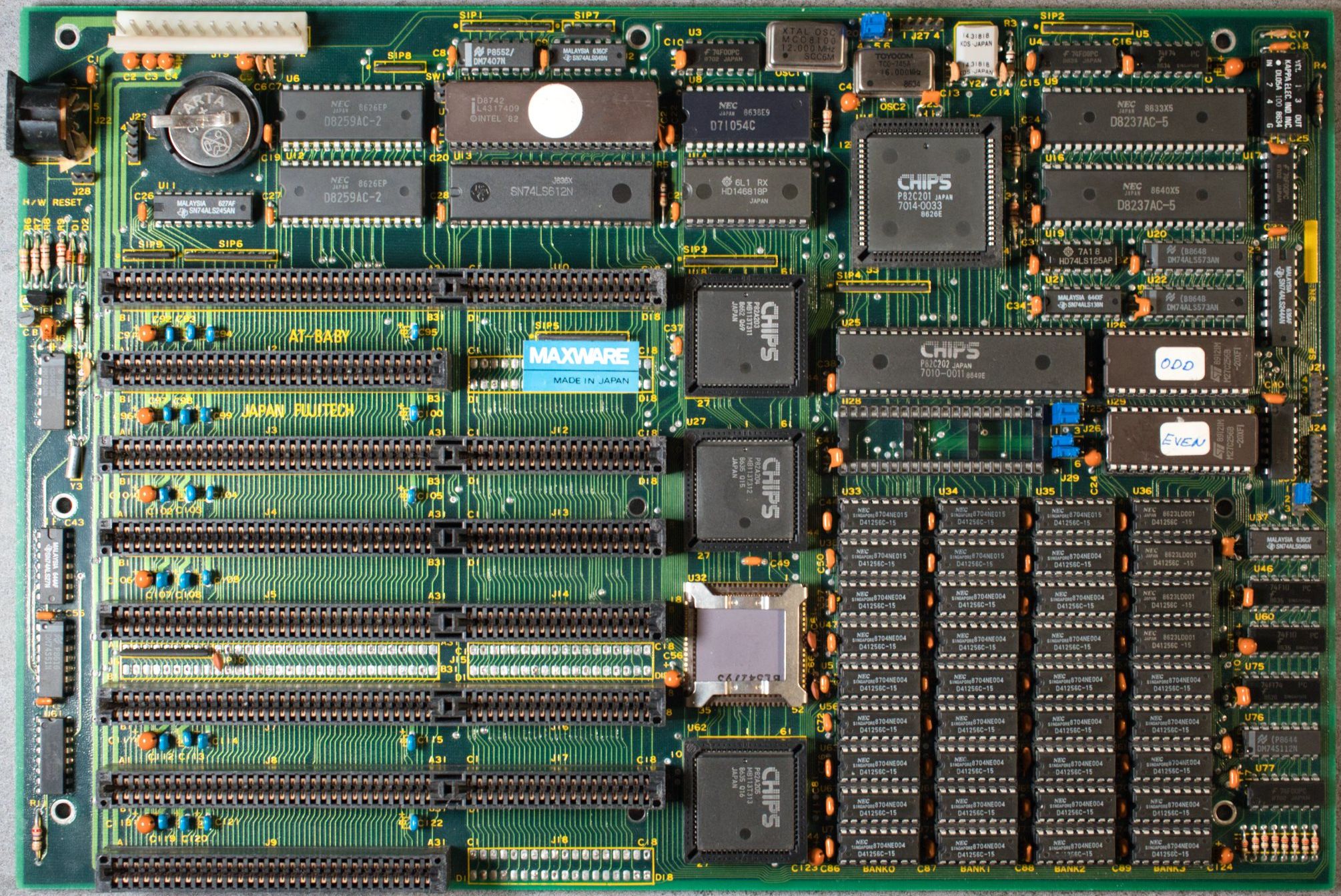

Chips & Technologies CS8220 PC/AT Chip Set (1985) |

|

|

|

En 1984, cuando IBM presentó su línea de PC/AT basada en el Intel 80286, la compañía ya estaba emergiendo como el claro ganador en ordenadores de sobremesa y tenía la intención de mantener su dominio. Pero los planes de Big Blue fueron frustrados por una pequeña empresa llamada Chips & Technologies, en San José, California. C&T desarrolló cinco chips que duplicaban la funcionalidad de la placa base del AT, que usaba unos 100 chips; se llamó el chipset CS8220. Para asegurarse de que el conjunto de chips fuera compatible con el IBM PC, los ingenieros de C&T pensaron que solo había una cosa por hacer. “Tuvimos la tarea estresante pero ciertamente entretenida de jugar durante semanas”, dice Ravi Bhatnagar, el diseñador líder de chipsets y ahora vicepresidente de Altierre Corp., en San José, California. Los chips C&T permitieron a fabricantes como Acer de Taiwán fabricar PCs más baratos, con placas base mucho más pequeñas y lanzar la invasión de los clones del IBM PC. Intel compró C&T en 1997. El sucesor del chipset CS8220 sería el chipset NEAT (""New Enhanced AT"), llamado CS8206, compuesto de sólo 4 chips, que a su vez evolucionaría al chipset SCAT (Single CHip AT) con solo un chip, el 82C836. |

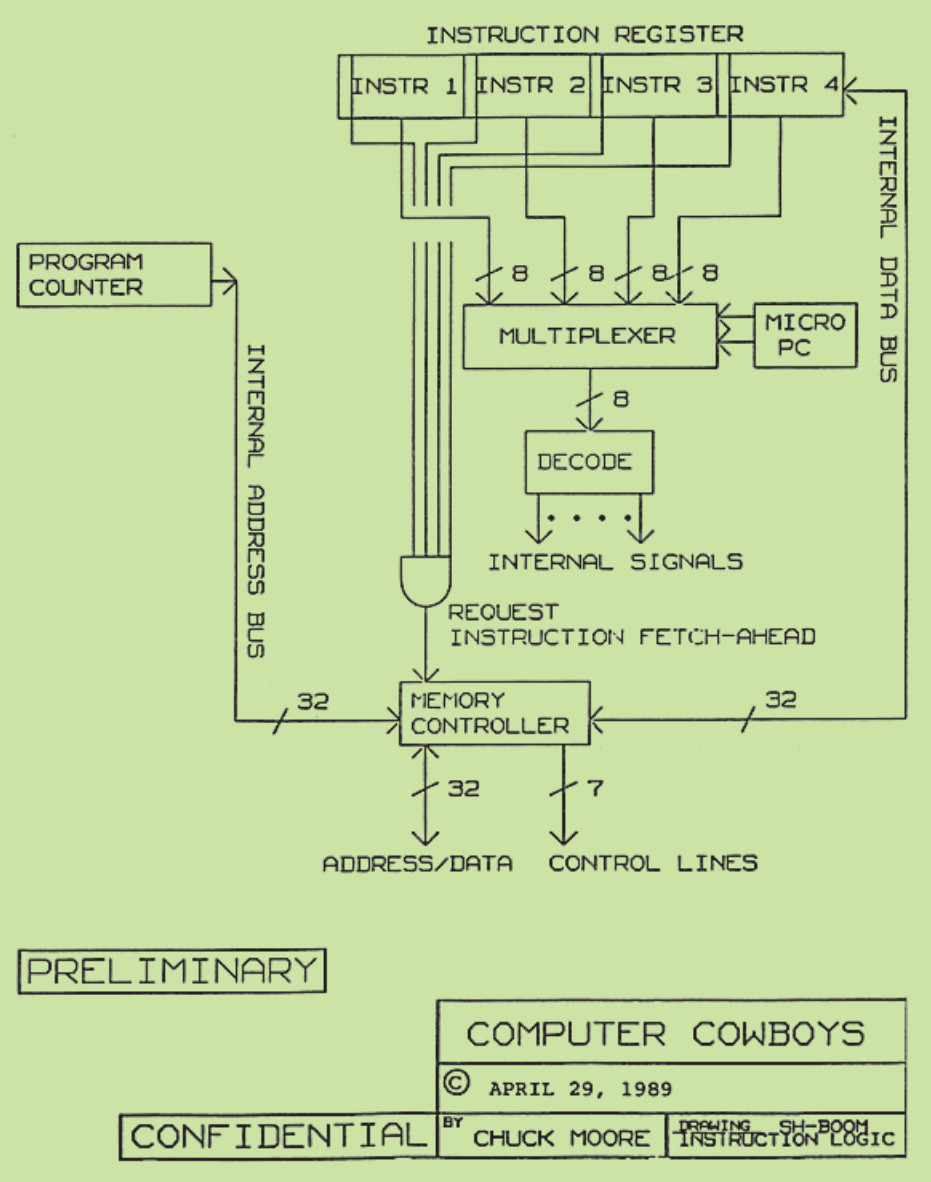

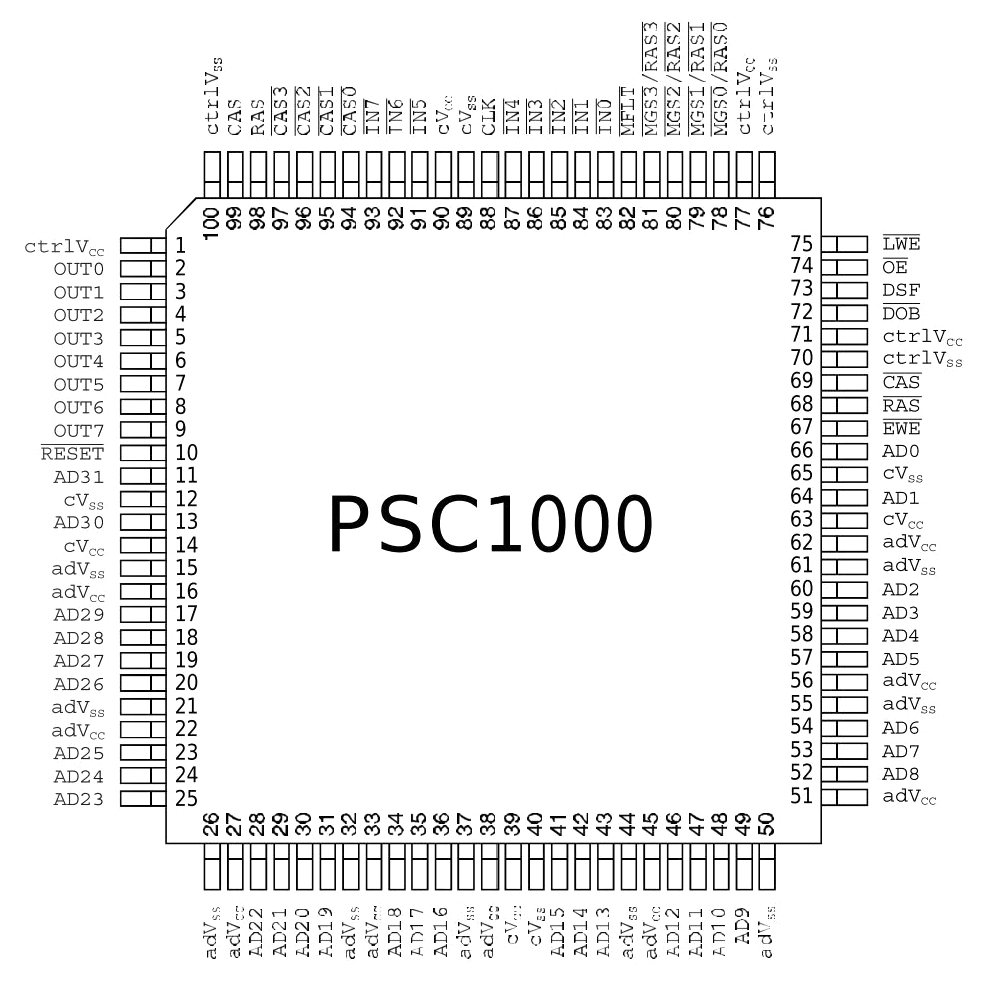

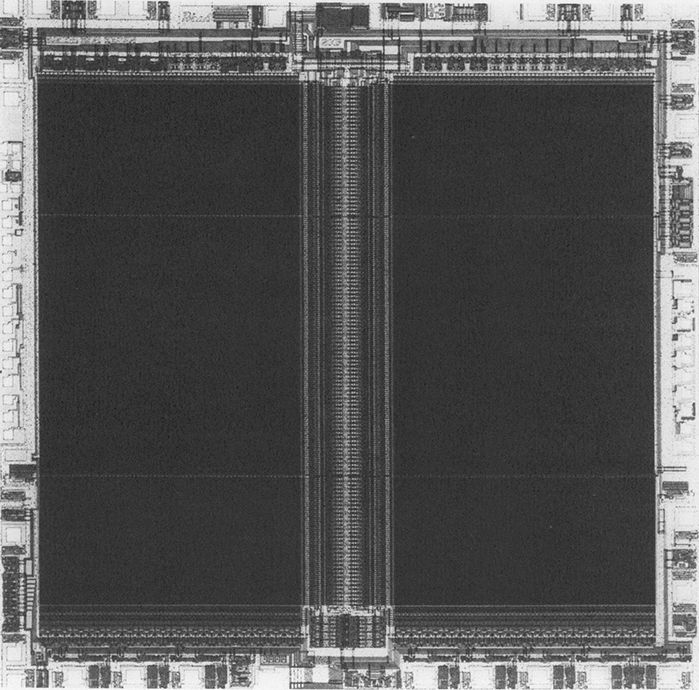

Arquitectura de procesador Computer Cowboys Sh-Boom (1988) |

|

|

|

Nunca habrás oído hablar de él, pero la arquitectura de alta velocidad de este procesador se ha aplicado en todos los ordenadores modernos. Dos diseñadores de chips entran en un bar. Son Russell H. Fish III y Chuck H. Moore (el creador del lenguaje informático Forth), y el bar se llama Sh-Boom. No, este no es el comienzo de un chiste. En realidad, es parte de una historia tecnológica llena de discordia y demandas. Muchas demandas. Todo comenzó en 1988 cuando Fish y Moore crearon un extraño procesador llamado Sh-Boom. El chip estaba tan optimizado que podía funcionar más rápido que el reloj de la placa base que coordinaba el resto del ordenador. Entonces, los dos diseñadores encontraron una manera de hacer que el procesador ejecutara su propio reloj interno ultrarrápido mientras se mantenía sincronizado con el resto del ordenador. Sh-Boom nunca fue un éxito comercial y, después de patentar sus innovadoras ideas, Moore y Fish se dedicaron a otros menesteres. Fish vendió sus derechos de patente a Patriot Scientific en 1994. Patriot renombró y modificó el Sh-Boom como PSC1000 y lo enfocó al mercado de Java. Los bytecodes de Java podrían traducirse para ejecutarse de manera similar a Forth en el PSC1000 y a 100MHz, y eso era bastante rápido. A principios de la década de 2000, Patriot volvió a cambiar el nombre del ShBoom y llamó al diseño IGNITE. Sin embargo, siguió siendo un asunto menor para Patriot hasta que sus ejecutivos tuvieron una revelación: en los años transcurridos desde la invención de Sh-Boom, la velocidad de los procesadores había superado con creces la de las placas base, por lo que prácticamente todos los fabricantes de ordenadores y productos electrónicos de consumo terminaron usando un enfoque como el que Fish y Moore habían patentado. ¡Clin-clin! la oportunidad de ganar pasta a espuertas estaba servida. En 2003-04, Patriot inició una serie de demandas contra empresas estadounidenses y japonesas. Si los chips de estas empresas dependen de las ideas de Sh-Boom es motivo de controversia. Pero desde 2006, Patriot y Moore han cosechado más de 125 millones de dólares en derechos de licencia de Intel, AMD, Sony, Olympus y otros. En cuanto al nombre Sh-Boom, Moore, ahora en GreenArrays, en Cupertino, California, nos confesó: “Supuestamente deriva del nombre de un bar donde Fish y yo bebimos bourbon y garabateamos en servilletas. No es cierto del todo, pero me gustó el nombre que él sugirió". |

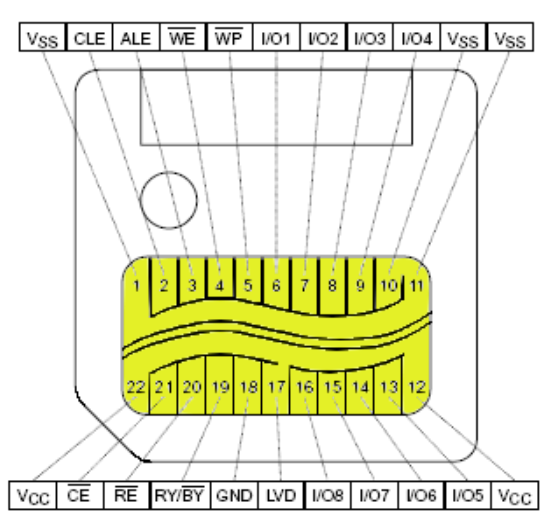

Memoria Toshiba NAND Flash (1989) |

|

|

|

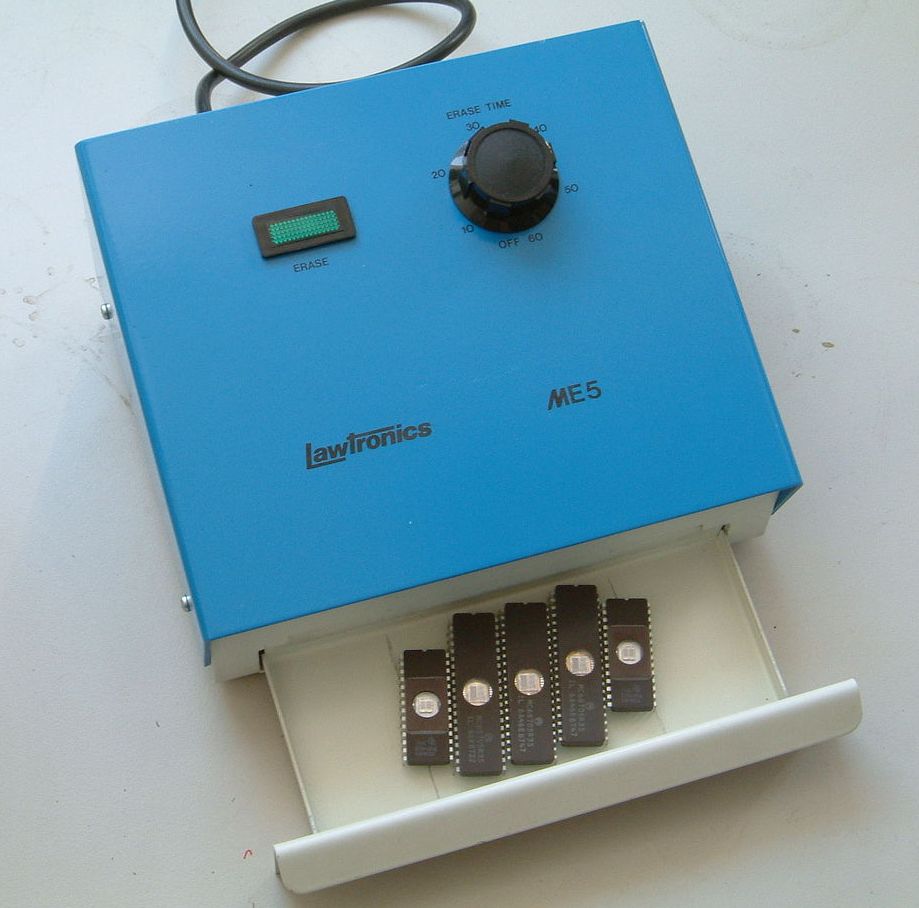

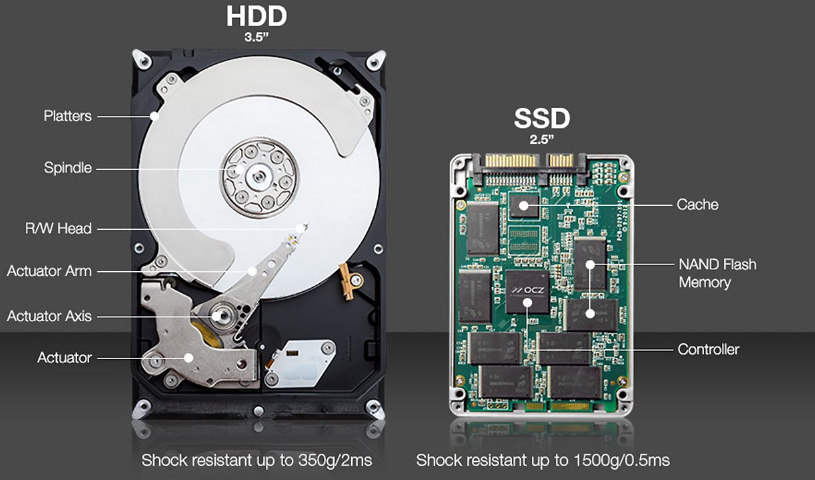

Durante mucho, mucho tiempo todo el almacenamiento masivo de datos era magnético. Pero entonces llegaron las memorias flash. La historia de la invención de la memoria flash comenzó cuando el gerente de una fábrica de Toshiba llamado Fujio Masuoka decidió que reinventaría la memoria de semiconductores. Llegaremos a eso en un minuto. Primero, conviene un poco de historia. Antes de que apareciera la memoria flash, la única forma de almacenar grandes cantidades de datos era usar cintas, disquetes, y discos duros magnéticos. Muchas empresas intentaban crear alternativas de estado sólido, pero las opciones, como las EPROM (o memoria de sólo lectura programable y borrable, que requería luz ultravioleta para borrar los datos) y las EEPROM (la E adicional significa "eléctricamente", no necesitando UV) no podían almacenar grandes cantidades de datos de forma económica. Masuoka-san entra a trabajar en Toshiba. En 1980, reclutó a cuatro ingenieros para un proyecto semisecreto destinado a diseñar un chip de memoria que pudiera almacenar gran cantidad de datos y además fuera asequible. Su estrategia fue simple. “Sabíamos que el costo del chip seguiría bajando mientras los transistores se redujeran de tamaño”, dice Masuoka, ahora director de tecnología de Unisantis Electronics, en Tokio. El equipo de Masuoka ideó una variación de EEPROM que tenía celdas de memoria de un único transistor, cuando hasta ese momento, las EEPROM convencionales necesitaban dos transistores por celda. Fue una diferencia aparentemente pequeña pero que tuvo un gran impacto en el coste. En busca de un nombre atractivo, optaron por "flash" debido a la capacidad de borrado ultrarrápido del chip. Ahora bien, si está pensando que Toshiba lanzó rápidamente el invento a producción para observar cómo el dinero les caería como una cascada, es que no sabe mucho sobre cómo las grandes corporaciones suelen explotar las innovaciones internas. Al final resultó que, los jefes de Masuoka en Toshiba le dijeron que, bueno, que se olvidara de aquella idea. Por supuesto, él no lo hizo. En 1984 presentó un artículo sobre el diseño de su memoria en el IEEE International Electron Devices Meeting, en San Francisco. Intel Corporation vio entonces el enorme potencial de la invención y lanzó en 1988 el primer chip flash comercial, basado en puertas NOR (de tiempos largos de escritura y borrado), un chip de 256 kilobits que fue usado en vehículos, ordenadores y otros artículos destinados al gran público, creando un bonito nuevo negocio para Intel. El éxito de Intel finalmente llevó a Toshiba a dar luz verde al invento de Masuoka. Su chip flash se basaba en la tecnología NAND, que ofrecía mayores densidades de almacenamiento, pero resultó más complicado de fabricar. El éxito llegó en 1989, cuando el primer flash NAND de Toshiba llegó al mercado. Y tal como había predicho Masuoka, los precios siguieron cayendo. El primer medio extraíble basado en memoria flash de puertas NAND (con diez veces la resistencia de las flash de puertas NOR) fue SmartMedia, comercializada en 1995. La fotografía digital dio un gran impulso a la memoria flash desde finales de la década de 1990, y Toshiba se convirtió en uno de los mayores actores en un mercado multimillonario. Sin embargo, al mismo tiempo, la relación de Masuoka con otros ejecutivos se agrió y abandonó Toshiba. (Más tarde les demandó por una parte de las grandes ganancias y ganó un pago en efectivo). Hoy en día, las memorias flash de puertas NAND son una pieza clave de todos los dispositivos, smartphones, cámaras, reproductores de música y, por supuesto, los pendrives USB, y los discos de estado sólido (SSD) ya han comenzando a reemplazar incluso a los discos duros mecánicos como medio de almacenamiento preferido en ordenadores portátiles y de sobremesa. |

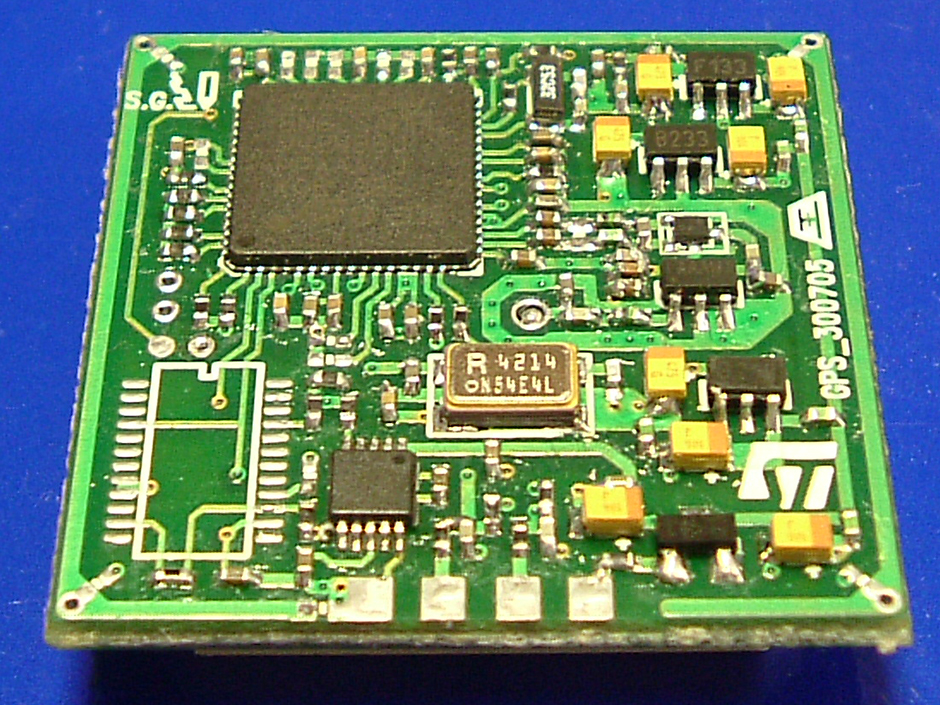

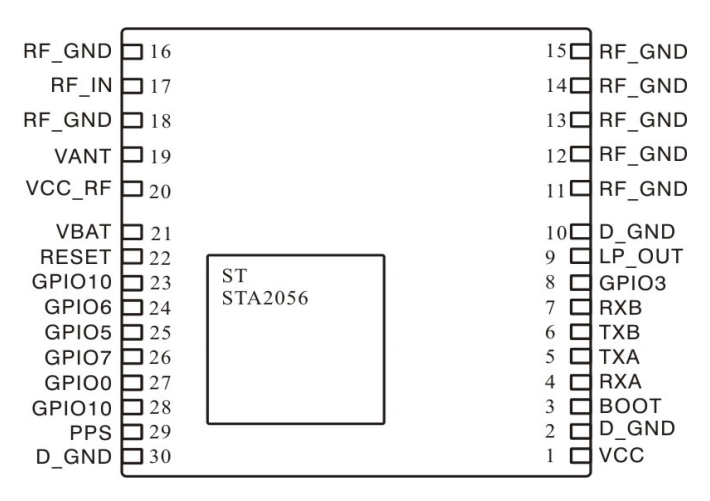

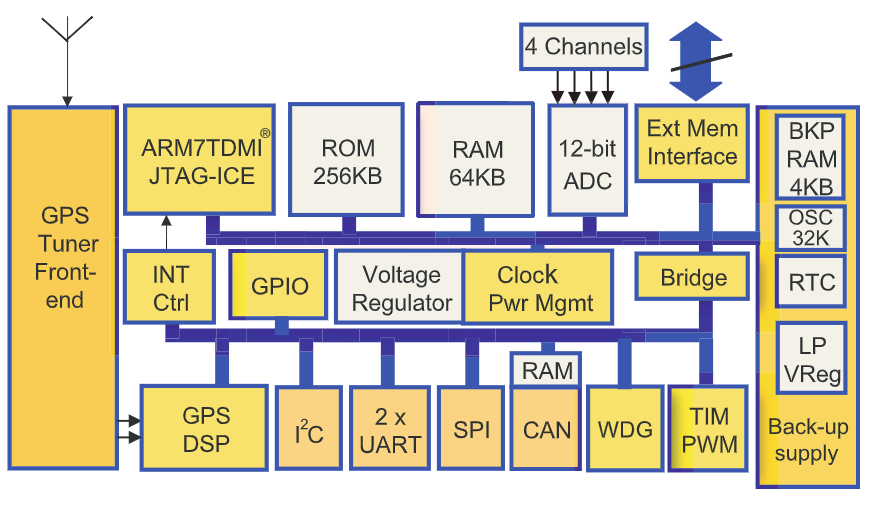

Receptor GPS STMicroelectronics STA2056 (2004) |

|

|

|

Barato y pequeño, este receptor GPS disparó el mercado de dispositivos móviles que ahora podían conocer su posición geográfica, abriendo paso a numerosos servicios dependientes de la localización. Un truco de diseño consagrado en el mundo de la fabricación de chips es la idea de matar dos chips con uno. En 2004, STMicroelectronics lo hizo con los receptores GPS. Ya existía un chip con un sistema que captaba las señales de navegación que se envían desde los satélites GPS en órbita. Y también existía otro chip que contenía un microprocesador, algo de memoria y un correlacionador de señales (el GPS determina la ubicación de cada receptor comparando las señales de varios satélites). Pues bien, en el STA2056 estos dos chips se fusionaron en uno sólo. Aunque ya existían receptores GPS portátiles, el STA2056 estableció un nuevo estándar de tamaño y consumo. Y por $8 el chip era bastante barato, disminuyendo por tanto el precio de los receptores GPS y ayudando a que sus ventas se dispararan. Fiat ha utilizado el chip en varios modelos de Alfa Romeo y el proveedor de GPS Becker lo puso en sus dispositivos receptores. El STA2056 también ayudó a impulsar la idea del receptor GPS como una funcionalidad que podría integrarse en cualquier dispositivo y no ser sólo un producto independiente con sólo esa funcionalidad. Hoy en día, casi todos los teléfonos, y bastantes relojes, tienen un chip GPS, que generalmente se usa junto con otras técnicas como el mapeo de balizas Wi-Fi para permitir la navegación incluso cuando no hay un satélite a la vista. Y, por supuesto, el truco de dos chips en uno sigue siendo uno de los favoritos de los fabricantes de chips de todo el mundo. |

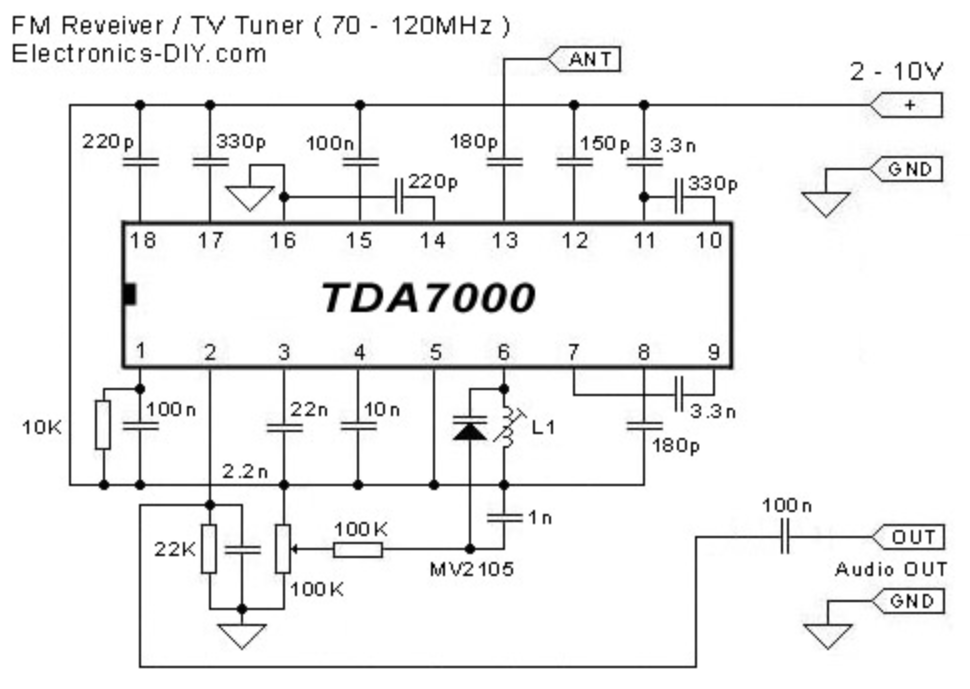

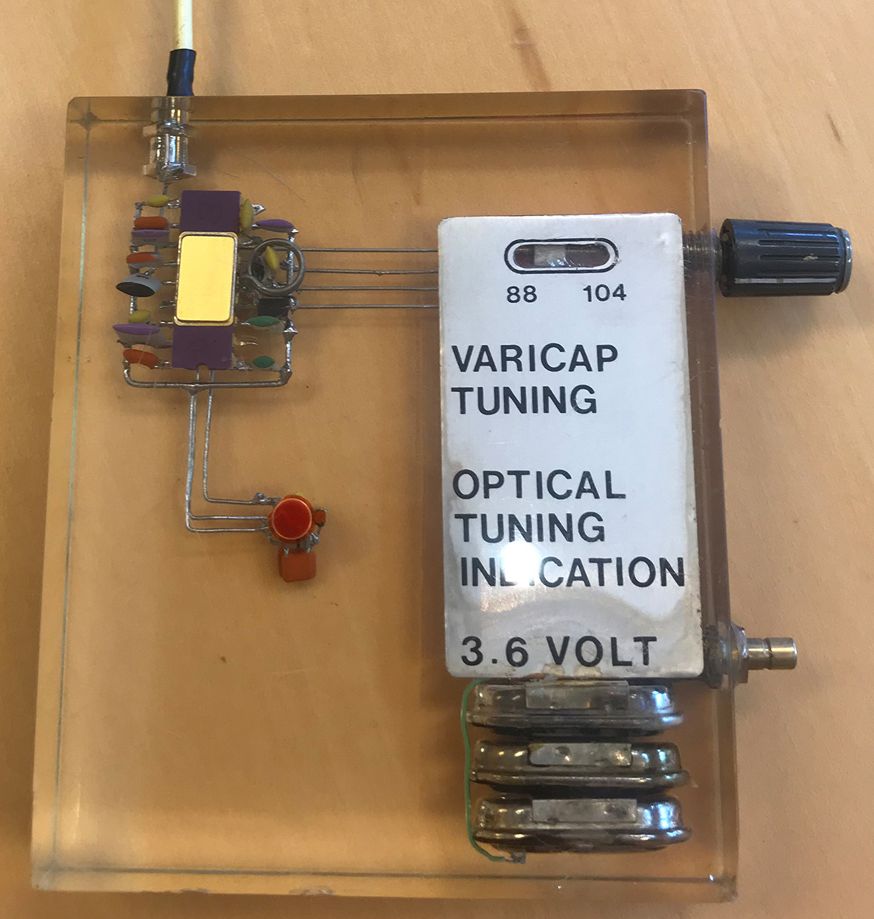

Receptor FM Philips TDA7000 (1977) |

|

|

|

Este chip permitió incluir una radio en innumerables productos de consumo. A finales de la década de 1970, la construcción de las funciones de radio convencionales era costosa y requería mucho tiempo. Los fabricantes generalmente tenían que hacer de 10 a 14 ajustes de circuito, conocidos como alineaciones, para asegurarse que la recepción fuera buena y que la frecuencia mostrada en la escala de sintonización de la radio fuera la correcta. Lo que cambió todo esto fue la llegada del Philips TDA7000, un chip que hizo posible una radio FM barata, fácil, y ultrapequeña. Trabajando en el laboratorio de investigación y desarrollo de Philips en los Países Bajos a mediados de la década de 1970, los ingenieros Dieter Kasperkovitz y Harm van Rumpt habían logrado instalar un receptor FM mono completo, desde la entrada de la antena hasta la salida de la señal de audio, en un chip de 3,5 mm cuadrados. Las únicas piezas externas eran un circuito resonante ajustable para sintonizar la radio a la frecuencia deseada y tan sólo 14 condensadores cerámicos, además de la fuente de alimentación y el altavoz. Solo se necesitaba una alineación. Exuberantes, el dúo patentó su creación en 1977 y la presentó al equipo corporativo de Philips poco después. La reunión no salió como se esperaba, y el grupo de fabricación de radios se opuso a seguir adelante. Ese podría haber sido el final del chip si no hubiera sido por un tercer hombre: Peter Langendam, un físico atómico y molecular que entonces dirigía una fábrica en Valvo, subsidiaria de componentes de Philips, con sede en Hamburgo. Langendam creía en la tecnología con tanta fuerza que se volvió deshonesto y trajo en secreto algunos chips de muestra de los Países Bajos a Alemania para producir algunas radios de demostración. Envió esas radios a clientes japoneses que se volvieron locos por esa tecnología, firmando pedidos por un millón de chips. El riesgo fue enorme, pero funcionó. Conociendo la respuesta del mercado japonés, Philips estaba a bordo, al igual que todos los demás. De repente, fue posible meter radios FM en, bueno, casi cualquier sitio: alarmas, reproductores de música, e incluso en gafas de sol. El TDA7000 también cambió el mundo del bricolaje de radios, lo que hizo que fuera mucho más fácil para los aficionados construir una radio FM desde cero, sin los interminable problemas con media docena de componentes para que la maldita cosa funcionara. Hasta la fecha, se han vendido más de 5 mil millones del chip TDA7000 y variantes. |

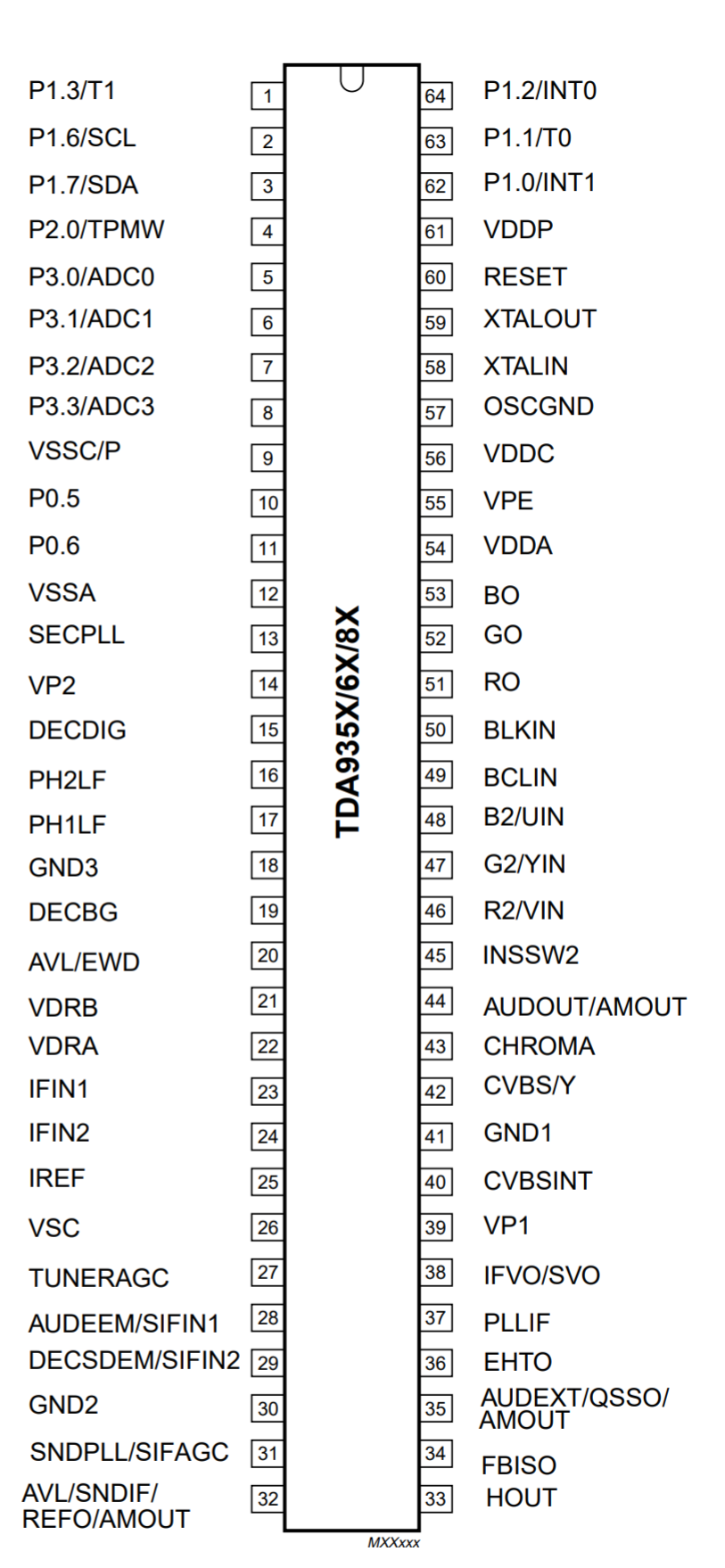

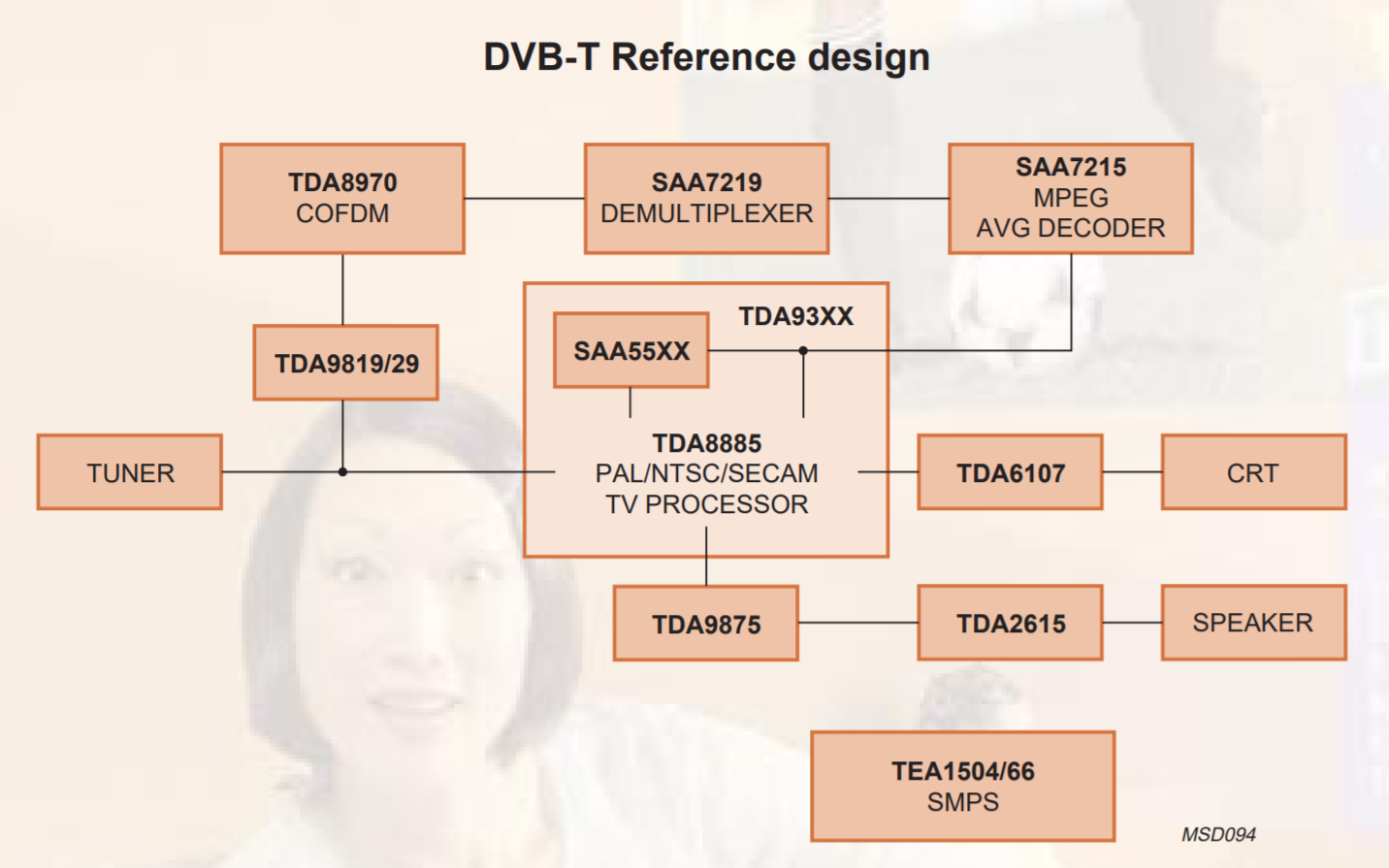

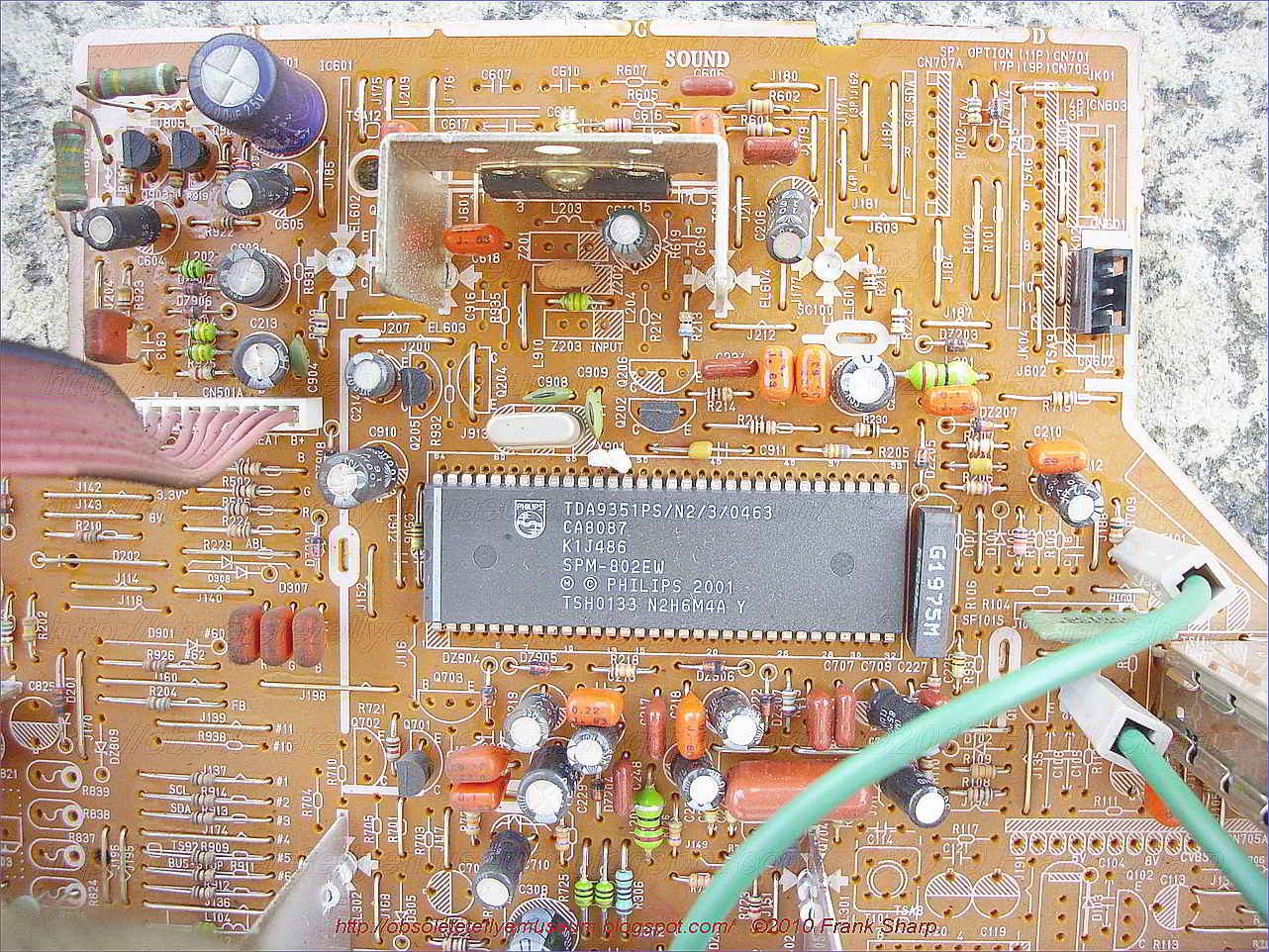

Procesador de TV Philips Semiconductors TDA93xx (1999) |

|

|

|

La gente de marketing de Philips lo llamó "el mejor procesador de TV de un chip". Los ingenieros de Philips lo llamaron TDA93xx. Era un solo chip que integraba un procesador de señal de TV, un decodificador de subtítulos y un núcleo de microcontrolador. La compañía lo logró combinando circuitos CMOS (Complementary-Metal-Oxide Semiconductor) normales con BiMOS analógico, una combinación de tecnología bipolar y CMOS. El chip admitía los tres principales estándares internacionales de televisión (PAL, NTSC y SECAM) y, al agregar un microcontrolador, Philips eliminó la necesidad de muchos otros componentes. A los fabricantes de televisores les encantaba el chip, que funcionaba bien incluso en mercados como África y China, conocidos por las peculiaridades de sus entornos de transmisión. La división de semiconductores de Philips, ahora conocida como NXP, estima que ha enviado más de 850 millones de chips TDA93xx. Y espera enviar millones más hasta que finalmente la televisión analógica desaparezca en todo el mundo gracias a este "TV on a chip". |

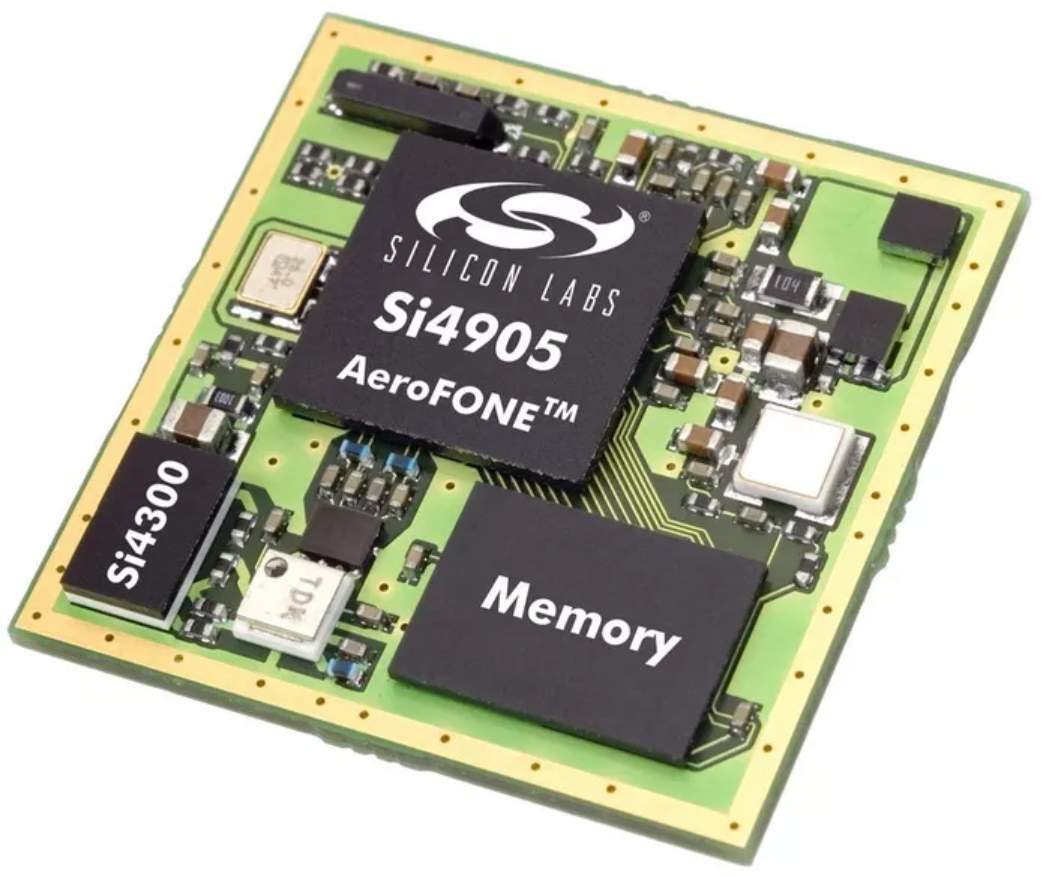

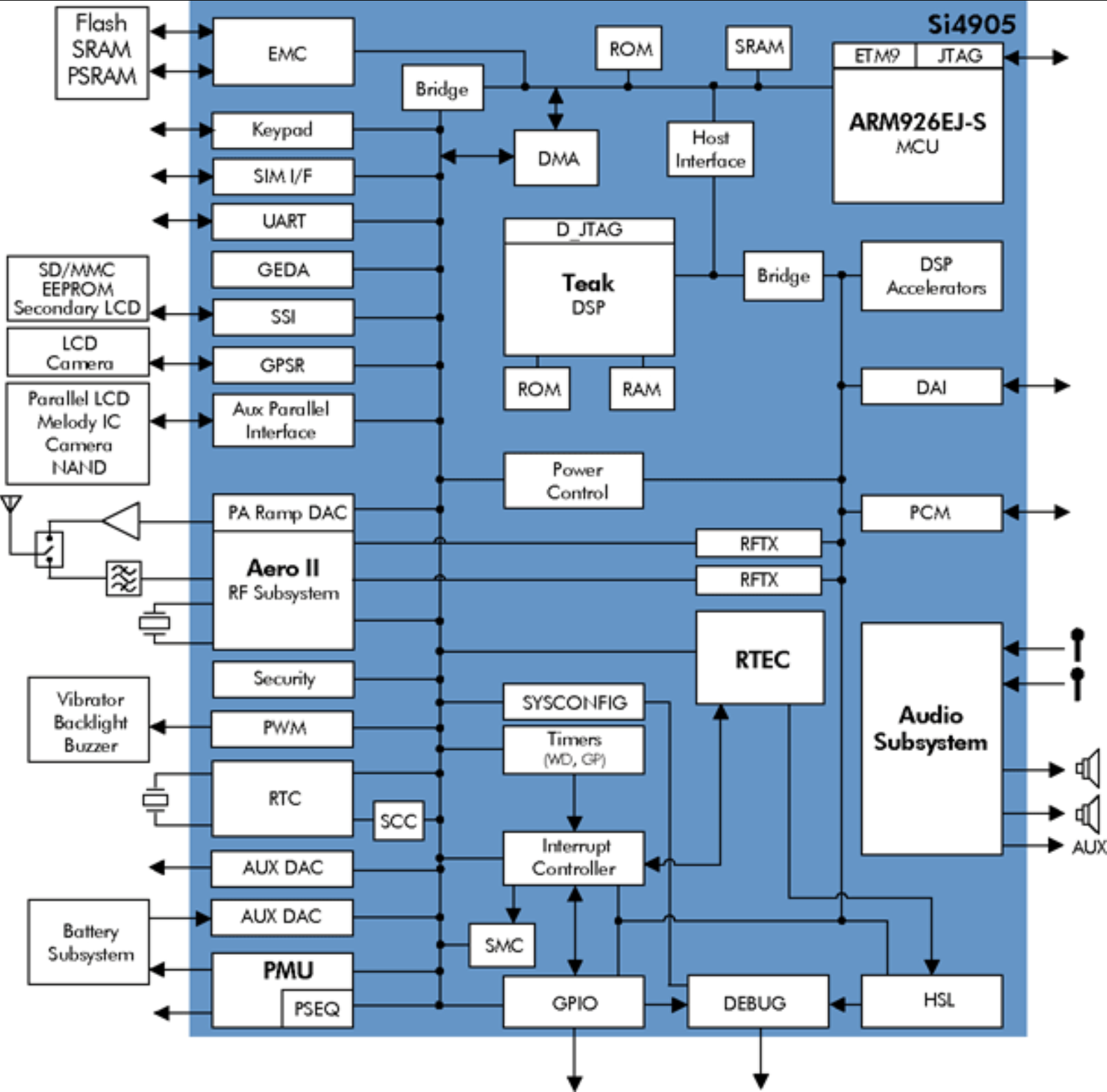

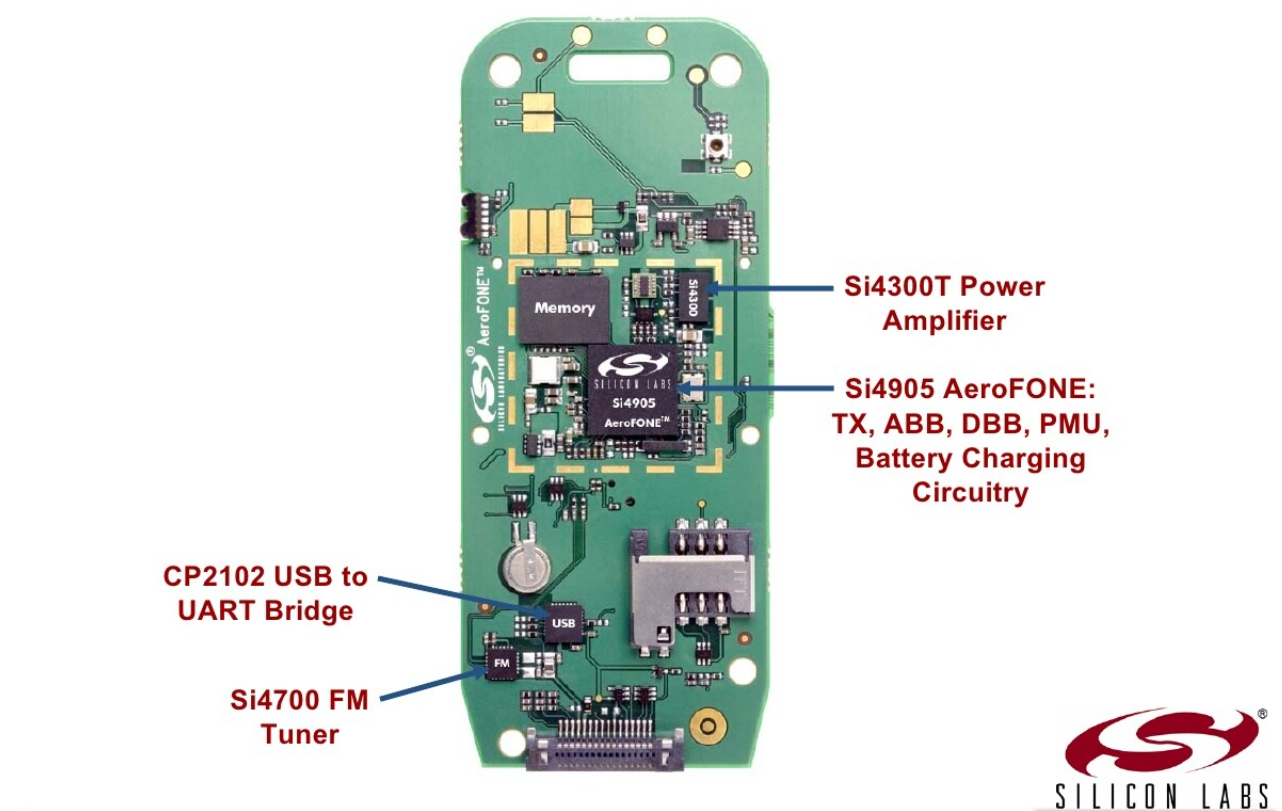

Chip de teléfono móvil GSM Silicon Laboratories Si4905 (2005) |

|

|

|

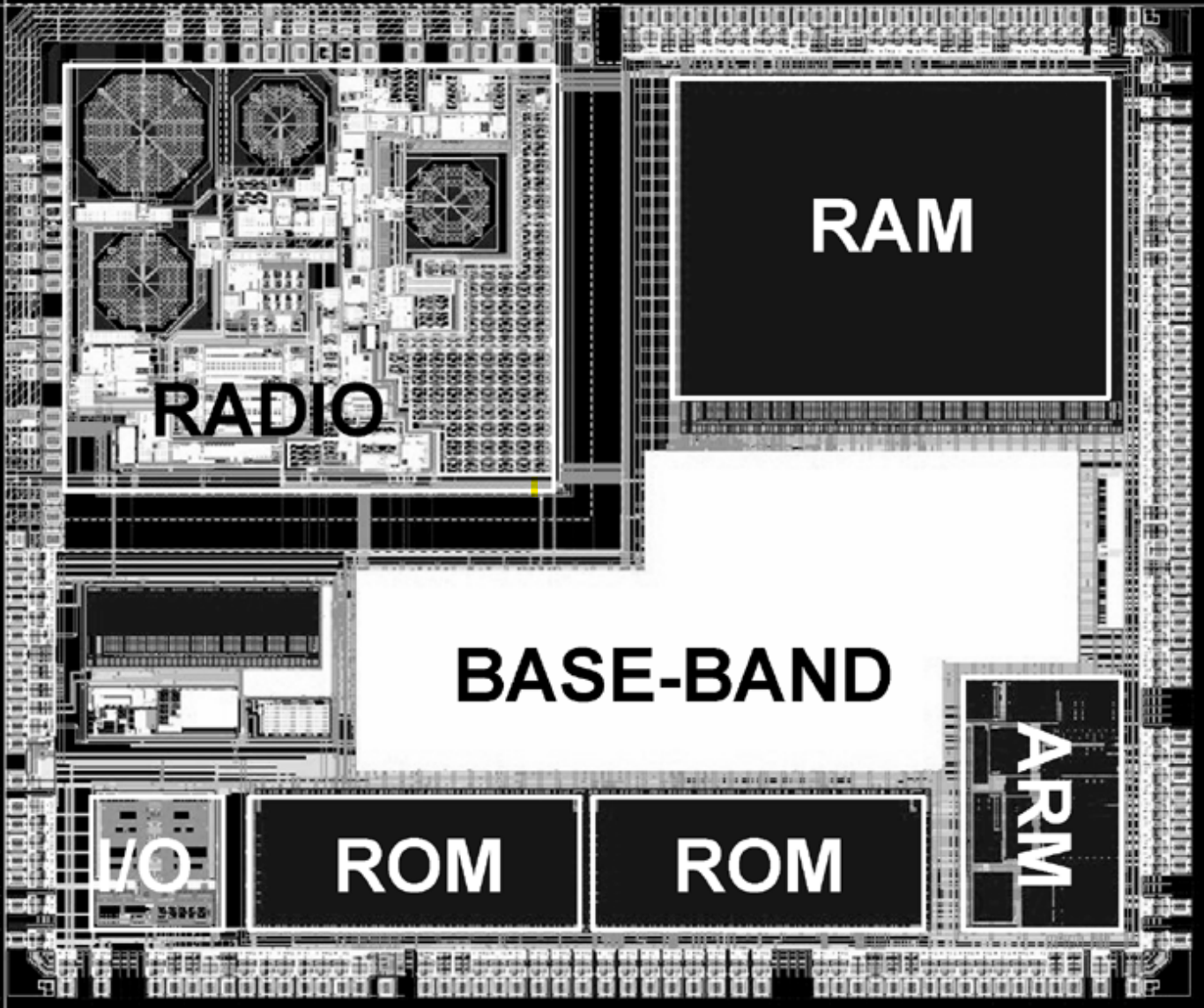

Anunciado por Silicon Laboratories en 2005, el Si4905 metió un teléfono móvil GSM completo (incluyendo la banda base digital, los circuitos de radiofrecuencia (RF), la gestión de energía y la interfaz de la batería) en aproximadamente 1 cm2 de silicio, cuando en aquellos días, un teléfono de este tipo requería habitualmente más de 200 componentes electrónicos. La parte complicada fue integrar los subsistemas de RF y digitales, ya que normalmente estaban separados y apantallados. Pero después de exhaustivas pruebas y rediseños, la empresa lo logró. En comparación con otras soluciones integradas en el mercado, el teléfono de un solo chip Si4905 redujo el número de componentes en un 75%, el área de la placa en un 65% y el coste de fabricación en hasta un 50%. A pesar de ofrecer a los fabricantes una forma fácil de producir teléfonos para usuarios finales a un coste mucho menor, Silicon Labs era simplemente demasiado pequeño para competir contra gigantes como Texas Instruments e Infineon Technologies. De hecho, nunca consiguió un cliente. En 2007, Silicon Labs vendió la línea de chips GSM a NXP, que ahora suministra el chip a Samsung, el segundo fabricante de teléfonos móviles del mundo. |

| << RetroMañía 2021 | 2 of 17 | Charla «60 años rodeados de chips» >> |

| RetroMañía 2021 | ||